Предлагается

теоретическое обоснование, методика

численных расчетов и программная реализация решения задач статистики, в

частности исследования статистических распределений, методами теории

информации. При этом непосредственно на основе эмпирических данных расчетным

путем определяется количество информации в наблюдениях, которое используется

для анализа статистических распределений. Предлагаемый способ расчета количества

информации не основан на предположениях о независимости наблюдений и их

нормальном распределении, т.е. является непараметрическим и обеспечивает

корректное моделирование нелинейных систем, а также позволяет сопоставимо

обрабатывать разнородные (измеряемые в шкалах различных типов) данные числовой

и нечисловой природы, измеряемые в различных единицах измерения. Таким образом,

АСК-анализ и система «Эйдос» представляют собой современную инновационную

(готовую к внедрению) технологию решения задач статистики методами теории

информации. Данный раздел может быть использован как описание

лабораторной работы по дисциплинам: интеллектуальные

системы; инженерия знаний и интеллектуальные системы; интеллектуальные

технологии и представление знаний; представление знаний в интеллектуальных

системах; основы интеллектуальных систем; введение в нейроматематику и методы

нейронных сетей; основы искусственного интеллекта; интеллектуальные технологии

в науке и образовании; управление знаниями; автоматизированный системно-когнитивный

анализ и интеллектуальная система «Эйдос»; которые автор ведет в настоящее

время, а также и в других дисциплинах, связанных с преобразованием данных в

информацию, а ее в знания и применением этих знаний для решения задач

идентификации, прогнозирования, принятия решений и исследования моделируемой

предметной области (а это практически все дисциплины во всех областях науки)

«... навыки мысли и аналитический аппарат

теории информации должны, по-видимому, привести к заметной перестройке здания математической

статистики»

А.Н.

Колмогоров [2,3,4]

В статистике существует проблема определения закона распределения наблюдений, а затем и

определения параметров этого распределения. Традиционно эта проблема решается путем проверки статистических гипотез, на основе

специально разработанных довольно многочисленных статистических

тестов и критериев с учетом ошибок первого и второго рода.

Эта теория детально разработана и общеизвестна. Однако

необходимо отметить, что по ряду причин на практике ей довольно редко

пользуются, а когда все же пользуются, то часто делают это некорректно. Довольно

многие просто пользуются теми или иными возможностями MS Excel или

статистических пакетов и при этом даже не задумываются, что применяемые ими

методы являются параметрическими,

т.е. существенным образом основаны

на предположении о выполнении для исследуемых наблюдений гипотезы о

нормальности распределения. Естественно они и не пытаются проверить, так ли

это. Детальный и исчерпывающий на сегодняшний день анализ причин некорректного

использования статистических технологий приведен в классической работе [1] и

здесь мы не будем на нем останавливаться. Отметим лишь, что этих причин так

много и они настолько разнообразны, что на наш взгляд ученый, собирающийся применить

статистику в своих исследованиях или при решении задач в своей области науки,

по-видимому, практически обречен на ее некорректное использование.

Общая идея решения сформулированной проблемы состоит в

предложении применить

непараметрические методы, в частности теорию

информации, для решения тех задач, которые традиционно решаются в параметрической

статистике.

Конечно, применение теории информации для решения

проблем и развития статистики не является абсолютно новой идеей. Как

указывает в своих работах [2, 3] профессор А.И.Орлов, сходные идеи развивал еще

в середине XX века С.Кульбак [4], а в эпиграф данного раздела вынесено программное

высказывание выдающегося российского математика А.Н. Колмогорова:

«... навыки мысли и аналитический аппарат теории информации должны,

по-видимому, привести к заметной перестройке

здания математической статистики», которое содержится в его предисловии к той

же книге С.Кульбака и также приведено в

работах [2, 3]. В наше время в этом направлении продуктивно работают Дуглас Хаббард

[5], а также известный российский математик, разработчик синергетической теории

информации В.Б.Вяткин [6-13].

В работе [1] в разделе «11.1. Проблема множественных проверок статистических гипотез»

профессор А.И.Орлов указывает, что регрессионный анализ является параметрическим

методом и при множественных проверках

статистических гипотез им пользоваться некорректно, т.к. однородные группы, полученные с помощью

какого-либо алгоритма классификации (кластеризации), подчиняются не нормальному

распределению, а усеченному нормальному.

Имеется определенный

положительный опыт решения поставленной проблемы путем применения теории

информации.

В статье [14] метод наименьших квадратов (МНК) широко

известен и пользуется заслуженной популярностью. Вместе с тем не прекращаются

попытки усовершенствования этого метода. Результатом одной из таких попыток

является взвешенный метод наименьших квадратов (ВМНК), суть которого в том,

чтобы придать наблюдениям вес обратно пропорциональный погрешностям их

аппроксимации. Этим самым, фактически, наблюдения игнорируются тем в большей

степени, чем сложнее их аппроксимировать. В результате такого подхода формально

погрешность аппроксимации снижается, но фактически это происходит путем

частичного отказа от рассмотрения «проблемных» наблюдений, вносящих большую

ошибку. Если эту идею, лежащую в основе ВМНК довести до крайности (и тем самым

до абсурда), то в пределе такой подход приведет к тому, что из всей

совокупности наблюдений останутся только те, которые практически точно ложатся

на тренд, полученный методом наименьших квадратов, а остальные просто будут

проигнорированы. Однако, по мнению автора, фактически это не решение проблемы,

а отказ от ее решения, хотя внешне и выглядит как решение. В работе

предлагается именно решение, основанное на теории информации: считать весом

наблюдения количество информации в аргументе о значении функции. Этот подход

был обоснован в рамках нового инновационного метода искусственного интеллекта:

метода автоматизированного системно-когнитивного анализа (АСК-анализа) и реализован

еще 30 лет назад в его программном инструментарии – интеллектуальной системе «Эйдос» в виде так называемых «когнитивных функций».

В данном разделе приводится алгоритм и программная реализация данного подхода,

проиллюстрированные на подробном численном примере.

В статье [15] кратко рассматриваются математическая

сущность предложенной автором модификации взвешенного

метода наименьших квадратов (ВМНК), в котором в качестве весов

наблюдений применяется количество информации в них. Предлагается два варианта

данной модификации ВМНК. В первом варианте взвешивание наблюдений производится

путем замены одного наблюдения с определенным количеством информации в нем

соответствующим количеством наблюдений

единичного веса, а затем к ним применяется стандартный метод

наименьших квадратов (МНК). Во втором варианте взвешивание наблюдений

производится для каждого значения аргумента путем замены всех наблюдений с

определенным количеством информации в них одним наблюдением единичного веса,

полученным как средневзвешенное от них, а затем к ним применяется стандартный

МНК. Подробно описана методика численных расчетов количества информации в

наблюдениях, основанная на теории автоматизированного системно-когнитивного

анализа (АСК-анализ) и реализованная в его программном инструментарии –

интеллектуальной системе «Эйдос». Приводится иллюстрация предлагаемого подхода

на простом численном примере.

Отметим также, что в статье [16] на небольшом численном примере рассматриваются новые

математическая модель, алгоритм и результаты агломеративной кластеризации,

основные отличия которых от ранее известных стоят в том, что: а) в них параметры

обобщенного образа кластера не вычисляются как средние от исходных объектов

(классов) или центры тяжести, а определяются с

помощью той же самой базовой когнитивной операции АСК-анализа, которая

применяется и для формирования обобщенных образов классов на основе примеров

объектов и которая действительно обеспечивает обобщение; б) в качестве критерия

сходства используется не евклидово расстояние или его варианты, а интегральный

критерий неметрической природы: «суммарное количество информации», применение

которого теоретически корректно и дает хорошие результаты в неортонормированных

пространствах, которые обычно и встречаются на практике; в) кластерный анализ

проводится не на основе исходных переменных или матрицы сопряженности,

зависящих от единиц измерения по осям, а в когнитивном пространстве, в котором

по всем осям (описательным шкалам) используется одна единица измерения:

количество информации, и поэтому результаты кластеризации не зависят от

исходных единиц измерения признаков объектов. Имеется и ряд других менее

существенных отличий. Все это позволяет получить результаты кластеризации,

понятные специалистам и поддающиеся содержательной интерпретации, хорошо

согласующиеся с оценками экспертов, их опытом и интуитивными ожиданиями, что

часто представляет собой проблему для классических методов кластеризации. Описанные

методы теоретически обоснованы в системно-когнитивном анализе (СК-анализ) и

реализованы в его программном инструментарии – интеллектуальной системе «Эйдос».

Таким образом, в работах автора [14, 15 и

16] по сути, намечается путь решения проблемы построения непараметрического

регрессионного анализа, основанного на теории информации, в том числе и для его

применения в относительно однородных группах, полученных путем когнитивной

кластеризации.

Задача № 1:

проверка статистических гипотез.

По сути, эта задача является частным вариантом задачи распознавания образов,

т.к. в ней по первичным и вторичным (расчетным) признакам наблюдений необходимо

определить вид статистического распределения и его параметры. А теория

информации хорошо позволяет решать подобные задачи распознавания, в том числе и

в условиях зашумленности исходных данных.

Задача № 2: исследование влияния уровня системности

действующих на объекты наблюдения факторов на степень отклонения статистического

распределения их характеристик от нормального. Данная задача тесно связана с системным обобщением

математики, в частности системной теорией информации, которые были предложены

автором в ряде работ [см., например: 17, 35, 36]. Решение этой задачи может заложить

основы системного обобщения статистики (системной статистики) в результате

применения идей системного обобщения математики в статистике. Эта задача тесно

связана с Центральными предельными теоремами

(ЦПТ) или законом больших чисел теории

вероятностей, утверждающих, что сумма достаточно большого количества слабо

зависимых случайных величин, имеющих примерно одинаковые масштабы (ни одно из

слагаемых не доминирует, не вносит в сумму определяющего вклада), имеет

статистическое распределение, стремящееся (сходящееся) к нормальному распределению.

С позиций системного обобщения математики независимые зависимые случайные

величины представляют собой множество случайных величин. Если же

между ними есть зависимости, то их уже нельзя (вернее можно, но это

некорректно) рассматривать как множество и более адекватным является

представление о них, как о системе

случайных величин [17]. Система имеет эмерджентные свойства, которых не было

у ее элементов и эти свойства тем ярче выражены, чем выше уровень системности.

Автором предложено несколько разных вариантов коэффициентов эмерджентности, которые

представляют собой количественные информационные меры уровня системности и

степени детерминированности систем.

Система факторов влияет на систему не так, так как их сумма, т.е. нелинейно. В

результате статистическое распределение системы случайных величин отклоняется

от нормального тем в большей степени, чем выше уровень системности и нелинейность.

Таким образом, вся параметрическая статистика описывает только линейные

системы, а для нелинейных систем она является неадекватной. Отметим, что к

нелинейным системам, имеющим высокий уровень системности и ярко выраженные

эмерджентные (синергетические) свойства, относятся все живые системы,

искусственные и естественные экосистемы, биоценозы, системы с участием людей

(социально-экономические, психологические, культурные, политические), вообще

все сложные и большие системы.

Задача № 3: нахождение

информативных подмножеств признаков в регрессионном анализе и в

автоматизированных системах управления. Данная задача сформулирована

профессором А.И.Орловым в работе [1] следующим образом: «…в большинстве важных

для практики случаев статистические свойства процедур анализа данных,

основанных на множественных проверках, остаются пока неизвестными. Примерами

являются процедуры нахождения информативных подмножеств признаков (коэффициенты

для таких и только таких признаков отличны от 0) в регрессионном анализе или выявления

отклонений параметров в автоматизированных системах управления». Решение этой

задачи давно (еще в 1979 году) предложено автором в теории АСК-анализа и

реализовано в его программном инструментарии – интеллектуальной системе «Эйдос»

и представляет собой базовую когнитивную операцию «Абстрагирование» [18]. Это

решение основано на использовании вариабельности количества информации в

значении аргумента (в признаке) о значении функции (классе) в качестве меры

информативности (ценности, дискриминантной, дифференцирующей способности)

данного значения аргумента (признака), т.е. его полезности для различения

классов.

Задача № 4: "стыковка"

статистических процедур. Данная задача также сформулирована профессором

А.И.Орловым в работе [1]: «Проблема

множественных проверок статистических гипотез – часть более общей проблемы

"стыковки" (сопряжения) статистических процедур. Дело в том, что

каждая процедура может применяться лишь при некоторых условиях, а в результате

применения предыдущих процедур эти условия могут нарушаться». Решению очень

сходной задачи посвящен АСК-анализ, в котором с единых позиций теории

информации рассматривается полная необходимая и достаточная система

(конфигуратор) базовых когнитивных операций [19, 20, 21]. По сути можно

сказать, что грандиозное здание статистики построено без единого плана, т.е. не

системно, и в результате отдельные его конструкции не всегда гармонично

сочетаются друг с другом и не образуют единого целого. Можно, конечно,

попытаться все это упорядочить и расписать на языке непосвященных, а также

снабдить их программным инструментарием, но эта задача в настоящее время,

похоже, никем не ставится. Автор предлагает другое, как это ни парадоксально,

но возможно более простое решение: не реформировать старое, а построить рядом

новое здание системной статистики и сделать это по единому проекту, единой теоретической

и методологической основе теории информации. По крайней мере, в совершенно

аналогичной ситуации с автоматизацией системного анализа второй вариант решения

оказался более эффективным, чем другие [19]. В частности оказалось

возможным создать и единую систему, основанную на этой единой теоретической и

металогической основе теории информации: интеллектуальную систему «Эйдос». Это

вселяет надежду на решение проблемы, о которой в работе [1] профессор А.И.Орлов

писал: «Математическая статистика

демонстрирует … виртуозную математическую технику для анализа частных случаев и

полную беспомощность при выдаче практических рекомендаций».

Задача № 5: конструирование системной информационной

меры взаимосвязи двух векторов, аналогичной коэффициенту корреляции. Это сделано в АСК-анализе и реализовано в системе

«Эйдос» и описано автором в монографии [37] еще в 1996 году в режиме «Содержательное сравнение двух классов».

Суть идеи состоит в том, что:

а) при расчете коэффициента корреляции учитываются не

сами значения аргумента, а количество информации о значениях функции, которое в

них содержится;

б) учитываются не только вклад в сходство-различие

значений аргумента с одинаковыми индексами, но и все их сочетания.

Разумеется, этим перечень задач статистики, которые на

взгляд автора могли бы быть решены с методами теории информации, в частности

АСК-анализа и системы «Эйдос», далеко не исчерпывается. Конечно, здесь

возникает естественный вопрос о том, какие вообще задачи статистики могут быть

решены с помощью теории информации. На это вопрос можно было бы ответить другим

вопросом: «А какие задачи статистики не могут быть решены с помощью теории

информации?» На наш взгляд любая

наука, а не только статистика, в процессе исследования и как его результат

получает определенную информацию об объекте исследования. Поэтому теория

информации в определенном смысле является метанаукой имеющей не меньшую

общность, чем философия, но в отличие от нее являющаяся естественной

высокоматематизированной наукой, имеющей свой программный инструментарий. Даже

мысленный эксперимент Альберта Эйнштейна с движущимся поездом и источниками

света на платформе, на основе которого в теории относительности формируется

представление об одновременности и времени, фактически является не более чем

описанием системы передачи информации в пространстве-времени с помощью световых

сигналов. Даже когда мы узнаем, чему равен предел функции или интеграл, то даже

если мы об этом и не знаем, то все равно на самом деле мы тоже получаем об этом

информацию, количество которой можно посчитать и выразить в битах. Поэтому

любая задача в любой области науки требует для своего решения практического

применения теории информации, которое чаще осуществляется всего неосознанно и

на качественном уровне. АСК-анализ и его программный инструментарий – система

«Эйдос», реализованная в универсальной постановке, не зависящей от предметной

области, позволяют осуществить это на осознанном уровне.

Задача № 6: исследование информационных моделей

статистических распределений. Решение

этой задачи включает кластерный и конструктивный анализ распределений, их

информационные портреты и многие другие исследования с использованием

возможностей АСК-анализа и системы «Эйдос» [21].

Далее в данном разделе кратко рассмотрим возможный

вариант применения теории информации для получения определенной информации о

статистическом распределении наблюдений. Это можно рассматривать как подготовку

к решению сформулированной выше задачи №1 и некоторых других

сформулированных задач.

Данная идея состоит в том, чтобы рассматривать статистические

распределения как когнитивные функции. Это открывает перспективы

использования теории информации для анализа функций, в т.ч. и статистических

распределений.

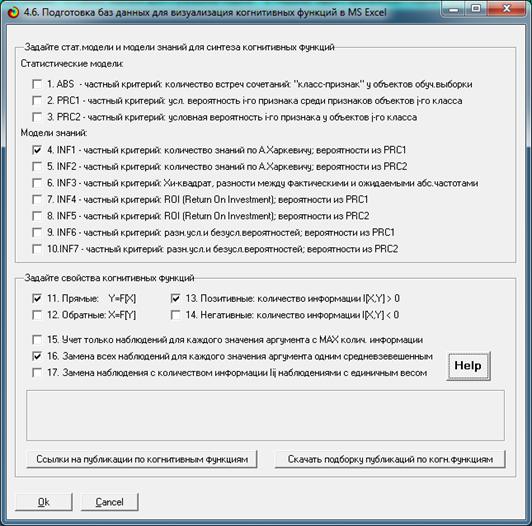

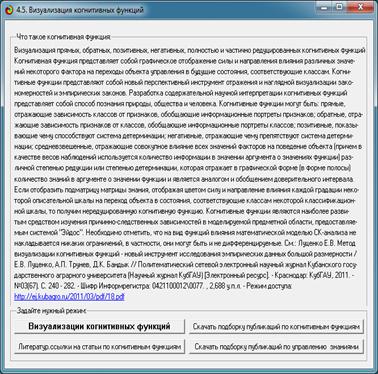

В АСК-анализе предложено новое понятие когнитивных функций, которое

рассмотрено и развито в ряде работ автора и соавторов [17, 22–34] и поэтому

здесь нет смысла подробно останавливаться на этом понятии. Отметим лишь суть. В

работе [17] кратко рассматриваются классическое понятие функциональной

зависимости в математике, определяются ограничения применимости этого понятия

для адекватного моделирования реальности и формулируется проблема, состоящая в

поиске такого обобщения понятия функции, которое было бы более пригодно для

адекватного отражения причинно-следственных связей в реальной области. Далее

рассматривается теоретическое и практическое решения поставленной проблемы,

состоящие в том, что:

а) предлагается универсальный не зависящий от

предметной области способ вычисления количества информации в значении аргумента

о значении функции, т.е. когнитивные функции;

б) предлагается программный инструментарий:

интеллектуальная система «Эйдос», позволяющая на практике осуществлять эти

расчеты, т.е. строить когнитивные функции на основе фрагментированных зашумленных

эмпирических данных большой размерности.

Предлагаются понятия нередуцированных, частично и

полностью редуцированных прямых и обратных, позитивных и негативных когнитивных

функций и метод формирования редуцированных когнитивных функций, являющийся

вариантом известного взвешенного метода наименьших квадратов, отличающимся от

стандартного ВМНК учетом в качестве весов

наблюдений количества информации в

значениях аргумента о значениях функции.

Идея применения теории информации для исследования

статистических распределений проста и базируется на двух вполне очевидных предпосылках.

Предпосылка № 1. Любое исследование, в т.ч. исследование статистических распределений,

представляет собой процесс получения информации об объекте исследования. Этот

процесс включает: источник информации, канал передачи информации и получатель

информации, т.е. представляет собой информационно-измерительную систему.

Поэтому применение теории информации для построения такой системы является

совершенно естественным и очевидным.

Предпосылка № 2. Понятия «Информация» и

«Статистического распределение» тесно взаимосвязаны. Широко известен

хрестоматийный пример определения количественной меры информации Хартли через

понятие равномерного распределения случайной величины: количество информации I=Log2N по Хартли равно

количеству информации, которое мы получаем, когда узнаем, что равномерно

распределенная случайная величина попала в некоторый определенный i-й интервал: один из N равных интервалов. На подобных

соображениях основан известный метод Монте-Карло. В работах [35, 36] предложено

развитие этих идей с использованием классической статистики Больцмана, также ее

квантовых обобщений статистик Ферми-Дирака и Бозе-Эйнтштейна. Оказалось, что

эти статистики математически тесно связаны с системным обобщением теории информации,

предложенным автором.

В данной

работе ставится задача дать ответ на несколько простых вопросов:

Вопрос 1-й. Какое количество информации о принадлежности случайной величины к

нескольким нормальным распределениям с разными параметрами мы получаем, когда

узнаем, что она попала в некоторый определенный i-й интервал: один из N

равных интервалов?

Вопрос 2-й. Какое суммарное количество информации о степени сходства эмпирического

распределения наблюдений с нормальными распределениями с различными параметрами

мы получаем, зная частоты попадания случайной величины в каждый из интервалов

при N равных интервалов?

Вопрос 3-й. Попадание случайной величины в какие интервалы при N равных интервалах является более

характерным и в какие менее характерным для нормальных распределений с

различными параметрами?

Для ответа на эти вопросы нам потребуется

универсальный не зависящий от предметной области способ вычисления количества

информации в наблюдениях, который мы рассмотрим ниже.

Ниже в наиболее упрощенном виде приводится методика

численных расчетов количества информации в наблюдениях, основанная на теории

автоматизированного системно-когнитивного анализа (АСК-анализ) и реализованная

в его программном инструментарии – интеллектуальной системе «Эйдос» [21].

Для удобства рассмотрения введем следующие

обозначения:

i – индекс значения аргумента;

j – индекс значения функции;

M – количество значений аргумента;

W – количество значений функции;

Nij

– количество встреч j-го значения функции при

i-м значении аргумента;

– суммарное количество наблюдений при i-м

значении аргумента по всей выборке;

– суммарное количество наблюдений при i-м

значении аргумента по всей выборке;

– суммарное количество наблюдений j-го значении функции по всей

выборке;

– суммарное количество наблюдений j-го значении функции по всей

выборке;

– суммарное количество наблюдений по всей

выборке;

– суммарное количество наблюдений по всей

выборке;

Iij

– количество информации в i-м значении аргумента о том, что функция имеет j-е значение, т.е. это количество

информации в наблюдении (i, j);

Ψ –

нормировочный коэффициент (Е.В.Луценко, 1979), преобразующий количество

информации в формуле А.Харкевича в биты и обеспечивающий для нее соблюдение

принципа соответствия с формулой Р.Хартли в равновероятном детерминистском

случае;

– безусловная относительная частота встречи i-го значения аргумента в обучающей

выборке;

– безусловная относительная частота встречи i-го значения аргумента в обучающей

выборке;

Pij – условная относительная частота встречи

j-го значения функции при i-м

значении аргумента.

Используя исходную выборку эмпирических наблюдений

посчитаем матрицу абсолютных частот (таблица 1):

Таблица 1 – МАТРИЦА АБСОЛЮТНЫХ ЧАСТОТ

|

|

Классы

|

Сумма

|

|

1

|

...

|

j

|

...

|

W

|

|

Значения

факторов

|

1

|

|

|

|

|

|

|

|

...

|

|

|

|

|

|

|

|

i

|

|

|

|

|

|

|

|

...

|

|

|

|

|

|

|

|

M

|

|

|

|

|

|

|

|

Суммарное

количество

признаков

|

|

|

|

|

|

|

Алгоритм формирования матриц абсолютных частот и

условных и безусловных процентных распределений.

Объекты обучающей выборки описываются векторами

(массивами)  имеющихся у них

признаков:

имеющихся у них

признаков:

Первоначально в матрице абсолютных частот все значения

равны нулю. Затем организуется цикл по объектам обучающей выборки. Если у

предъявленного объекта, относящегося к j-му

классу, есть i-й признак, то:

(1)

(1)

На основе анализа матрицы частот (табл. 1) классы

можно сравнивать по наблюдаемым частотам признаков только в том случае, если

количество объектов по всем классам одинаково, как и суммарное

количество признаков по классам. Если же они отличаются, то корректно

сравнивать классы можно только по условным и безусловным относительным частотам

(оценкам вероятностей) наблюдений признаков, посчитанных на основе матрицы

частот (табл. 1) в соответствии с выражениями (2), в результате чего

получается матрица условных и безусловных процентных распределений (табл. 2):

|

|

((2)

|

Таблица 2 – МАТРИЦА УСЛОВНЫХ И

БЕЗУСЛОВНЫХ

ПРОЦЕНТНЫХ РАСПРЕДЕЛЕНИЙ

|

|

Классы

|

Безусловная

вероятность

признака

|

|

1

|

...

|

j

|

...

|

W

|

|

Значения

факторов

|

1

|

|

|

|

|

|

|

|

...

|

|

|

|

|

|

|

|

i

|

|

|

|

|

|

|

|

...

|

|

|

|

|

|

|

|

M

|

|

|

|

|

|

|

|

Безусловная

вероятность

класса

|

|

|

|

|

|

|

Далее произведем расчет количества информации в наблюдениях в соответствии

с выражением (3):

|

|

(3)

|

С

учетом (2) преобразуем (3) к виду (4):

|

|

(4)

|

|

А.А.Харкевич

|

Здесь  – упрощенная форма

коэффициента эмерджентности А.Харкевича (10), предложенный автором в 1979

году и названный так в честь известного советского ученого, внесшего большой

вклад в теорию информации, на работах которого основана излагаемая методика

численных расчетов количества информации в наблюдениях. – упрощенная форма

коэффициента эмерджентности А.Харкевича (10), предложенный автором в 1979

году и названный так в честь известного советского ученого, внесшего большой

вклад в теорию информации, на работах которого основана излагаемая методика

численных расчетов количества информации в наблюдениях.

|

|

|

(5)

|

Используя выражения (3) и (5) на основе таблицы 2

рассчитывается матрицу информативностей

(таблица 3). Она также может быть получена :непосредственно из таблицы 1 с

использованием выражений (4) и (5):

Таблица 3 – МАТРИЦА ИНФОРМАТИВНОСТЕЙ

|

|

Классы

|

Значимость

фактора

|

|

1

|

...

|

j

|

...

|

W

|

|

Значения

факторов

|

1

|

|

|

|

|

|

|

|

...

|

|

|

|

|

|

|

|

i

|

|

|

|

|

|

|

|

...

|

|

|

|

|

|

|

|

M

|

|

|

|

|

|

|

|

Степень

редукции

класса

|

|

|

|

|

|

|

Здесь –  это среднее

количество информации в i-м значении

фактора:

это среднее

количество информации в i-м значении

фактора:

Когда количество информации Iij > 0 – i-й фактор

способствует переходу объекта управления в j-е состояние, когда Iij < 0 –

препятствует этому переходу, когда же Iij = 0 – никак не влияет на это. В

векторе i-го фактора (строка матрицы информативностей) отображается, какое

количество информации о переходе объекта управления в каждое из будущих

состояний содержится в том факте, что данный фактор действует. В векторе j-го

состояния класса (столбец матрицы информативностей) отображается, какое количество

информации о переходе объекта управления в соответствующее состояние содержится

в каждом из факторов.

Таким образом, данная модель позволяет рассчитать,

какое количество информации содержится в любом факте о наступлении любого события

в любой предметной области, причем для этого не требуется повторности этих

фактов и событий. Если данные повторности осуществляются и при этом наблюдается

некоторая вариабельность значений факторов, обуславливающих наступление тех или

иных событий, то модель обеспечивает многопараметрическую типизацию, т.е.

синтез обобщенных образов классов или категорий наступающих событий с количественной

оценкой степени и знака влияния на их наступление различных значений факторов.

Причем эти значения факторов могут быть как количественными, так и

качественными и измеряться в любых единицах измерения, в любом случае в модели

оценивается количество информации, которое в них содержится о наступлении

событий, переходе объекта управления в определенные состояния или, просто, о

его принадлежности к тем или иным классам. Другие способы метризации приведены

в работе [20].

Ниже на простом численном примере

мы кратко рассмотрим технологию, позволяющую на практике и в любой предметной

области посчитать, какое количество информации содержится в наблюдении. В связи

с ограничениями на объем статьи автор не имеет возможности полностью раскрыть все позиции на приведенных ниже

скриншотах и рисунках, т.е. фактически предполагается некоторое предварительное

знакомство читателя с системой «Эйдос». Если же такое знакомство недостаточно

полное, то автор отсылает автора к публикациям в списке литературы и к сайту: http://lc.kubagro.ru/.

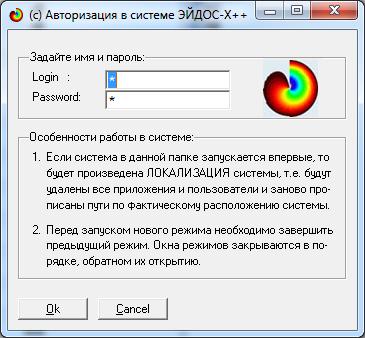

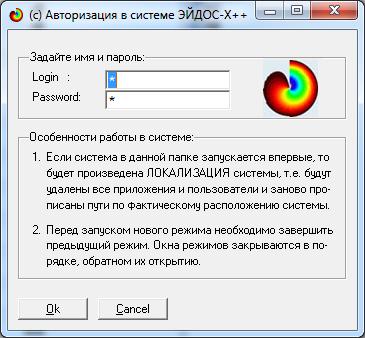

Скачиваем и устанавливаем систему «Эйдос». Это наиболее полная на данный

момент незащищенная от несанкционированного копирования портативная (portable)

версия системы (не требующая инсталляции) с исходными текстами, находящаяся

в полном открытом бесплатном доступе (около 50 Мб). Обновление

имеет объем около 3 Мб.

ИНСТРУКЦИЯ

по скачиванию и установке системы «Эйдос» (объем около 50 Мб)

|

Система не требует инсталляции, не меняет никаких системных

файлов и содержимого папок операционной системы,

т.е. является портативной (portable)

программой. Но чтобы она работала необходимо аккуратно выполнить следующие

пункты.

1. Скачать самую новую на текущий момент версию системы «Эйдос-Х++»

по ссылкам:

http://lc.kubagro.ru/a.rar или: http://lc.kubagro.ru/Aidos-X.exe (ссылки для обновления системы даны в режиме

6.2).

2. Разархивировать этот архив в любую папку с правами на запись

с коротким латинским именем и путем доступа,

включающим только папки с такими же именами (лучше всего в корневой каталог

какого-нибудь диска).

3. Запустить систему. Файл запуска:  _AIDOS-X.exe * _AIDOS-X.exe *

4. Задать имя: 1 и пароль: 1 (потом их можно поменять в режиме

1.2).

5. Перед тем как запустить новый режим НЕОБХОДИМО ЗАВЕРШИТЬ предыдущий

(Help можно не закрывать). Окна закрываются в порядке, обратном порядку их

открытия.

|

|

* Разработана программа: « _START_AIDOS.exe»,

полностью снимающая с пользователя системы «Эйдос-Х++» заботу о проверке

наличия и скачивании обновлений. Эту программу надо просто скачать по ссылке: http://lc.kubagro.ru/Install_Aidos-X/_START_AIDOS.exe ,

поместить в папку с исполнимым модулем системы и всегда запускать систему с

помощью этого файла. _START_AIDOS.exe»,

полностью снимающая с пользователя системы «Эйдос-Х++» заботу о проверке

наличия и скачивании обновлений. Эту программу надо просто скачать по ссылке: http://lc.kubagro.ru/Install_Aidos-X/_START_AIDOS.exe ,

поместить в папку с исполнимым модулем системы и всегда запускать систему с

помощью этого файла.

При

запуске программы _START_AIDOS.EXE система Эйдос не должна быть запущена,

т.к. она содержится в файле обновлений и при его разархивировании возникнет

конфликт, если система будет запущена.

1. Программа  _START_AIDOS.exe определяет дату

системы Эйдос в текущей папке, и дату обновлений на FTP-сервере не скачивая

их, и, если система Эйдос в текущей папке устарела, скачивает обновления.

(Если в текущей папке нет исполнимого модуля системы Эйдос, то программа

пытается скачать полную инсталляцию системы, но не может этого сделать из-за

ограниченной функциональности демо-версии библиотеки Xb2NET.DLL). _START_AIDOS.exe определяет дату

системы Эйдос в текущей папке, и дату обновлений на FTP-сервере не скачивая

их, и, если система Эйдос в текущей папке устарела, скачивает обновления.

(Если в текущей папке нет исполнимого модуля системы Эйдос, то программа

пытается скачать полную инсталляцию системы, но не может этого сделать из-за

ограниченной функциональности демо-версии библиотеки Xb2NET.DLL).

2. После

этого появляется диалоговое окно с сообщением, что надо сначала

разархивировать систему, заменяя все файлы (опция: «Yes to All» или

«OwerWrite All»), и только после этого закрыть данное окно.

3. Потом программа  _START_AIDOS.exe запускает

обновления на разархивирование. После окончания разархивирования окно

архиватора с отображением стадии процесса исчезает. _START_AIDOS.exe запускает

обновления на разархивирование. После окончания разархивирования окно

архиватора с отображением стадии процесса исчезает.

4. После

закрытия диалогового окна с инструкцией (см. п.2), происходит запуск

обновленной версии системы Эйдос на исполнение.

Для работы программы  _START_AIDOS.exe необходима

библиотека: Xb2NET.DLL, которую можно скачать по ссылке: http://lc.kubagro.ru/Install_Aidos-X/Xb2NET.DLL .

Перед первым запуском этой программы данную библиотеку необходимо скачать и

поместить либо в папку с этой программой, а значит и исполнимым

модулем системы «Эйдос-Х++», либо в любую другую папку, на которую в

операционной системе прописаны пути поиска файлов, например в папку:

c:\Windows\System32\. Эта библиотека стоит около 500$ и у меня ее нет,

поэтому я даю только бесплатную демо-версию, которая выдает сообщение об

ограниченной функциональности, но для наших целей ее достаточно. _START_AIDOS.exe необходима

библиотека: Xb2NET.DLL, которую можно скачать по ссылке: http://lc.kubagro.ru/Install_Aidos-X/Xb2NET.DLL .

Перед первым запуском этой программы данную библиотеку необходимо скачать и

поместить либо в папку с этой программой, а значит и исполнимым

модулем системы «Эйдос-Х++», либо в любую другую папку, на которую в

операционной системе прописаны пути поиска файлов, например в папку:

c:\Windows\System32\. Эта библиотека стоит около 500$ и у меня ее нет,

поэтому я даю только бесплатную демо-версию, которая выдает сообщение об

ограниченной функциональности, но для наших целей ее достаточно.

|

|

Лицензия:

Автор отказывается от какой бы то ни было

ответственности за последствия применения или не применения Вами системы

«Эйдос».

Проще говоря, пользуйтесь если понравилось, а

если не понравилось – сотрите и забудьте, а лучше вообще не скачивайте.

|

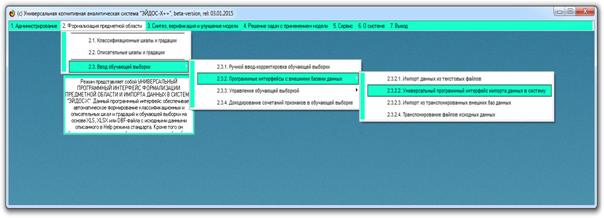

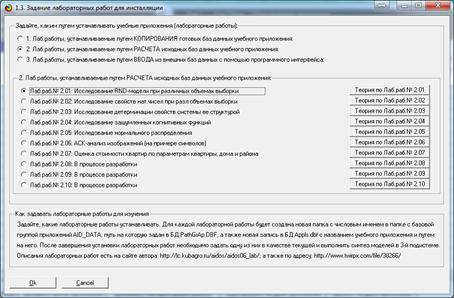

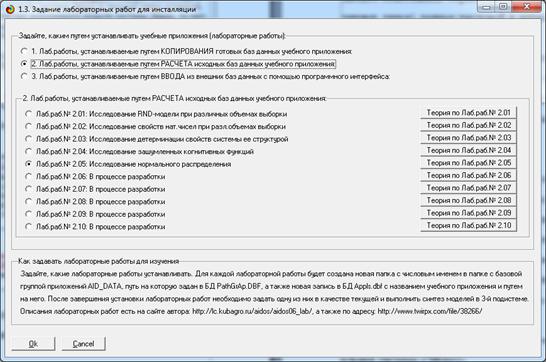

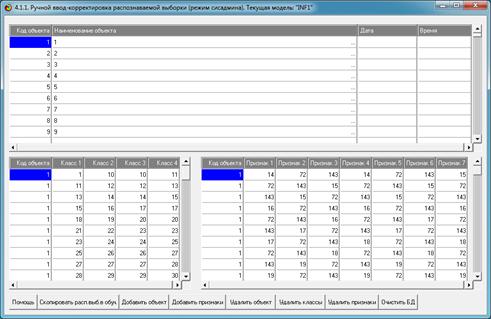

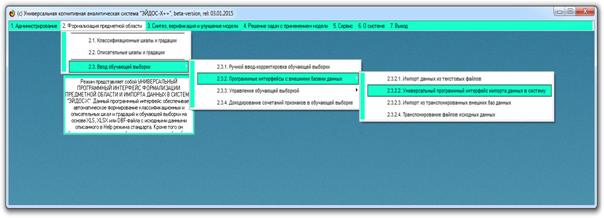

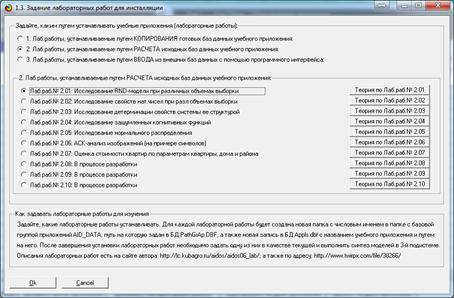

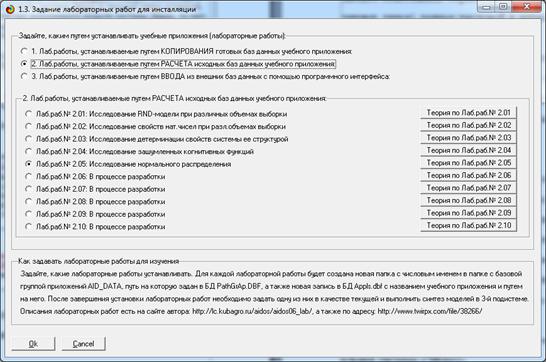

В

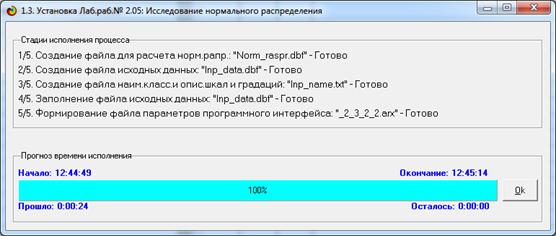

диспетчере приложений системы «Эйдос» (режим 1.3) кликаем по кнопке «Добавить учебное

приложение» и выбираем лабораторную работу 2.05 «Исследование нормального

распределения» (рисунок 1):

Рисунок 1 – Выбор режима инсталляции лабораторной

работы

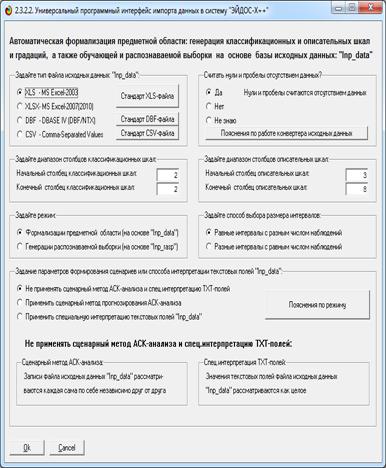

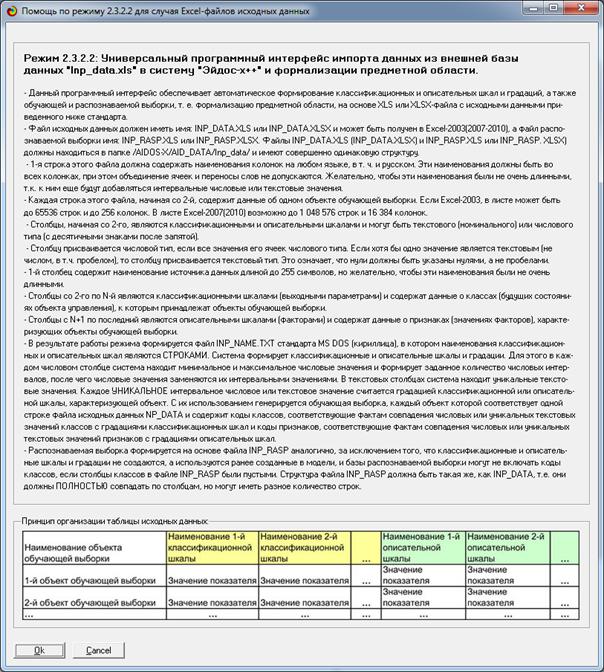

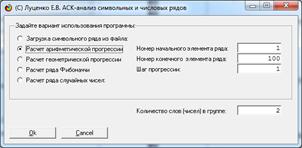

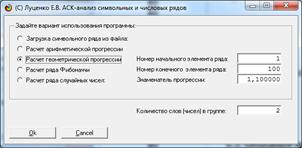

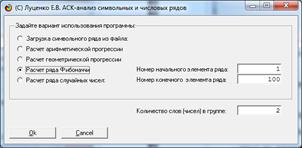

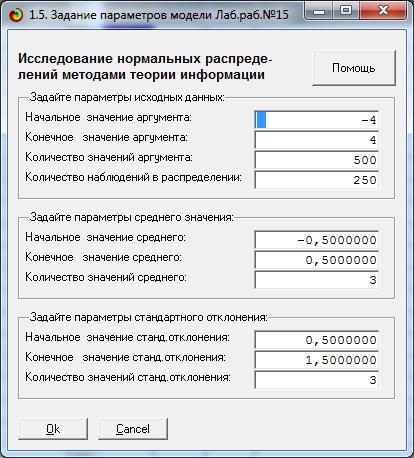

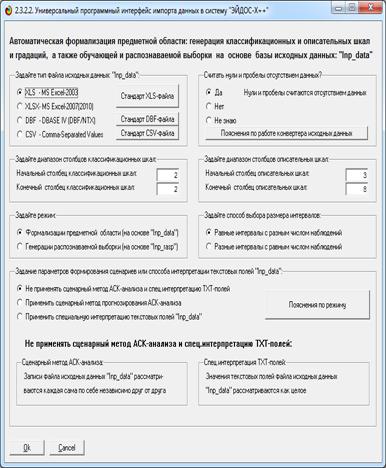

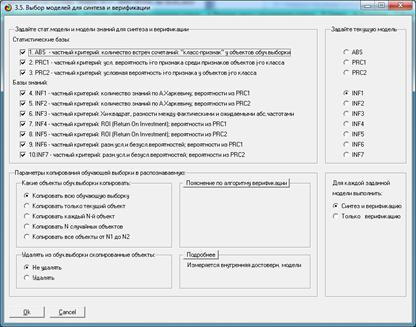

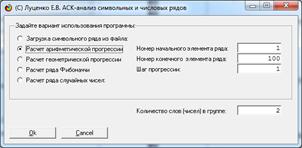

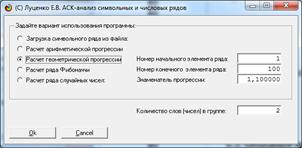

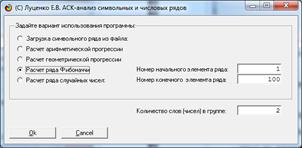

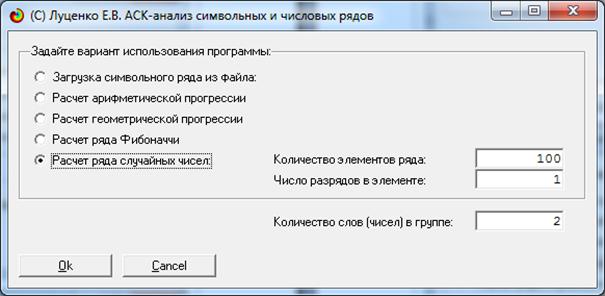

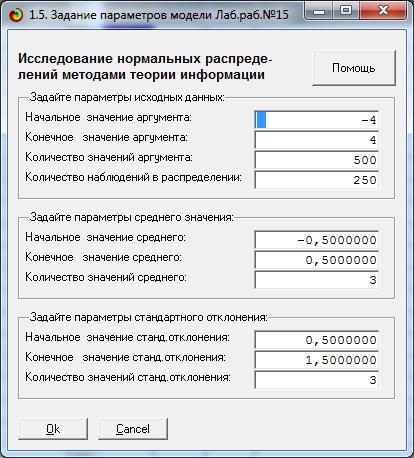

На экранной форме (рисунок 2) задаем параметры

создаваемых распределений случайной величины:

Рисунок 2 – Экранная форма задания параметров

генерируемых распределений

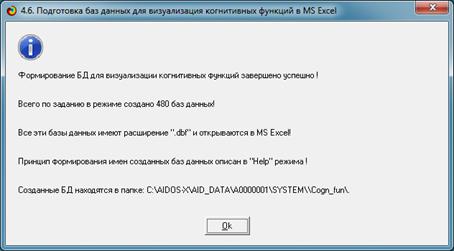

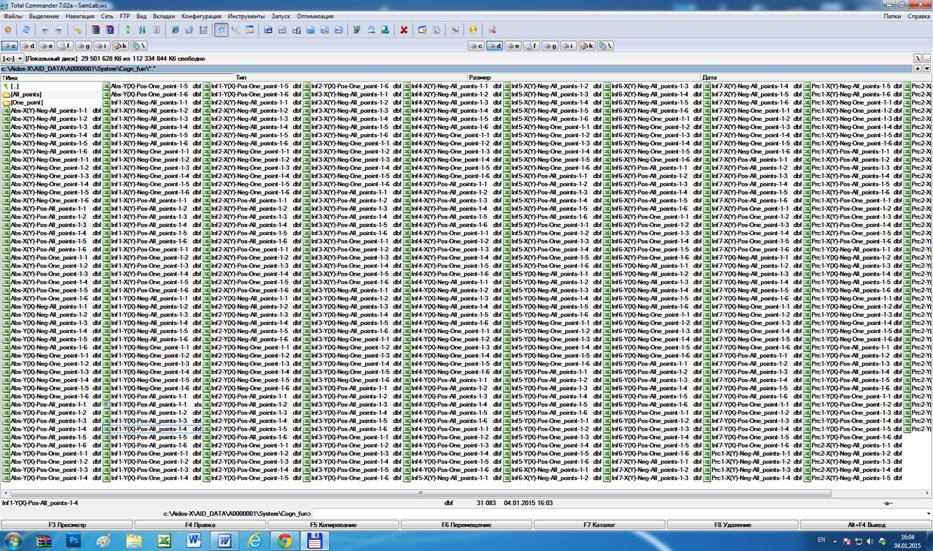

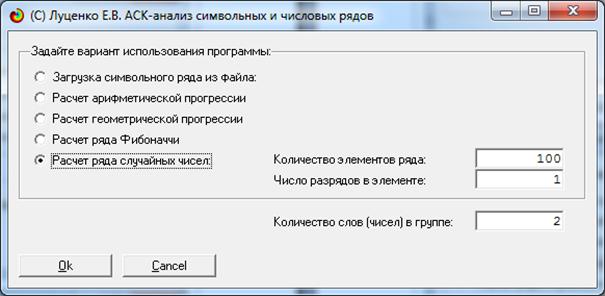

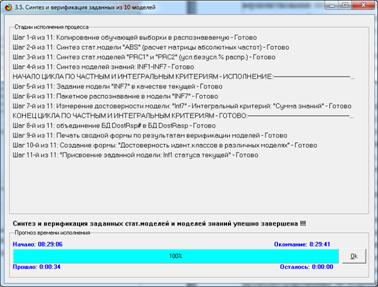

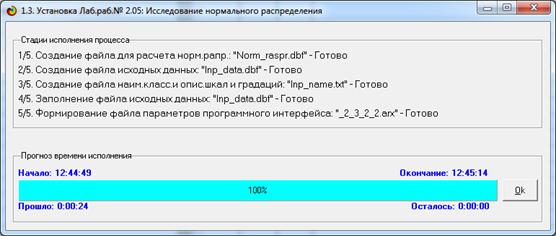

Этапы генерации распределений приведены на рисунке 3:

Рисунок 3 – Экранная форма отображения стадии процесса

генерации

исследуемых распределений случайной величины

В результате созданы следующие распределения (рисунок

4), отличающиеся сочетаниями параметров

среднего и стандартного отклонения, заданными в режиме, экранная форма которого

приведена на рисунке 2:

Рисунок 4. Исследуемые нормальные распределения,

полученные при

различных сочетаниях параметров среднего и стандартного отклонения

В таблице 1 приведены параметры созданных нормальных

распределений (на рисунке 4 и в таблице 1 выделено стандартное нормальное распределение

со средним значением 0 и стандартным отклонением 1):

Таблица 1 – Параметры созданных нормальных распределений

|

|

GAUSS

1-1

|

GAUSS

1-2

|

GAUSS

1-3

|

GAUSS

2-1

|

GAUSS

2-2

|

GAUSS

2-3

|

GAUSS

3-1

|

GAUSS

3-2

|

GAUSS

3-3

|

|

Среднее

|

-0,50

|

-0,50

|

-0,50

|

0,00

|

0,00

|

0,00

|

0,50

|

0,50

|

0,50

|

|

Ст.отклонение

|

0,50

|

1,00

|

1,50

|

0,50

|

1,00

|

1,50

|

0,50

|

1,00

|

1,50

|

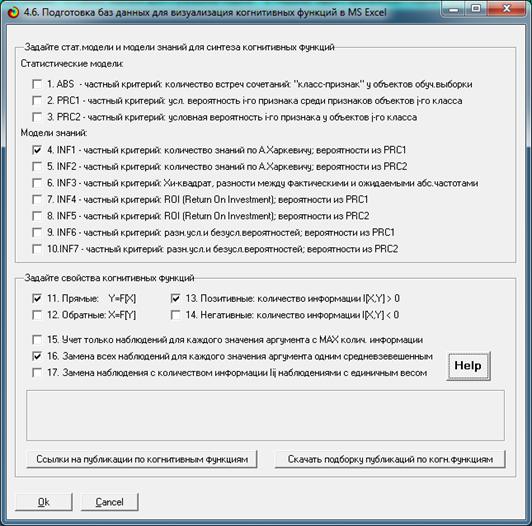

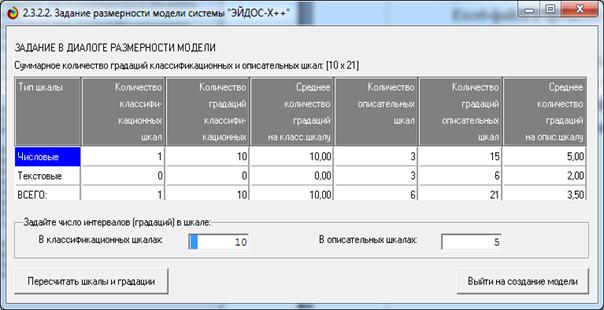

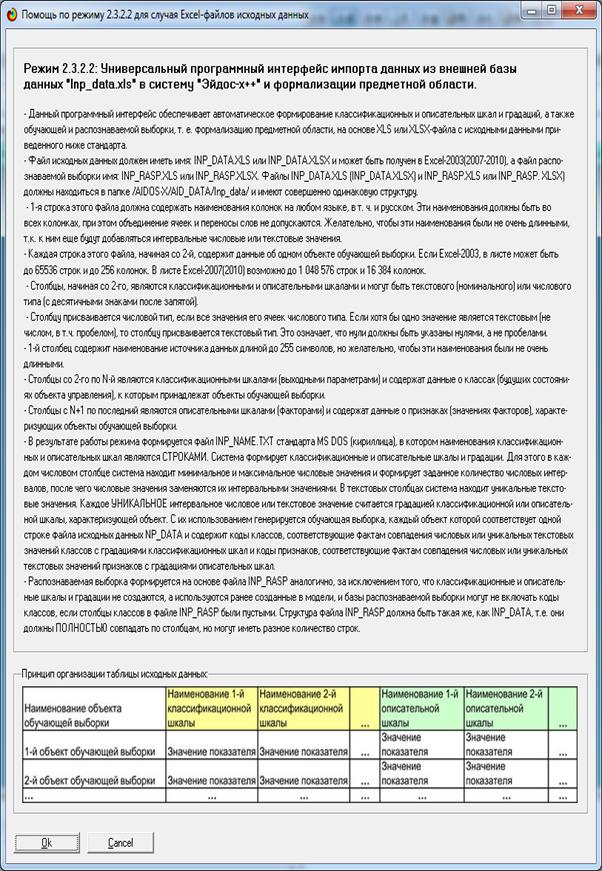

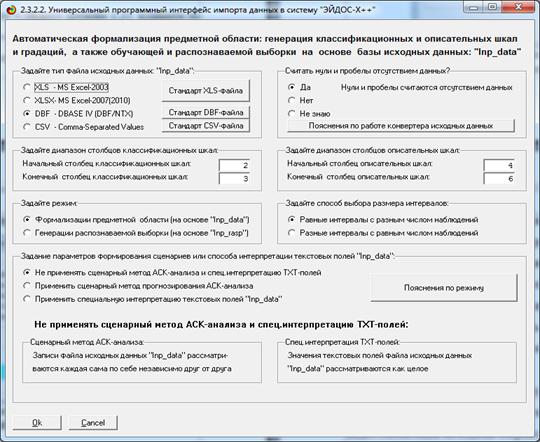

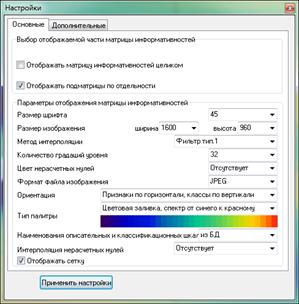

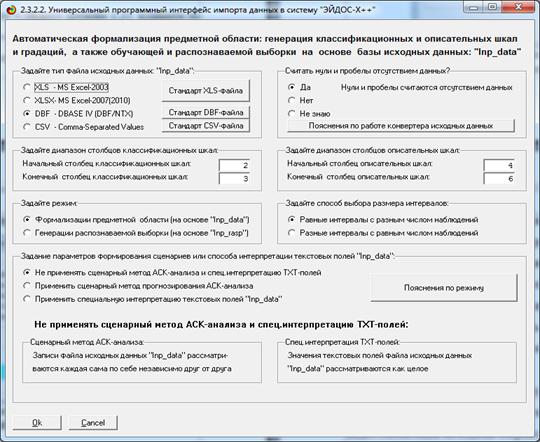

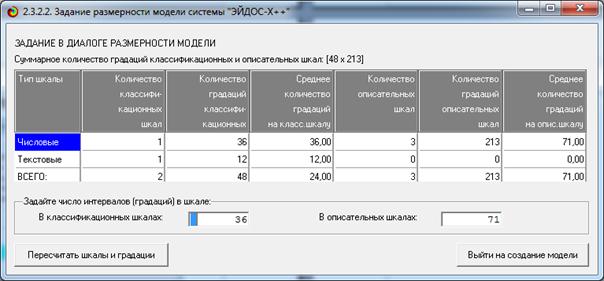

На рисунке 5 приведена экранная форма задания

параметров генерации интервальных моделей, формируемые по умолчанию:

Рисунок 5 – Экранная форма задания параметров

генерации

интервальных моделей, формируемых по умолчанию

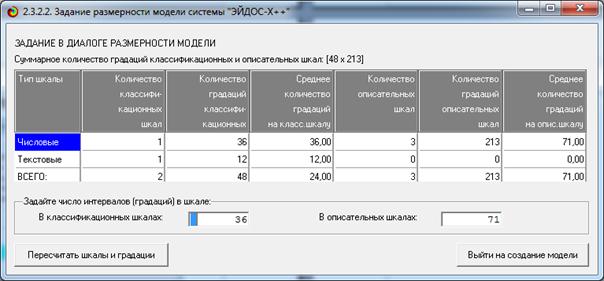

На рисунке 6 приведен внутренний калькулятор

параметров интервальных моделей:

Рисунок 6 – Экранная форма внутреннего калькулятора

параметров интервальных моделей

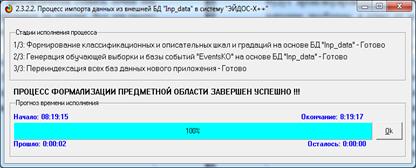

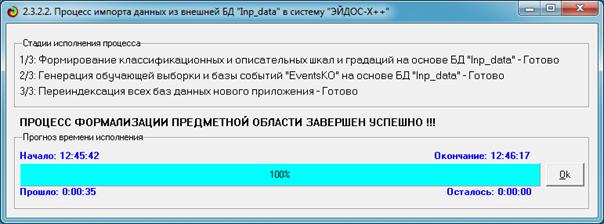

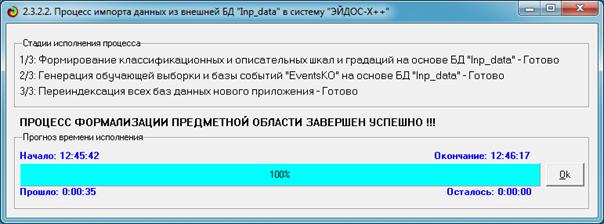

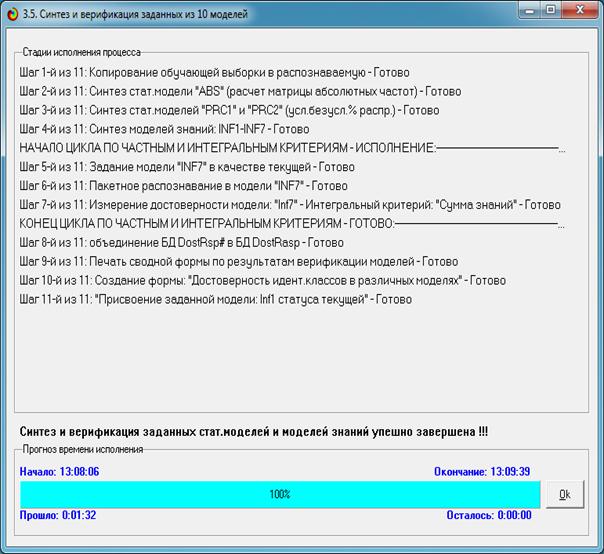

На рисунке 7 приведена форма отображения стадии

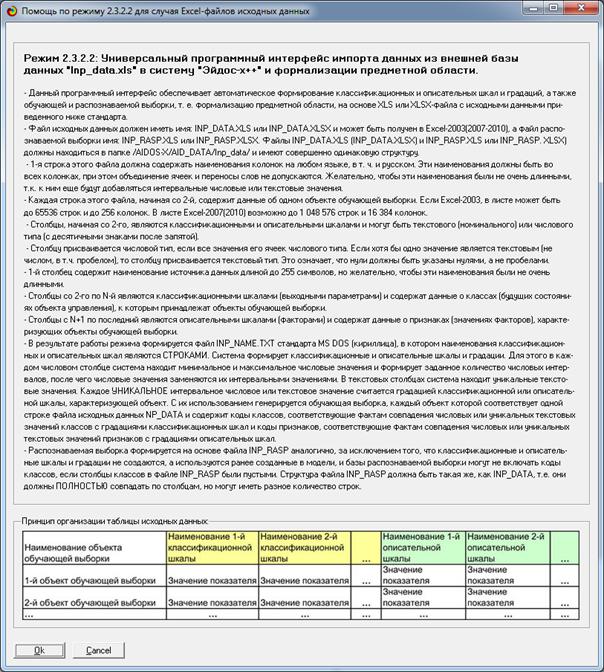

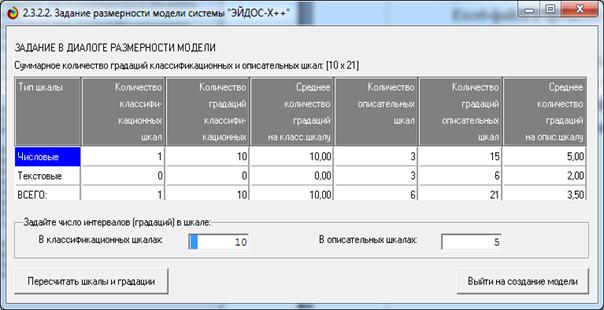

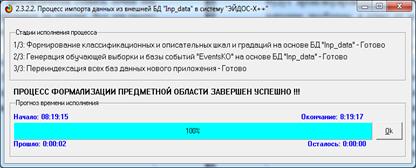

процесса импорта исходных данных интервальных моделей:

Рисунок 7 – Экранная форма отображения стадии процесса

импорта исходных данных интервальных моделей

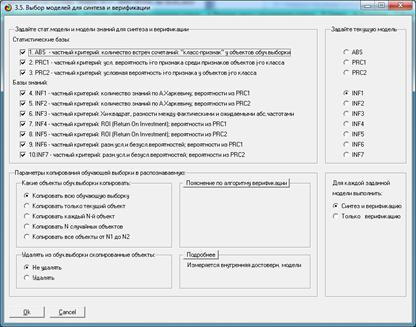

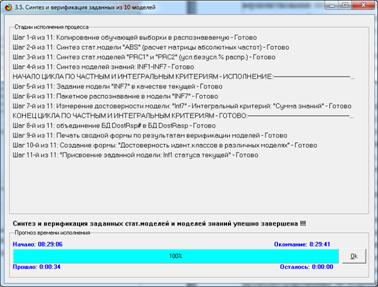

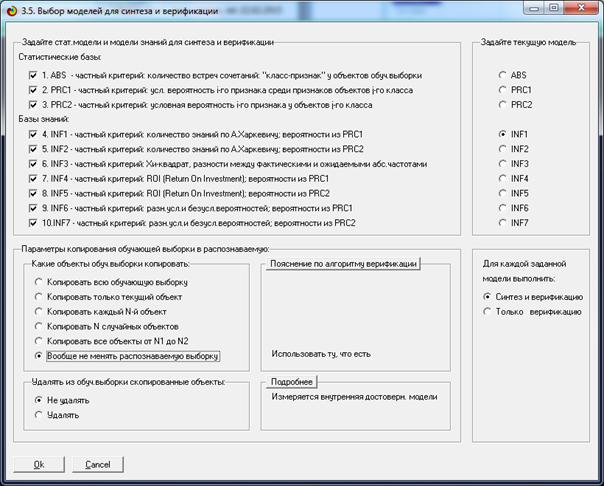

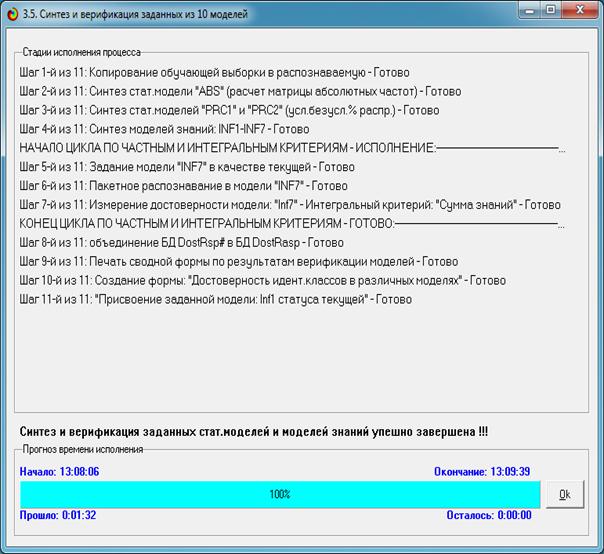

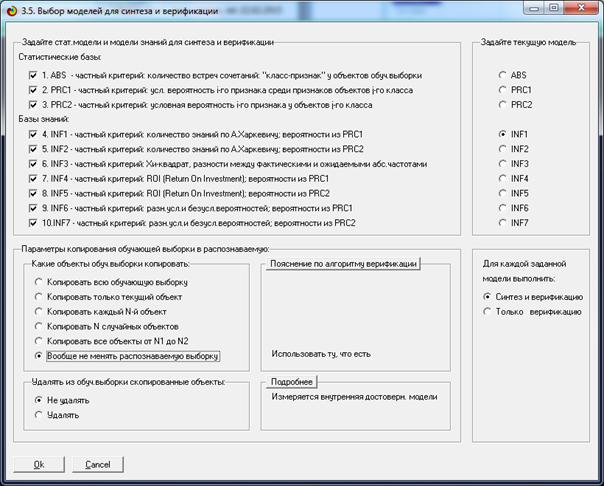

На рисунке 8 приведена экранная форма задания

параметров расчета статистических и информационных интервальных моделей, а на

рисунке 8 – стадии процесса их расчета:

Рисунок 8 – Экранная форма задания параметров расчета

статистических и информационных интервальных моделей

Рисунок 9 – Экранная форма отображения стадии расчета

статистических и информационных интервальных моделей

Обращаем внимание на то, что в экранной форме на

рисунке 8 установлена опция: «Вообще не менять распознаваемую выборку». Это

сделано потому, что распознаваемая выборка сформирована ранее при генерации

нормальных распределений и отличается от обучающей выборки.

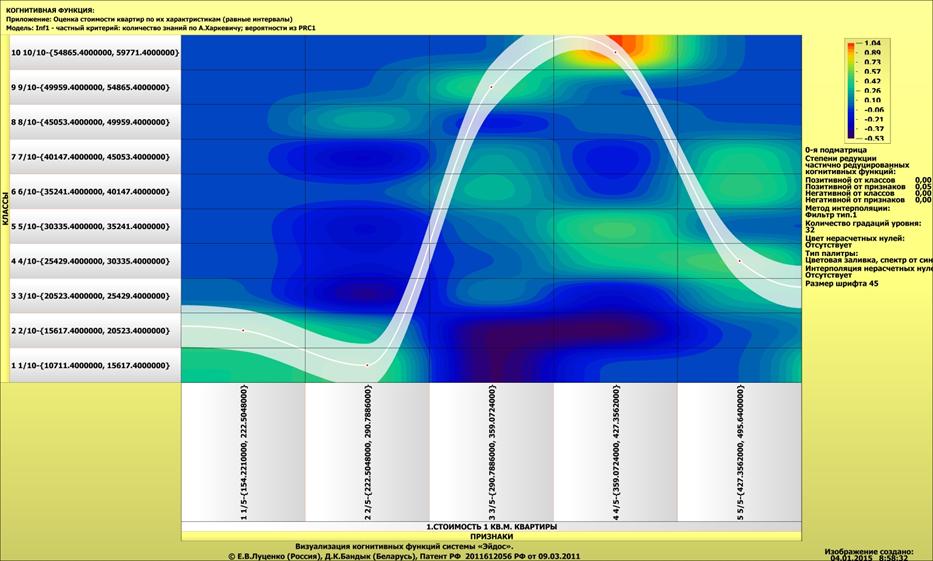

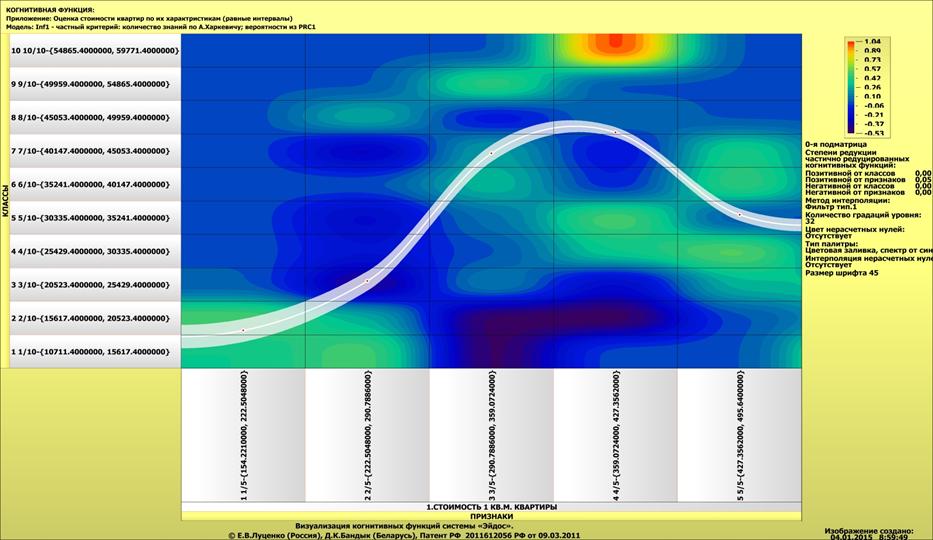

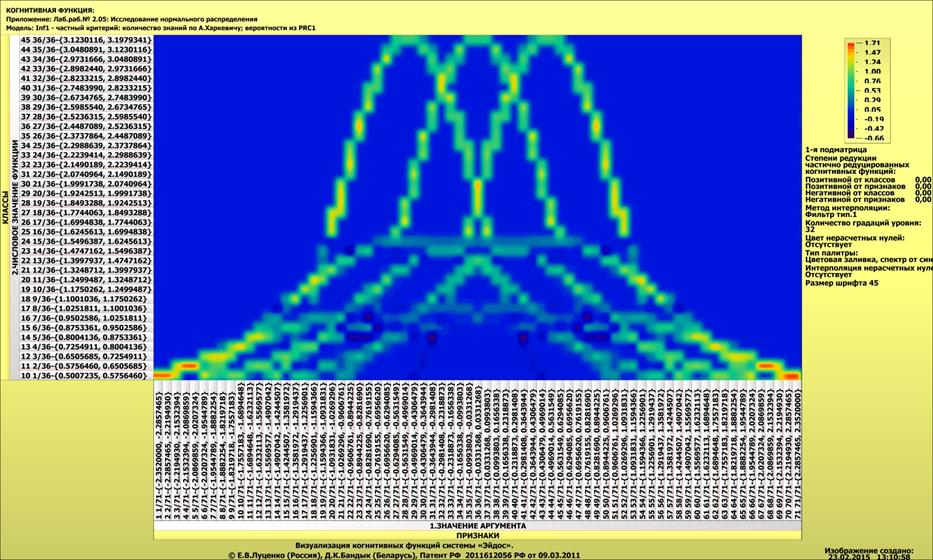

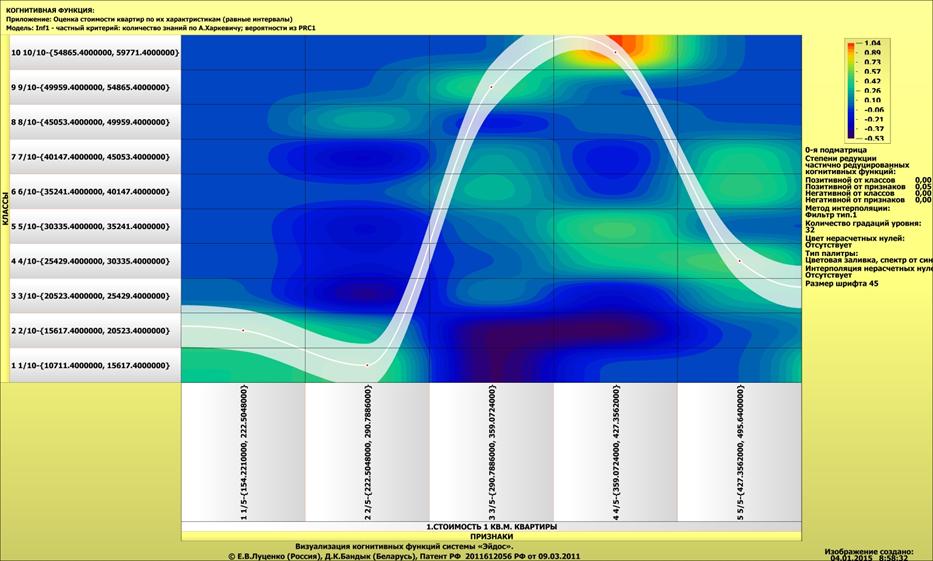

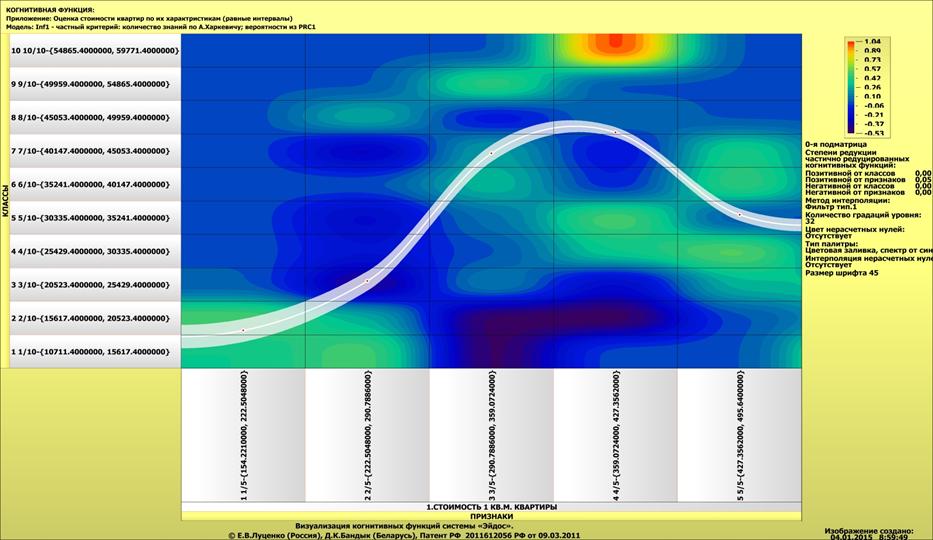

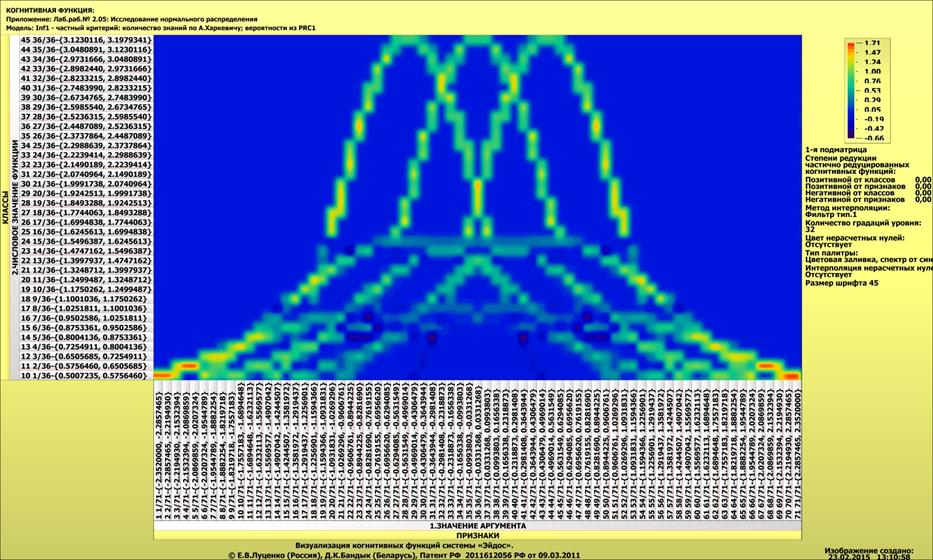

Полученные статистические распределения отображаются в

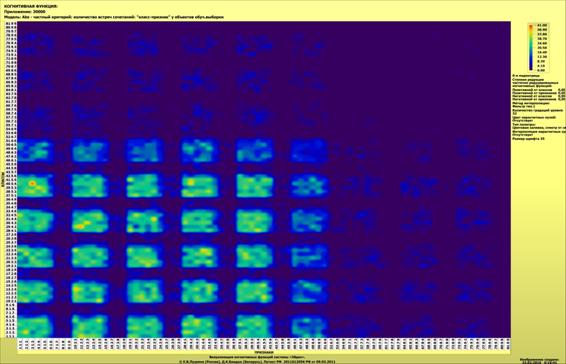

виде когнитивных функций (рисунок 10):

Рисунок 10 – Визуализация статистических распределений

в виде когнитивных функций

Из экранной формы, представленной на рисунке 11, мы видим,

что в различных интервальных значениях аргумента содержится различное количество

информации о значениях функции статистического распределения. Таким образом, мы

получили ответ на первый вопрос, ответ на который хотели получить в статье: «Вопрос

1-й. Какое количество информации о принадлежности случайной величины к

нескольким нормальным распределениям с разными параметрами мы получаем, когда

узнаем, что она попала в некоторый определенный i-й интервал: один из N равных

интервалов?»

Но система «Эйдос» позволяет получить ответ на этот

вопрос в самых разнообразных формах, которых очень много, например, в форме инвертированных

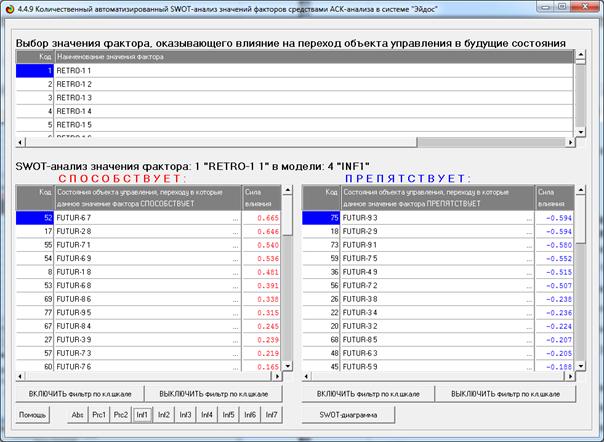

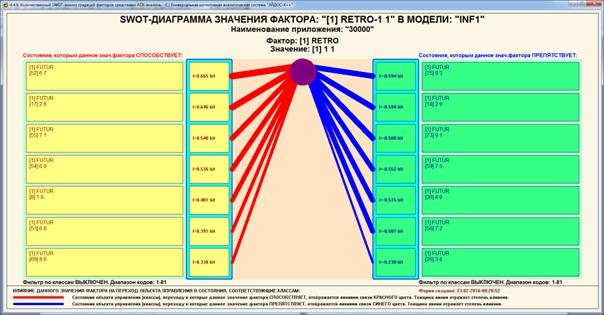

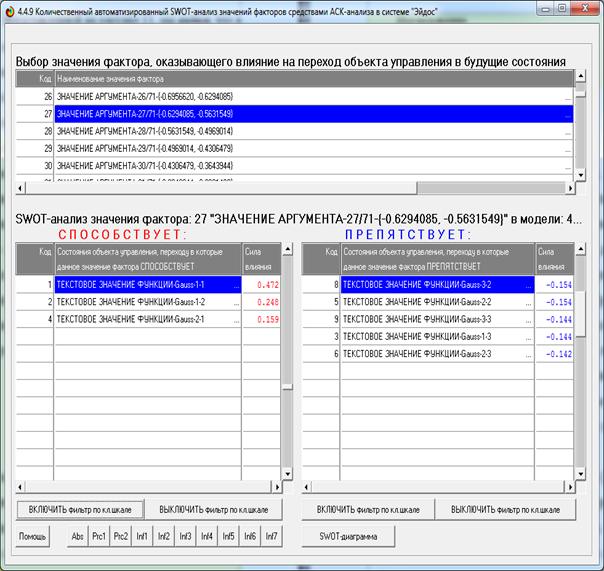

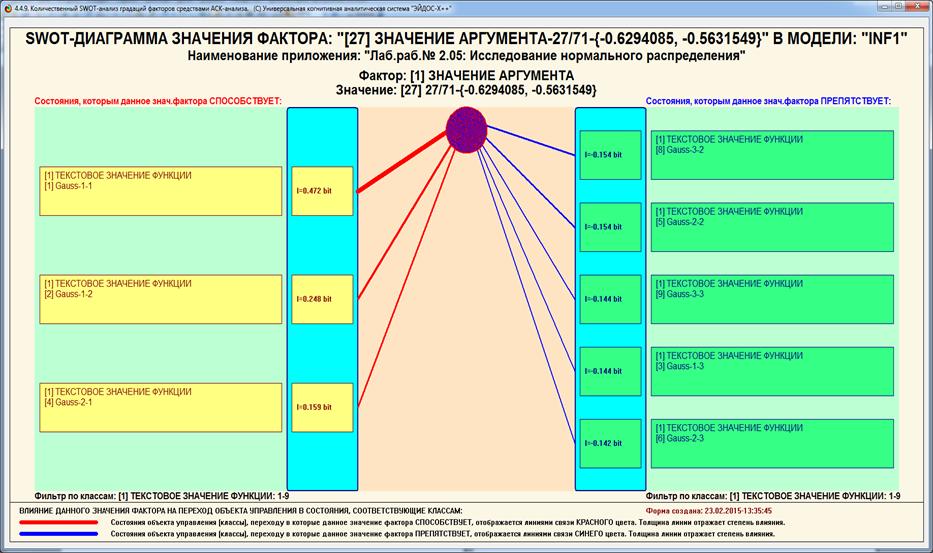

SWOT-диаграмм (предложены автором в работе [38]). Экранная форма

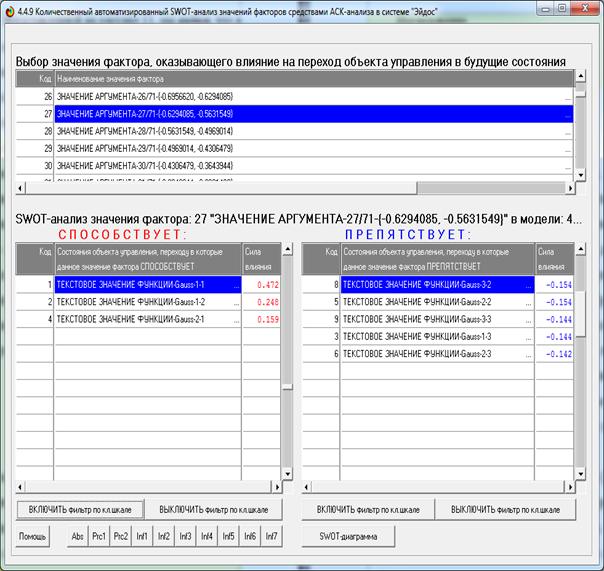

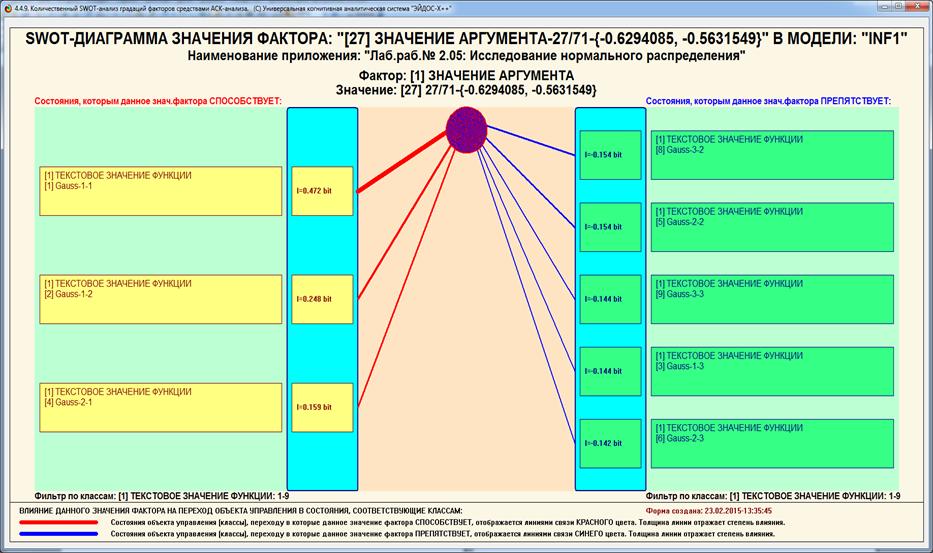

инвертированной SWOT-матрицы для одного из интервальных значений аргумента

приведена на рисунке 11, а соответствующая ей инвертированная SWOT-диаграмма –

на рисунке 12:

Рисунок 11 – Пример экранной формы инвертированной

SWOT-матрицы

Рисунок 12 – Пример экранной формы инвертированной

SWOT-диаграммы

Рассмотрим теперь варианты различных по форме ответов

на второй вопрос: «Вопрос 2-й. Какое суммарное количество информации о степени сходства

эмпирического распределения наблюдений с нормальными распределениями с различными

параметрами мы получаем, зная частоты попадания случайной величины в каждый из

интервалов при N равных интервалов?», которые предоставляет система «Эйдос».

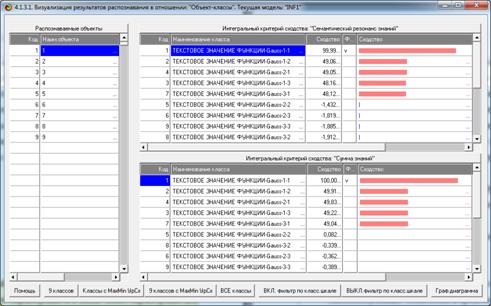

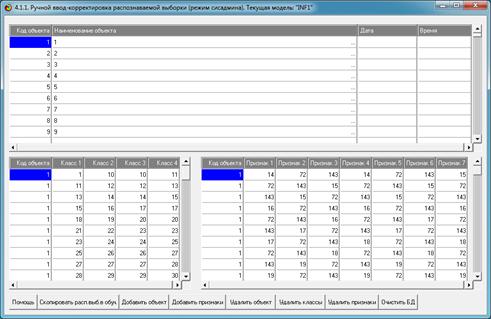

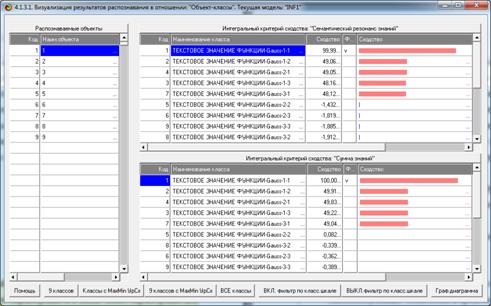

На рисунке 13 представлена экранная форма с

отображением фрагмента эмпирического распределения частот наблюдений №1, а на

рисунке 14, – результаты идентификации этого эмпирического распределения

по суммарному количеству информации, содержащемуся в нем.

Рисунок 13 – Экранная форма с отображением

эмпирического

распределения частот наблюдений (фрагмент)

Рисунок 14 – Результаты определения вида и параметров

эмпирического

статистического распределения №1 по максимальному количеству

информации в нем о других распределениях, содержащихся в моделях

Мы видим, что в эмпирическом распределении №1 больше

всего информации содержится о его сходстве со стандартным нормальным распределением

Gauss-1-1, что и соответствует действительности.

Возникает вопрос: «А чем эта технология отличается от

расчета простой корреляции между эмпирическим и теоретическим

распределениями?». Есть несколько очень существенных отличий:

1. При расчете корреляции мы используем математический

аппарат параметрической статистики, что является корректным только в случае,

когда исследуемые данные подчиняются нормальному распределению. В данном же

случае использован математический аппарат, не основанный на этом предположении.

2. При расчете корреляции все координаты векторов

имеют одинаковый вес, равный 1, тогда как в данном случае вес наблюдений

различен, причем он может быть как положительным, так и отрицательным и равен

количеству информации в них [14, 15].

3. Расчет корреляции производится для одной группы,

тогда как количество информации рассчитывается на основе анализа модели,

отражающей условные и безусловные частотные распределения во всех группах и на

основе их сравнения. Таким образом, данный метод является обобщением метода

контрольных групп (на большое число групп), являющегося общепринятым в науке

для выявления влияния факторов.

Обратимся к ответу на «Вопрос 3-й. Попадание случайной

величины в какие интервалы при N равных интервалах является более характерным и

в какие менее характерным для нормальных распределений с различными параметрами?»

На качественном уровне ответ на этот вопрос дает

визуализация когнитивной функции на рисунке 10. На количественном – сама база

знаний, сформированная в системе, а также другие формы, полученные на ее основе.

В таблице 2 приведен фрагмент базы знаний с количеством информации в битах по

А.Харкевичу в интервальных значениях аргумента о том, что это значение

принадлежит статистическому распределению с определенными параметрами:

Таблица 2 – Количество информации в битах по

А.Харкевичу в интервальных значениях аргумента о том, что это значение

принадлежит нормальному распределению с определенными параметрами

|

Аргумент

|

G-1-1

|

G-1-2

|

G-1-3

|

G-2-1

|

G-2-2

|

G-2-3

|

G-3-1

|

G-3-2

|

G-3-3

|

|

1/71-{-2.3520000,

-2.2857465}

|

|

|

1,28688

|

|

|

|

|

|

|

|

2/71-{-2.2857465,

-2.2194930}

|

|

|

1,28688

|

|

|

|

|

|

|

|

3/71-{-2.2194930,

-2.1532394}

|

|

|

1,28688

|

|

|

|

|

|

|

|

4/71-{-2.1532394,

-2.0869859}

|

|

|

1,28688

|

|

|

|

|

|

|

|

5/71-{-2.0869859,

-2.0207324}

|

|

|

1,28688

|

|

|

|

|

|

|

|

6/71-{-2.0207324,

-1.9544789}

|

|

0,87429

|

0,88422

|

|

|

|

|

|

|

|

7/71-{-1.9544789,

-1.8882254}

|

|

0,87429

|

0,88422

|

|

|

|

|

|

|

|

8/71-{-1.8882254,

-1.8219718}

|

|

0,76838

|

0,77831

|

|

|

0,24853

|

|

|

|

|

9/71-{-1.8219718,

-1.7557183}

|

|

0,63875

|

0,64868

|

|

|

0,65119

|

|

|

|

|

10/71-{-1.7557183,

-1.6894648}

|

|

0,63875

|

0,64868

|

|

|

0,65119

|

|

|

|

|

11/71-{-1.6894648,

-1.6232113}

|

|

0,63875

|

0,64868

|

|

|

0,65119

|

|

|

|

|

12/71-{-1.6232113,

-1.5569577}

|

|

0,63875

|

0,64868

|

|

|

0,65119

|

|

|

|

|

13/71-{-1.5569577,

-1.4907042}

|

|

0,54920

|

0,55913

|

|

0,14654

|

0,56164

|

|

|

|

|

14/71-{-1.4907042,

-1.4244507}

|

-0,01163

|

0,40321

|

0,41314

|

|

0,40321

|

0,41565

|

|

|

|

|

15/71-{-1.4244507,

-1.3581972}

|

0,32982

|

0,34200

|

0,35193

|

|

0,34200

|

0,35444

|

|

|

|

|

16/71-{-1.3581972,

-1.2919437}

|

0,22391

|

0,23609

|

0,24602

|

|

0,23609

|

0,24853

|

|

|

0,24602

|

|

17/71-{-1.2919437,

-1.2256901}

|

0,22391

|

0,23609

|

0,24602

|

|

0,23609

|

0,24853

|

|

|

0,24602

|

|

18/71-{-1.2256901,

-1.1594366}

|

0,22391

|

0,23609

|

0,24602

|

|

0,23609

|

0,24853

|

|

|

0,24602

|

|

19/71-{-1.1594366,

-1.0931831}

|

0,32982

|

0,21237

|

0,22230

|

|

0,21237

|

0,22481

|

|

|

0,22230

|

|

20/71-{-1.0931831,

-1.0269296}

|

0,53702

|

0,14654

|

0,15647

|

|

0,14654

|

0,15898

|

|

|

0,15647

|

|

21/71-{-1.0269296,

-0.9606761}

|

0,45945

|

0,06897

|

0,07890

|

|

0,06897

|

0,08141

|

|

0,06897

|

0,07890

|

|

22/71-{-0.9606761,

-0.8944225}

|

0,39103

|

0,00055

|

0,01048

|

-0,01163

|

0,00055

|

0,01299

|

|

0,00055

|

0,01048

|

|

23/71-{-0.8944225,

-0.8281690}

|

0,45945

|

0,17488

|

-0,05073

|

-0,07284

|

-0,06066

|

-0,04822

|

|

-0,06066

|

-0,05073

|

|

24/71-{-0.8281690,

-0.7619155}

|

0,51000

|

0,28664

|

-0,10610

|

-0,12821

|

-0,11603

|

-0,10359

|

|

-0,11603

|

-0,10610

|

|

25/71-{-0.7619155,

-0.6956620}

|

0,51000

|

0,28664

|

-0,10610

|

-0,12821

|

-0,11603

|

-0,10359

|

|

-0,11603

|

-0,10610

|

|

26/71-{-0.6956620,

-0.6294085}

|

0,51000

|

0,28664

|

-0,10610

|

-0,12821

|

-0,11603

|

-0,10359

|

|

-0,11603

|

-0,10610

|

|

27/71-{-0.6294085,

-0.5631549}

|

0,47168

|

0,24832

|

-0,14441

|

0,15857

|

-0,15434

|

-0,14190

|

|

-0,15434

|

-0,14441

|

|

28/71-{-0.5631549,

-0.4969014}

|

0,45945

|

0,23609

|

-0,15664

|

0,22391

|

-0,16657

|

-0,15413

|

|

-0,16657

|

-0,15664

|

|

29/71-{-0.4969014,

-0.4306479}

|

0,44040

|

0,21704

|

-0,17569

|

0,20486

|

-0,18562

|

-0,17318

|

-0,73009

|

-0,18562

|

-0,17569

|

|

30/71-{-0.4306479,

-0.3643944}

|

0,41295

|

0,18959

|

-0,20314

|

0,17741

|

-0,21307

|

-0,20063

|

-0,22525

|

-0,21307

|

-0,20314

|

|

31/71-{-0.3643944,

-0.2981408}

|

0,33959

|

0,11622

|

-0,27651

|

0,28904

|

0,11622

|

-0,27400

|

-0,29862

|

-0,28644

|

-0,27651

|

|

32/71-{-0.2981408,

-0.2318873}

|

0,32982

|

0,10646

|

-0,28627

|

0,32982

|

0,10646

|

-0,28376

|

-0,30838

|

-0,29620

|

-0,28627

|

|

33/71-{-0.2318873,

-0.1656338}

|

0,32982

|

0,10646

|

-0,28627

|

0,32982

|

0,10646

|

-0,28376

|

-0,30838

|

-0,29620

|

-0,28627

|

|

34/71-{-0.1656338,

-0.0993803}

|

0,20278

|

-0,02058

|

-0,24619

|

0,36990

|

0,14654

|

-0,24368

|

-0,13867

|

-0,25612

|

-0,24619

|

|

35/71-{-0.0993803,

-0.0331268}

|

0,13436

|

-0,25612

|

-0,24619

|

0,36990

|

0,14654

|

-0,24368

|

0,13436

|

-0,25612

|

-0,24619

|

|

36/71-{-0.0331268,

0.0331268}

|

0,13436

|

-0,25612

|

-0,24619

|

0,36990

|

0,14654

|

-0,24368

|

0,13436

|

-0,25612

|

-0,24619

|

|

37/71-{0.0331268,

0.0993803}

|

0,13436

|

-0,25612

|

-0,24619

|

0,36990

|

0,14654

|

-0,24368

|

0,13436

|

-0,25612

|

-0,24619

|

|

38/71-{0.0993803,

0.1656338}

|

-0,13867

|

-0,25612

|

-0,24619

|

0,36990

|

0,14654

|

-0,24368

|

0,20278

|

-0,02058

|

-0,24619

|

|

39/71-{0.1656338,

0.2318873}

|

-0,30838

|

-0,29620

|

-0,28627

|

0,32982

|

0,10646

|

-0,28376

|

0,32982

|

0,10646

|

-0,28627

|

|

40/71-{0.2318873,

0.2981408}

|

-0,30838

|

-0,29620

|

-0,28627

|

0,32982

|

0,10646

|

-0,28376

|

0,32982

|

0,10646

|

-0,28627

|

|

41/71-{0.2981408,

0.3643944}

|

-0,29862

|

-0,28644

|

-0,27651

|

0,28904

|

0,11622

|

-0,27400

|

0,33959

|

0,11622

|

-0,27651

|

|

42/71-{0.3643944,

0.4306479}

|

-0,22525

|

-0,21307

|

-0,20314

|

0,17741

|

-0,21307

|

-0,20063

|

0,41295

|

0,18959

|

-0,20314

|

|

43/71-{0.4306479,

0.4969014}

|

-0,73009

|

-0,18562

|

-0,17569

|

0,20486

|

-0,18562

|

-0,17318

|

0,44040

|

0,21704

|

-0,17569

|

|

44/71-{0.4969014,

0.5631549}

|

|

-0,16657

|

-0,15664

|

0,22391

|

-0,16657

|

-0,15413

|

0,45945

|

0,23609

|

-0,15664

|

|

45/71-{0.5631549,

0.6294085}

|

|

-0,15434

|

-0,14441

|

0,15857

|

-0,15434

|

-0,14190

|

0,47168

|

0,24832

|

-0,14441

|

|

46/71-{0.6294085,

0.6956620}

|

|

-0,11603

|

-0,10610

|

-0,12821

|

-0,11603

|

-0,10359

|

0,51000

|

0,28664

|

-0,10610

|

|

47/71-{0.6956620,

0.7619155}

|

|

-0,11603

|

-0,10610

|

-0,12821

|

-0,11603

|

-0,10359

|

0,51000

|

0,28664

|

-0,10610

|

|

48/71-{0.7619155,

0.8281690}

|

|

-0,11603

|

-0,10610

|

-0,12821

|

-0,11603

|

-0,10359

|

0,51000

|

0,28664

|

-0,10610

|

|

49/71-{0.8281690,

0.8944225}

|

|

-0,06066

|

-0,05073

|

-0,07284

|

-0,06066

|

-0,04822

|

0,45945

|

0,17488

|

-0,05073

|

|

50/71-{0.8944225,

0.9606761}

|

|

0,00055

|

0,01048

|

-0,01163

|

0,00055

|

0,01299

|

0,39103

|

0,00055

|

0,01048

|

|

51/71-{0.9606761,

1.0269296}

|

|

0,06897

|

0,07890

|

|

0,06897

|

0,08141

|

0,45945

|

0,06897

|

0,07890

|

|

52/71-{1.0269296,

1.0931831}

|

|

|

0,15647

|

|

0,14654

|

0,15898

|

0,53702

|

0,14654

|

0,15647

|

|

53/71-{1.0931831,

1.1594366}

|

|

|

0,22230

|

|

0,21237

|

0,22481

|

0,32982

|

0,21237

|

0,22230

|

|

54/71-{1.1594366,

1.2256901}

|

|

|

0,24602

|

|

0,23609

|

0,24853

|

0,22391

|

0,23609

|

0,24602

|

|

55/71-{1.2256901,

1.2919437}

|

|

|

0,24602

|

|

0,23609

|

0,24853

|

0,22391

|

0,23609

|

0,24602

|

|

56/71-{1.2919437,

1.3581972}

|

|

|

0,24602

|

|

0,23609

|

0,24853

|

0,22391

|

0,23609

|

0,24602

|

|

57/71-{1.3581972,

1.4244507}

|

|

|

|

|

0,34200

|

0,35444

|

0,32982

|

0,34200

|

0,35193

|

|

58/71-{1.4244507,

1.4907042}

|

|

|

|

|

0,40321

|

0,41565

|

-0,01163

|

0,40321

|

0,41314

|

|

59/71-{1.4907042,

1.5569577}

|

|

|

|

|

0,14654

|

0,56164

|

|

0,54920

|

0,55913

|

|

60/71-{1.5569577,

1.6232113}

|

|

|

|

|

|

0,65119

|

|

0,63875

|

0,64868

|

|

61/71-{1.6232113,

1.6894648}

|

|

|

|

|

|

0,65119

|

|

0,63875

|

0,64868

|

|

62/71-{1.6894648,

1.7557183}

|

|

|

|

|

|

0,65119

|

|

0,63875

|

0,64868

|

|

63/71-{1.7557183,

1.8219718}

|

|

|

|

|

|

0,65119

|

|

0,63875

|

0,64868

|

|

64/71-{1.8219718,

1.8882254}

|

|

|

|

|

|

0,24853

|

|

0,76838

|

0,77831

|

|

65/71-{1.8882254,

1.9544789}

|

|

|

|

|

|

|

|

0,87429

|

0,88422

|

|

66/71-{1.9544789,

2.0207324}

|

|

|

|

|

|

|

|

0,87429

|

0,88422

|

|

67/71-{2.0207324,

2.0869859}

|

|

|

|

|

|

|

|

|

1,28688

|

|

68/71-{2.0869859,

2.1532394}

|

|

|

|

|

|

|

|

|

1,28688

|

|

69/71-{2.1532394,

2.2194930}

|

|

|

|

|

|

|

|

|

1,28688

|

|

70/71-{2.2194930,

2.2857465}

|

|

|

|

|

|

|

|

|

1,28688

|

|

71/71-{2.2857465,

2.3520000}

|

|

|

|

|

|

|

|

|

1,28688

|

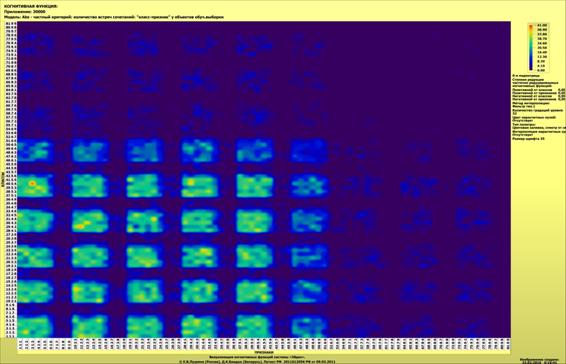

Параметры, соответствующие распределениям, приведены в

таблице 1. Изображение несимметрично относительно аргумента из-за

использования небольшого количества интервальных значений аргумента.

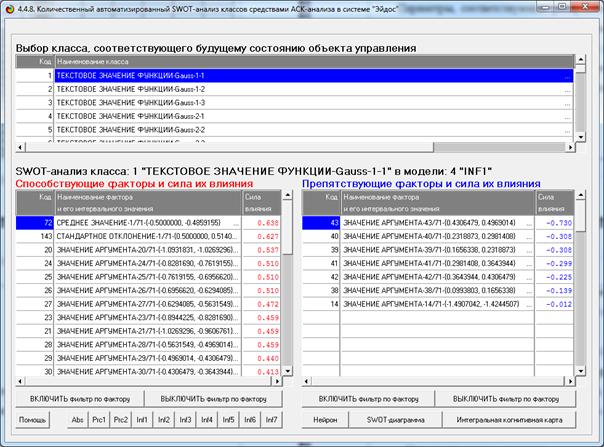

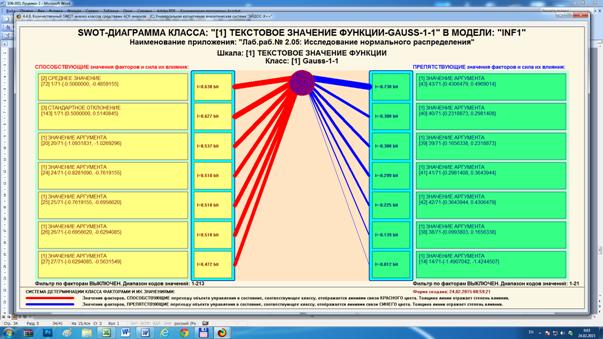

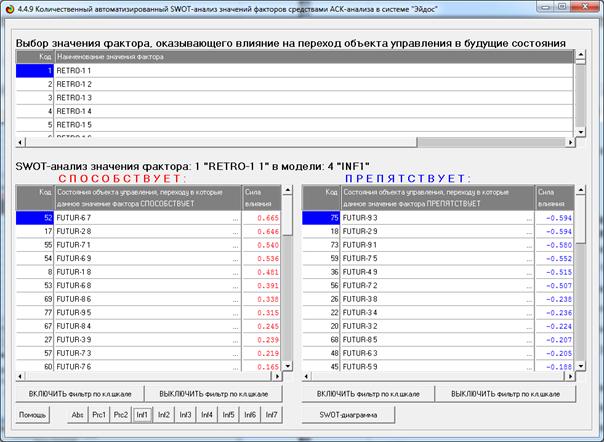

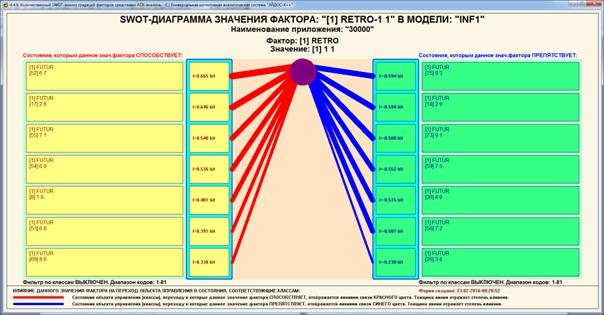

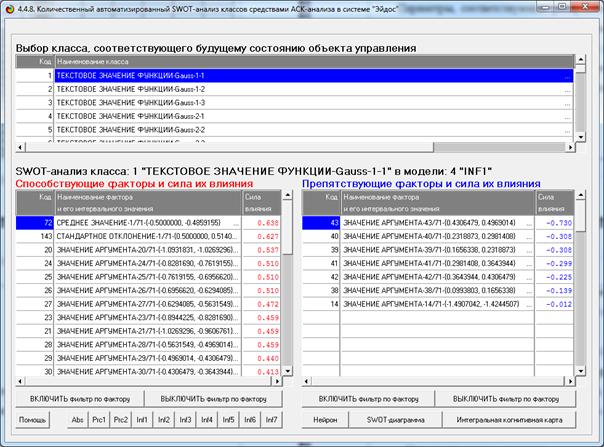

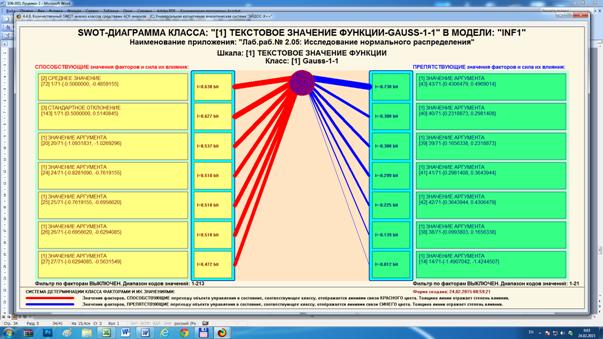

Характеристика любого заданного распределения,

полученная на основе этой базы данных, приведена в SWOT-матрице (рисунок 15) и

соответствующей диаграмме (рисунок 16):

Рисунок 15 – Экранная форма с характеристикой

распределения

Gauss-1-1 в виде SWOT-матрицы

Рисунок 16 – Экранная форма с характеристикой

нормального распределения Gauss-1-1 в виде SWOT-диаграммы

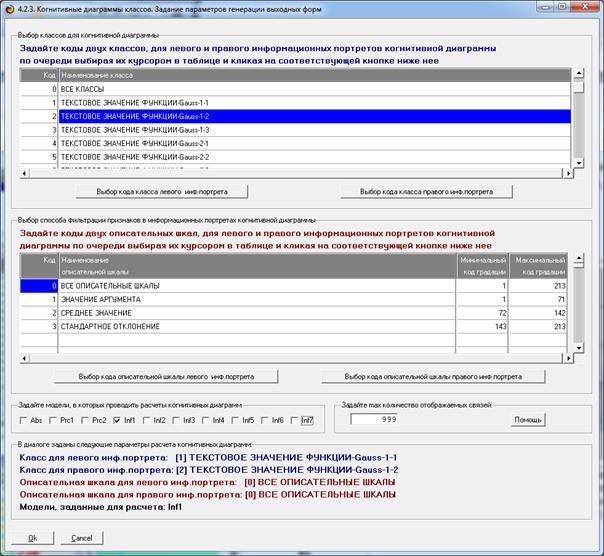

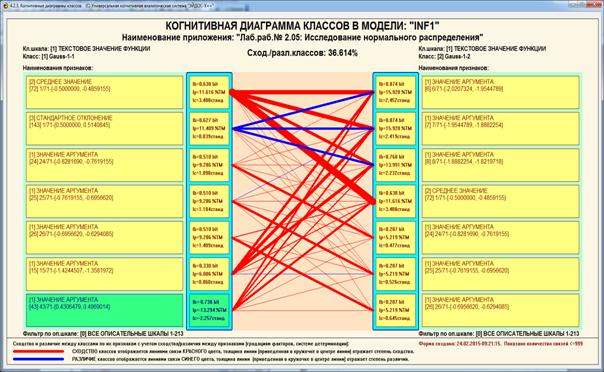

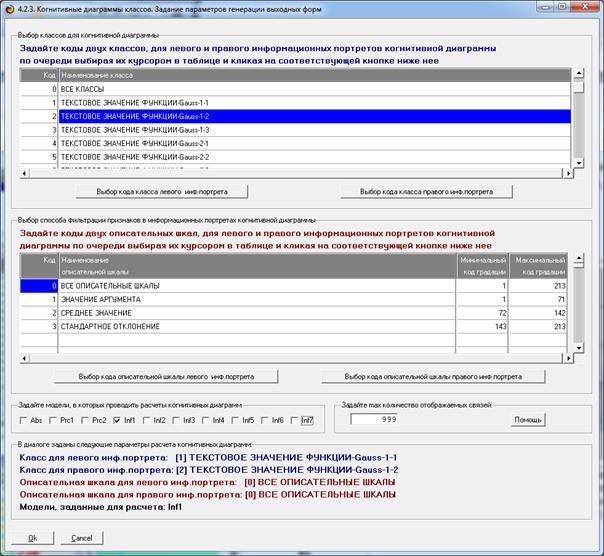

Экранная форма задания на выполнение содержательного

сравнения двух заданных распределений приведена на рисунке 17, а результат сравнения

– в диаграмме на рисунке 18.

Отметим, что эти формы представляют собой результат

решения задачи № 5: одной из сформулированных в данном разделе

задач статистики, которую предположительно можно решить методами теории

информации.

Рисунок 17 – Экранная форма задания на выполнение

содержательного сравнения двух заданных распределений

Рисунок 18 – Результат содержательного сравнения двух

распределений

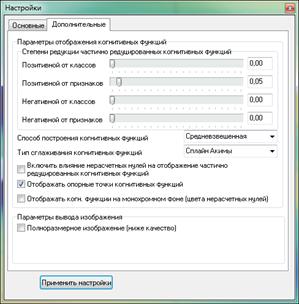

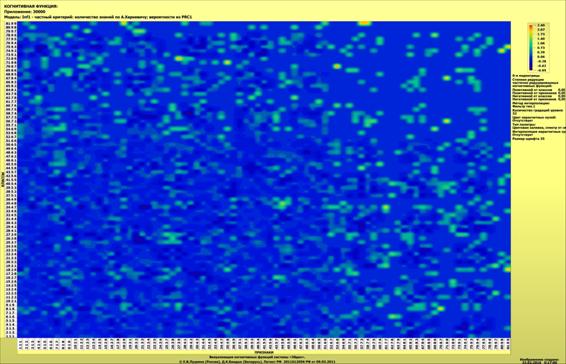

На рисунке 19 приведена визуализация таблицы 2:

Рисунок 19 – Количество информации по А.Харкевичу в

интервальных значениях аргумента о том, что это значение принадлежит

нормальному распределению с определенными параметрами (визуализация таблицы 2)

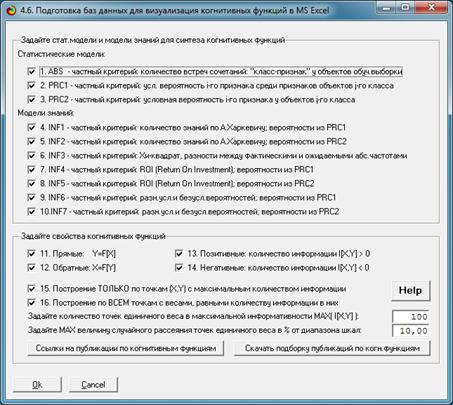

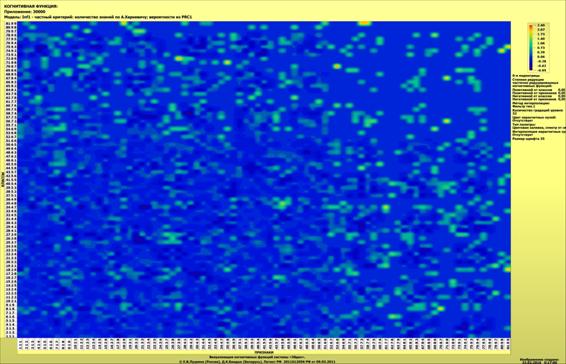

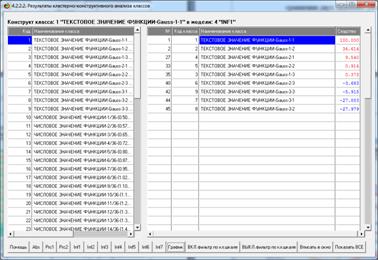

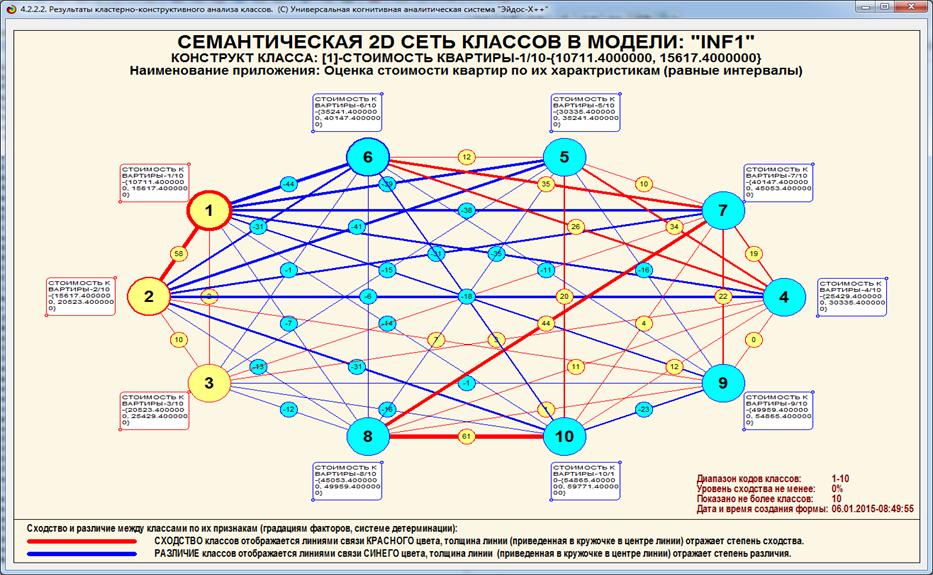

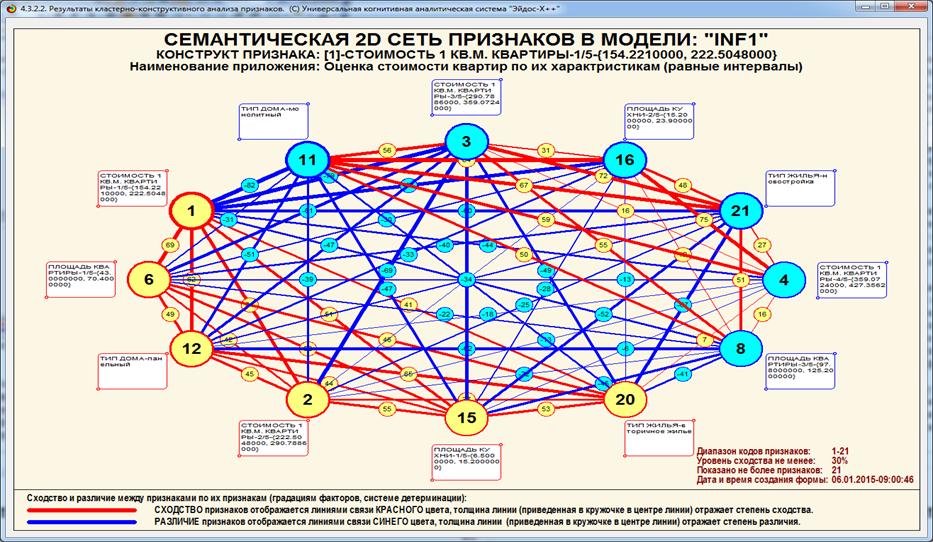

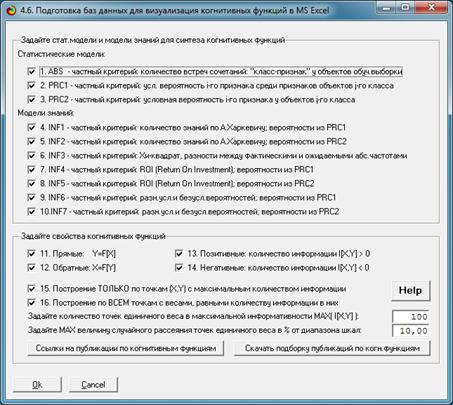

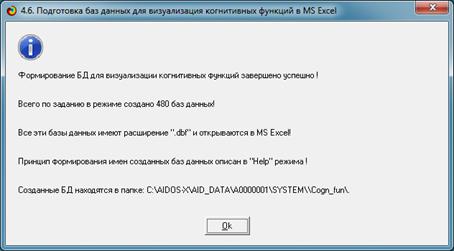

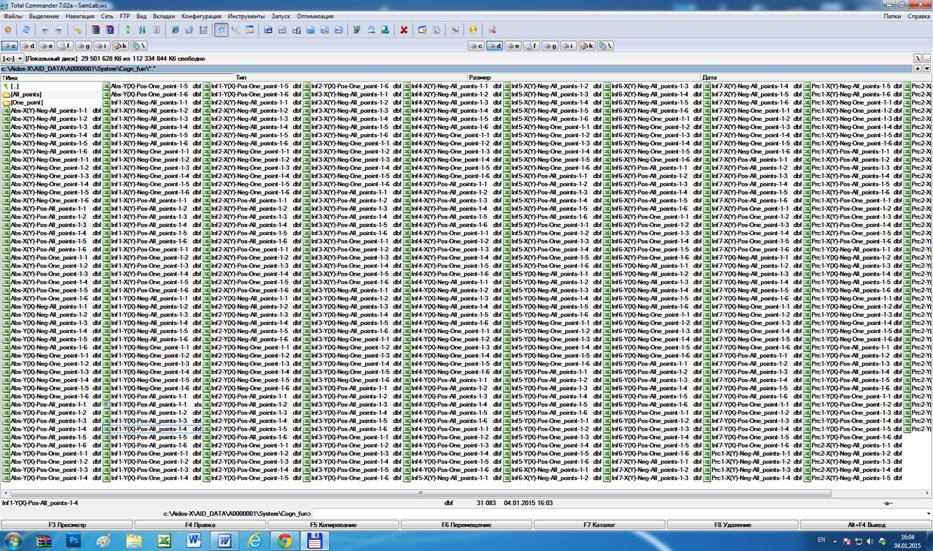

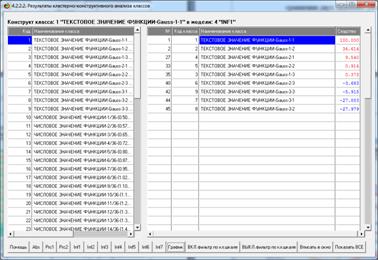

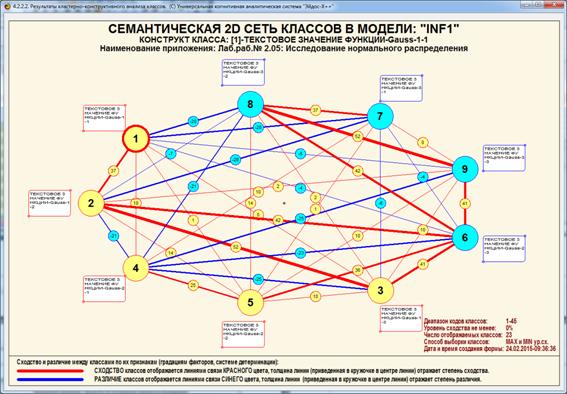

Приведем две выходные форм, полученные в результате

решения Задачи № 6:

«исследование информационных моделей статистических распределений» (решение

этой задачи включает кластерный и конструктивный анализ распределений, их информационные

портреты и многие другие исследования с использованием возможностей АСК-анализа

и системы «Эйдос» [21]).

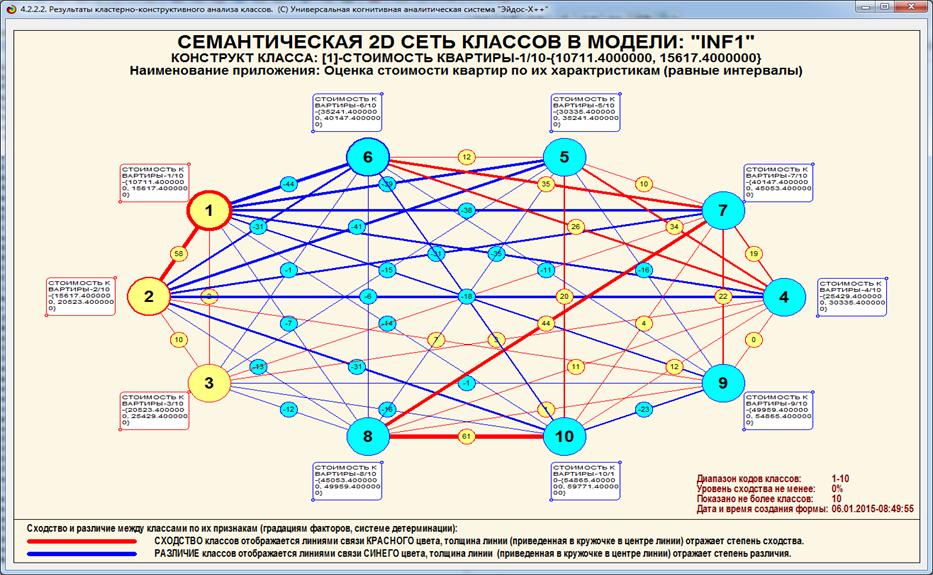

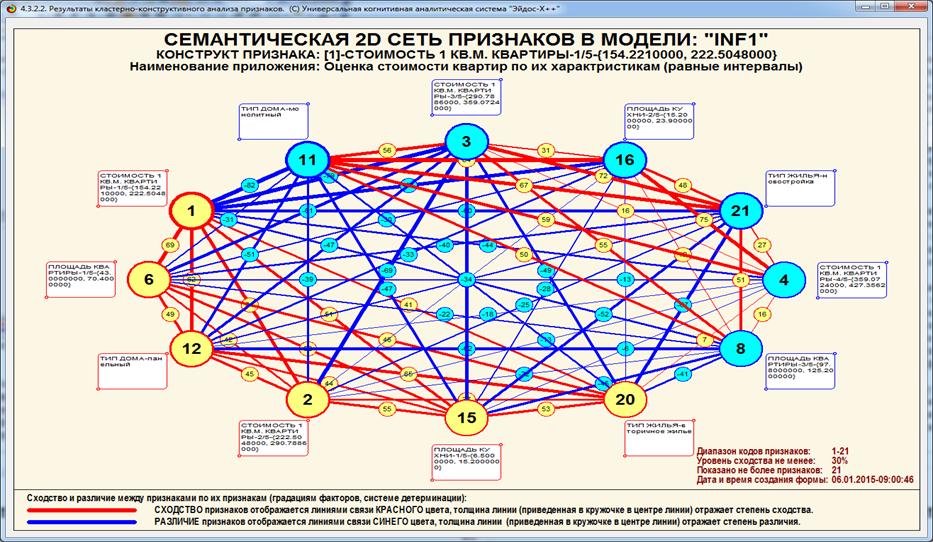

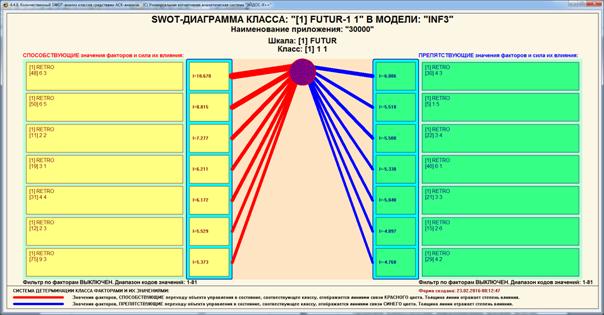

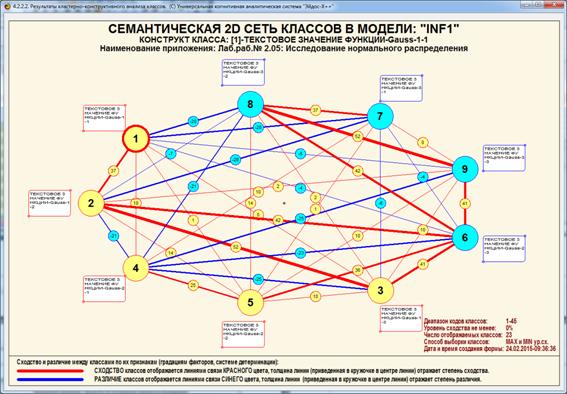

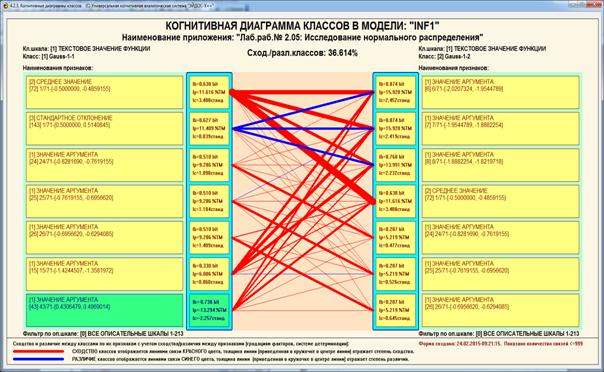

На рисунке 20 приведена экранная форма, а на рисунке

21 – соответствующая диаграмма, отражающие результаты кластерно-конструктивного

анализа смоделированных нормальных распределений:

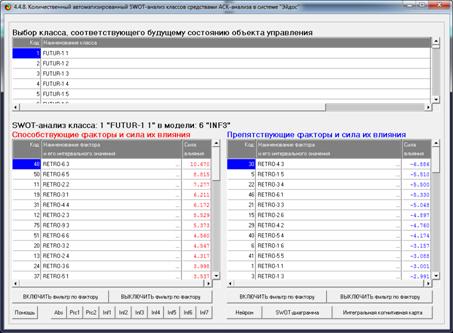

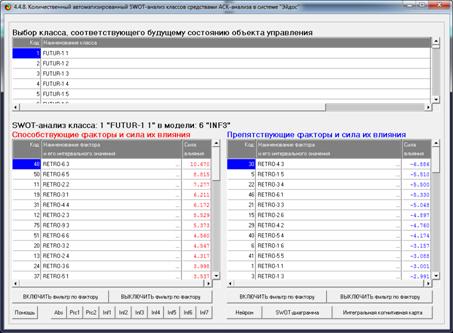

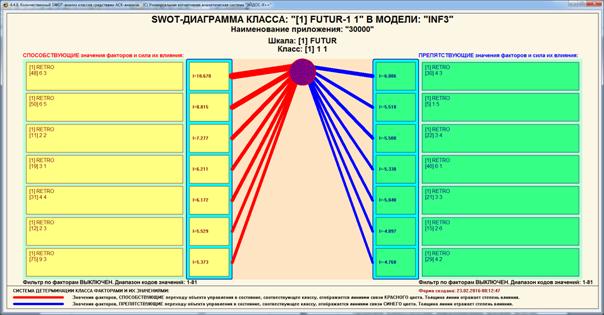

Рисунок 20 – Экранная форма с результатами

кластерно-конструктивного

анализа смоделированных нормальных распределений в модели

с количеством информации по А.Харкевичу (INF1)

(установлен фильтр по типу распределения)

Рисунок 21 – Когнитивная диаграмма с результатами

кластерно-конструктивного анализа смоделированных нормальных распределений

в модели с количеством информации по А.Харкевичу (INF1)

(установлен фильтр по типу распределения)

Предлагается теоретическое

обоснование, методика численных расчетов

и программная реализация решения задач статистики, в частности исследования

статистических распределений, методами теории информации. При этом

непосредственно на основе эмпирических данных расчетным путем определяется

количество информации в наблюдениях, которое используется для анализа

статистических распределений. Предлагаемый способ расчета количества информации

не основан на предположениях о независимости наблюдений и их нормальном

распределении, т.е. является непараметрическим и обеспечивает корректное

моделирование нелинейных систем, а также позволяет сопоставимо обрабатывать

разнородные (измеряемые в шкалах различных типов) данные числовой и нечисловой

природы, измеряемые в различных единицах измерения.

Таким образом, АСК-анализ и

система «Эйдос» представляют собой современную инновационную (готовую к

внедрению) технологию решения задач статистики методами теории информации.

Данный раздел может быть использована как описание

лабораторной работы по дисциплинам:

– Интеллектуальные системы;

– Инженерия знаний и интеллектуальные системы;

– Интеллектуальные технологии и

представление знаний;

– Представление знаний в интеллектуальных

системах;

– Основы интеллектуальных систем;

– Введение в нейроматематику и методы

нейронных сетей;

– Основы искусственного интеллекта;

– Интеллектуальные технологии в науке и образовании;

– Управление знаниями;

– Автоматизированный системно-когнитивный

анализ и интеллектуальная система «Эйдос»;

которые автор ведет в настоящее время,

а также и в других дисциплинах, связанных с преобразованием данных в

информацию, а ее в знания и применением этих знаний для решения задач

идентификации, прогнозирования, принятия решений и исследования моделируемой

предметной области (а это практически все дисциплины во всех областях науки).

В данном разделе лишь намечены некоторые пути

применения теории информации для решения задач статистики. Для реального

решения сформулированных выше и других связанных с этим направлением задач

необходимы обширные научные исследования и разработки инструментальных средств,

что является делом будущего. Планируется описать уже решенные задачи, а также

решить некоторые из сформулированных выше задач, в частности использовать

статистические критерии в качестве вторичных признаков статистических

распределений и исследовать различные статистические распределения.

В данном разделе

кратко рассматриваются математическая сущность предложенной автором модификации взвешенного метода наименьших квадратов (ВМНК),

в котором в качестве весов наблюдений применяется количество информации

в них. Предлагается два варианта данной модификации ВМНК. В первом варианте

взвешивание наблюдений производится путем замены одного наблюдения с

определенным количеством информации в нем соответствующим количеством наблюдений единичного веса, а

затем к ним применяется стандартный метод наименьших

квадратов (МНК). Во втором варианте взвешивание наблюдений производится

для каждого значения аргумента путем замены всех наблюдений с определенным

количеством информации в них одним наблюдением единичного веса, полученным как

средневзвешенное от них, а затем к ним применяется стандартный МНК. Подробно

описана методика численных расчетов количества информации в наблюдениях,

основанная на теории автоматизированного системно-когнитивного анализа

(АСК-анализ) и реализованная в его программном инструментарии –

интеллектуальной системе «Эйдос». Приводится иллюстрация предлагаемого подхода

на простом численном примере. В будущем планируется дать более развернутое

математическое обоснование метода взвешенных наименьших квадратов, модифицированного

путем применения в качестве весов наблюдений количества информации в них, а

также исследовать его свойства

«... навыки

мысли и аналитический аппарат теории информации должны, по-видимому, привести к

заметной перестройке здания

математической статистики»

А.Н.

Колмогоров [1, 2, 19]

Данный раздел посвящен математическим аспектам нового

варианта взвешенного метода наименьших квадратов (ВМНК), модифицированного

путем применения в качестве весов наблюдений количества информации в них.

Данный подход предложен автором, в теоретическом плане основан на

автоматизированном системно-когнитивном анализе (АСК-анализ) и реализован в его

программном инструментарии – системе «Эйдос» [36].

В работе [36] подробно описаны проблемы стандартного

(классического) метода наименьших квадратов (МНК), состоящей в том, что в исходных данных обычно есть такие, которые

хуже, чем остальные вписываются в регрессионную модель, т.е. описываются ей с

большей погрешностью. По мнению автора, причина этого состоит не только в самих данных, но

и в способе их отражения в модели.

Иначе говоря, по-видимому, в принципе возможно построение разных моделей,

отражающих одни и те же эмпирические данные, причем количество этих моделей не

ограничено, и в одних моделях эта погрешность будет больше, а в других, более

удачных – меньше. Но фактически, т.е. на практике, часто выбор возможных

моделей ограничен одной. Поэтому актуальным является каждый новый

метод построения моделей, который может иметь некоторые преимущества перед уже

известными.

Традиционным решением этой проблемы является

взвешенный метод наименьших квадратов. В той же работе [36] обосновывается, что

подход, реализованный в ВМНК, на самом деле лишь создает видимость решения, а

фактически основан просто на игнорировании данных, причем тем в большей

степени, чем хуже они вписывающихся в регрессионную модель.

Рассмотрим еще

две проблемы, дополнительно к уже описанным в [36], которые обуславливают

актуальность предложенной модификации взвешенного метода наименьших квадратов.

Первая проблема ВМНК состоит в том, что

на практике ошибки наблюдений являются неизвестными, поэтому их обычно

принимают пропорциональными значениям переменных. «Суть взвешенного метода

наименьших квадратов состоит в том, что остаткам обобщённой модели регрессии

придаются определённые веса, которые равны обратным величинам соответствующих

дисперсий G2(εi).Однако

на практике значения дисперсий являются

величинами неизвестными, поэтому для вычисления наиболее подходящих весов

используется предположение о том, что они пропорциональны значениям факторных

переменных xt» (курсив мой, авт.).

Вторая проблема

ВМНК состоит в применении евклидовой меры

расстояния при определении ошибки наблюдений. Но эта мера адекватна только для ортонормированных пространств, которые

на практике вообще никогда не встречаются, как, кстати, и линейные системы. «Если

случайные ошибки модели регрессии подвержены гетероскедастичности (но являются

неавтокоррелированными), то для оценивания неизвестных коэффициентов модели

регрессии применяется взвешенный метод наименьших квадратов»1.

В качестве возможного решения поставленной проблемы в

работе [36] и предлагается модификация ВМНК, в которой:

– в качестве весов наблюдений используется количество

информации в них;

– в качестве меры расстояния применяется суммарное

количество информации (т.е. по сути свертка или скалярное произведение), т.е. информационное

расстояние, мера расстояния неметрической природы, вообще не предполагающая

ортонормированность пространства.

Кроме того очень важно, что АСК-анализе все факторы

рассматриваются с одной единственной точки зрения: сколько информации содержится в их значениях о переходе объекта, на

который они действуют, в определенные будущие состояния, и при этом сила и

направление влияния всех значений факторов на объект измеряется в одних общих

для всех факторов единицах измерения: единицах

количества информации [3]. Именно по

этой причине вполне корректно складывать силу и направление влияния всех

действующих на объект значений факторов, независимо от их природы, и определять

результат совместного влияния на

объект системы значений факторов. При

этом в общем случае объект является нелинейным

и факторы внутри него взаимодействуют друг с другом, т.е. для них не

выполняется принцип суперпозиции. Если же

разные факторы измеряются в различных единицах измерения, то результаты сравнения объектов будут зависеть от этих

единиц измерения, что совершенно недопустимо с теоретической точки

зрения [3].

Введем

определение когнитивной функции:

когда функция используется для отображения причинно-следственной зависимости,

т.е. информации (согласно концепции Шенка-Абельсона [34]), или знаний, если эта информация полезна для

достижении целей [35], то будем называть такую функцию когнитивной функцией, от англ. «cognition»

[3].

Смысл когнитивной функциональной зависимости в

том, что в значении аргумента содержится определенное количество информации

о том, какое значение примет функция, т.е. когнитивная функция отражает знания

о степени соответствия значений функции значениям аргумента [3].

Очень важно,

что этот подход позволяет автоматически решить проблему сопоставимой обработки

многих факторов, измеряемых в различных единицах измерения, т.к. в этом подходе рассматриваются не сами

факторы, какой бы природы они не были и какими бы шкалами не формализовались,

а количество информации, которое

в них содержится о поведении моделируемого объекта [3].

Необходимо также отметить, что представление о

полностью линейных объектах (системах) является абстракцией и реально все объекты являются принципиально

нелинейными. Вместе с тем для большинства систем нелинейные эффекты можно считать

эффектами второго и более высоких порядков и такие системы в первом приближении можно считать линейными. Возможны различные

модели взаимодействия факторов, в

частности, развиваемые в форме системного обобщения теории множеств. Этот

подход в перспективе может стать одним из вариантов развития теории нелинейных

систем [3].

Отметим, что математическая модель АСК-анализа

(системная теория информации) органично

учитывает принципиальную нелинейность всех объектов. Это проявляется в

нелокальности нейронной сети системы «Эйдос» [46], приводящей к зависимости всех

информативностей от любого изменения в исходных данных, а не как в методе обратного

распространения ошибки. В результате значения матрицы информативностей количественно

отражают факторы не как множество, а как систему.

В АСК-анализе ставится задача метризации шкал, т.е. преобразования к

наиболее формализованному виду, и предлагается 7 способов метризации всех типов

шкал, обеспечивающих совместную сопоставимую количественную обработку

разнородных факторов, измеряемых в различных единицах измерения за счет

преобразования всех шкал к одним универсальным единицам измерения в качестве

которых выбраны единицы измерения количества информации. Все эти способы метризации реализованы в

АСК-анализе и системе «Эйдос» [3]. В работах [4, 5, 6] кратко описаны суть и

история появления и развития метода АСК-анализа и его программного

инструментария – интеллектуальной системы «Эйдос», поэтому здесь мы их излагать

не будем. Отметим лишь, что эти методы созданы довольно давно и уже в 1987 году

были акты внедрения интеллектуальных приложений, в которых формировались

информационные портреты классов и и значений факторов [7].

Поэтому для

нас является вполне естественным предположить, что в качестве весов наблюдений целесообразно использовать количество

информации, которое содержится в этих наблюдениях о том, что интересующие

нас выходные параметры объекта моделирования примут те или иные значения или

сам объект моделирования перейдет в состояния, соответствующие тем или иным

классам или окажется принадлежащим к определенным обобщающим категориям

(группам). В этом и состоит основная идея

предлагаемого решения поставленной проблемы.

В АСК-анализе на основе системной теории информации [7, 17] развит математический аппарат,

обеспечивающий формальное описание поведения сложных нелинейных объектов

моделирования под воздействием систем управляющих факторов и окружающей среды,

а также созданы инструментальные средства, реализующие этот математический

аппарат.

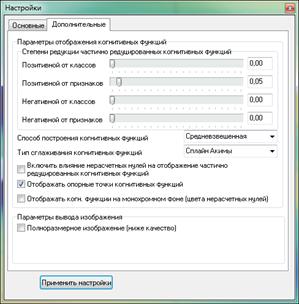

В частности в АСК-анализе предложено понятие когнитивных функций, которое

рассмотрено и развито в ряде работ автора и соавторов [8, 9, 10, 11, 12, 13,

14, 15, 16, 17, 18] и поэтому здесь нет смысла подробно останавливаться на этом

понятии. Отметим лишь суть. В работе [16] кратко рассматриваются классическое

понятие функциональной зависимости в математике, определяются ограничения применимости

этого понятия для адекватного моделирования реальности и формулируется