1.2.2. ЛЕКЦИЯ-4.

Системная

теория информации

и семантическая информационная модель

Учебные вопросы

1. Программа

системного обобщения математики и предпосылки системной теории информации

2.

Теоретические основы системной теории информации.

3.

Семантическая информационная модель СК-анализа.

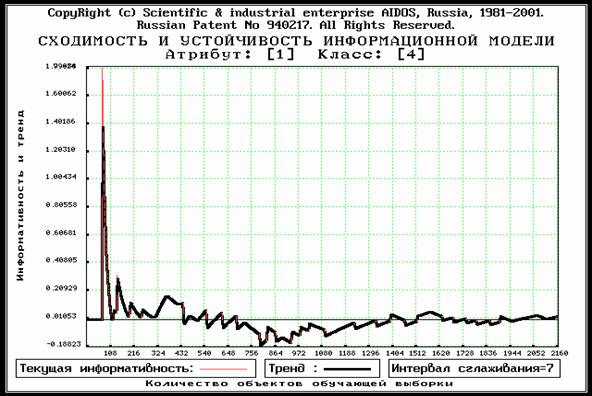

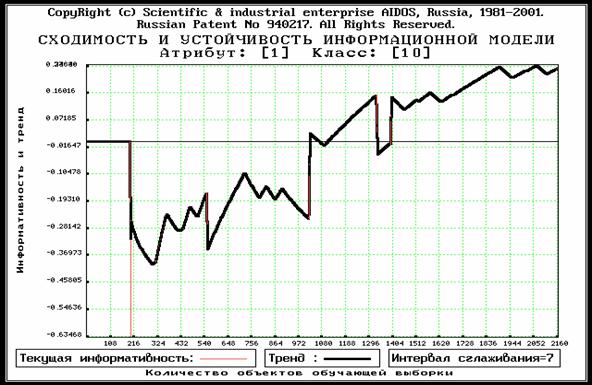

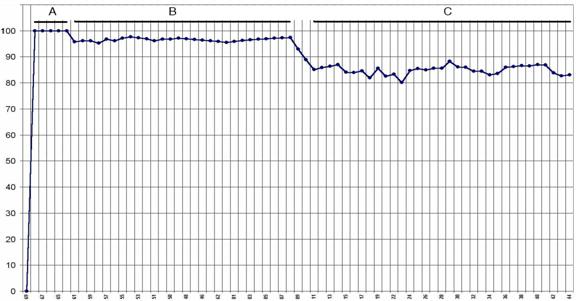

4. Некоторые

свойства математической модели (сходимость, адекватность, устойчивость и др.).

5. Взаимосвязь

математической модели СК-анализа с другими моделями.

1.2.2.1. Программа

системного обобщения математики и предпосылки системной теории информации

Дадим

определение понятия «система» классическим способом, т.е. путем его подведения

под более общее понятие «множество» и выделение специфических признаков.

Система представляет собой множество элементов, объединенных в целое за счет

взаимодействия элементов друг с другом, т.е. за счет отношений между ними, и

обеспечивающая преимущества в достижении целей. Преимущества в достижении целей

обеспечиваются за счет системного эффекта. Системный эффект состоит в том, что

свойства системы не сводятся к сумме свойств ее элементов, т.е. система как

целое обладает рядом новых, т.е. эмерджентных свойств, которых не было у ее

элементов. Уровень системности тем выше, чем выше интенсивность взаимодействия

элементов системы друг с другом, чем сильнее отличаются свойства системы от

свойств входящих в нее элементов, т.е. чем выше системный эффект, чем

значительнее отличается система от множества. Элементы взаимодействуют

(вступают в отношения) друг с другом с помощью имеющихся у них общих свойств, а

также свойств, которые коррелируют между собой. Таким образом, система

обеспечивает тем большие преимущества в достижении целей, чем выше ее уровень

системности. В частности, система с нулевым уровнем системности вообще ничем не

отличается от множества образующих ее элементов, т.е. тождественна этому

множеству и никаких преимуществ в достижении целей не обеспечивает. Этим самым

обеспечивается выполнение принципа соответствия между понятиями системы и

множества. Из соблюдения это принципа для понятий множества и системы следует и

его соблюдение для понятий, основанных на теории множеств и их системных обобщений.

На

этой основе можно ввести и новое научное понятие: понятие «антисистемы»,

применение которого оправдано в случаях, когда централизация (монополизация,

интеграция) не только не дает положительного эффекта, но даже сказывается

отрицательно. Антисистемой называется система с отрицательным уровнем

системности, т.е. это такое объедение некоторого множества элементов за счет их

взаимодействия в целое, которое препятствует достижению целей.

Фундаментом,

находящимся в самом основании современной математики, является теория множеств.

Эта теория лежит и в основе самого глубокого на сегодняшний день обоснования таких

базовых математических понятий, как «число» и «функция». Определенный период

этот фундамент казался незыблемым. Однако вскоре работы целой плеяды выдающихся

ученых XX века, прежде всего Давида Гильберта, Бертрана Рассела и Курта Гёделя,

со всей очевидностью обнажили фундаментальные логические и лингвистические

проблемы, в частности проявляющиеся в форме парадоксов теории множеств, что в

свою очередь привело к появлению ряда развернутых предложений по пересмотру самых

глубоких оснований математики [20].

В

задачи данной статьи не входит рассмотрение этой интереснейшей проблематики, а

также истории возникновения и развития понятий числа и функции. Отметим лишь,

что кроме рассмотренных в литературе вариантов существует возможность обобщения

всех понятий математики, базирующихся на теории множеств, в частности теории

информации, путем тотальной замены понятия множества на понятие системы и

тщательного отслеживания всех последствий этой замены. Это утверждение будем

называть «программной идеей системного обобщения понятий математики».

Строго

говоря, реализация данной программной идеи потребует прежде всего системного

обобщения самой теории множеств и преобразование ее в математическую теорию

систем, которая будет плавно переходить

в современную теорию множеств при уровне системности стремящемся к нулю. При

этом необходимо заметить, что существующая в настоящее время наука под

названием «Теория систем» ни в коей мере не является обобщением математической

теории множеств и ее не следует путать с математической теорией систем. Вместе

с тем, на наш взгляд, существуют некоторые возможности обобщения ряда понятий

математики и без разработки математической теории систем. К таким понятиям относятся

прежде всего понятия «информация» и «функция».

Системному

обобщению понятия информации посвящены работы автора [5, 6, 9, 10, 11] и

другие, поэтому в данной статье на этом вопросе мы останавливаться не будем.

Отметим лишь, что на основе предложенной системной теории информации (СТИ) были

разработаны математическая модель и методика численных расчетов (структуры

данных и алгоритмы), а также специальный программный инструментарий (система

«Эйдос») автоматизированного системно-когнитивного анализа (АСК-анализ),

который представляет собой системный анализ, автоматизированный путем его

рассмотрения как метода познания и структурирования по базовым когнитивным

операциям.

В

АСК-анализе теоретически обоснована и реализована на практике в форме

конкретной информационной технологии процедура установления новой

универсальной, сопоставимой в пространстве и времени, ранее не используемой

количественной, т.е. выражаемой числами, меры соответствия между событиями или

явлениями любого рода, получившей название «системная мера целесообразности

информации», которая по существу является количественной мерой знаний [10]. Это

является достаточным основанием для того, чтобы назвать эти числа

«когнитивными» от английского слова "cognition" –

"познание".

В

настоящее время функция понимается как соответствие друг другу нескольких

множеств чисел. Поэтому виды функций можно классифицировать по крайней мере в

зависимости от:

–

природы этих чисел (натуральные, целые, дробные, действительные, комплексные и

т.п.);

–

количества и вида множеств чисел, связанных друг с другом в функции (функции

одного, нескольких, многих, счетного или континуального количества аргументов,

однозначные и многозначные функции, дискретные или континуальные функции) [10];

–

степени жесткости и меры силы связи между множествами чисел (детерминистские

функции, функции, в которых в качестве меры связи используется вероятность,

корреляция и другие меры);

–

степени расплывчатости чисел в множествах и самой формы функции (четкие и

нечеткие функции, использование различных видов шкал, в частности интервальных

оценок).

Так

как функции, выявляемые модели предметной области методом АСК-анализа,

связывают друг с другом множества когнитивных чисел, то предлагается называть

их «когнитивными функциями». Учитывая перечисленные возможности классификации

когнитивные функции, можно считать недетерминистскими многозначными функциями

многих аргументов, в которых в качестве меры силы связи между множествами

используется количественная мера знаний, т.е. системная мера целесообразности

информации, основанными на интервальных оценках, номинальных и порядковых

шкалах и шкалах отношений. Отметим, что детерминистские однозначные функции

нескольких аргументов могут рассматриваться как частный случай когнитивных функций,

к которому они сводятся при анализе жестко детерминированной предметной

области, скажем явлений, описываемых классической физикой.

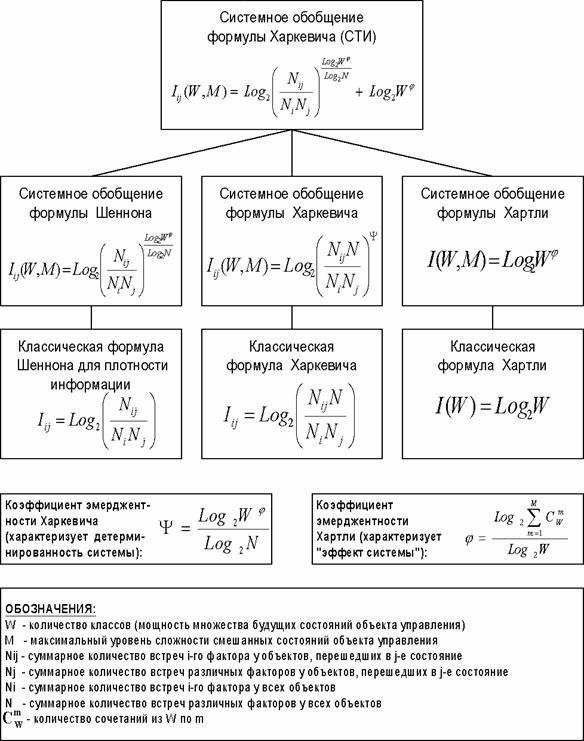

Итак,

предлагается

программная идея системного обобщения понятий математики, в частности теории

информации, основанных на теории множеств, путем замены понятия множества на

более содержательное понятие системы. Частично эта идея была

реализована автором при разработке автоматизированного системно-когнитивного

анализа (АСК-анализа), математическая модель которого основана на системном

обобщении формул для количества информации Хартли и Харкевича. Реализация

следующего шага: системного обобщения понятия функциональной зависимости

рассматривается в работе [87], в ней же вводятся новые научные понятия и

соответствующие термины: «когнитивные функции» и «когнитивные числа». На

численных примерах показано, что АСК-анализ обеспечивает выявление когнитивных

функциональных зависимостей в многомерных зашумленных фрагментированных данных.

1.2.2.2.

Теоретические

основы системной теории информации

1.2.2.2.1.

Требования к математической модели и численной мере

Для практической реализации идеи решения

проблемы необходимо сформулировать требования к математической модели и

численной мере, вытекающие из когнитивной концепции и специфических свойств

активного объекта управления в АПК (слабодетерминированность, многофакторность,

активность).

Требования

к математической модели предусматривают: содержательную

интерпретируемость; эффективную вычислимость на основе непосредственно

эмпирических данных (наличие эффективного численного метода); универсальность;

адекватность; сходимость; семантическую устойчивость; сопоставимость

результатов моделирования в пространстве и времени; непараметричность;

формализацию базовых когнитивных операций системного анализа (прежде всего

таких, как обобщение, абстрагирование, сравнение, классификация и др.);

корректность работы на фрагментарных, неточных и зашумленных данных; возможность

обработки данных очень больших размерностей (тысячи факторов и будущих

состояний объекта управления); математическую и алгоритмическую ясность и

простоту, эффективность программной реализации.

Требования

к численной мере. Ключевым

при построении математических моделей является выбор количественной меры,

обеспечивающей учет степени причинно-следственной взаимосвязи исследуемых

параметров. Эта мера должна удовлетворять следующим требованиям: 1)

обеспечивать эффективную вычислимость на основе эмпирических данных, полученных

непосредственно из опыта; 2) обладать универсальностью, т.е. независимостью

от предметной области; 3) подчиняться единому для различных предметных областей

принципу содержательной интерпретации; 4)

количественно измеряться в единых единицах измерения а количественной шкале

(шкала с естественным нулем, максимумом или минимумом); 5) учитывать понятия:

"цели объекта управления", "цели управления";

"мощность множества будущих состояний объекта управления"; уровень

системности объекта управления; степень детерминированности объекта управления;

6) обладать сопоставимостью в пространстве и во времени; 7) обеспечивать

возможность введения метрики или неметрической функции принадлежности на базе

выбранной количественной меры.

Для того, чтобы выбрать тип (класс) модели,

удовлетворяющей сформулированным требованиям, необходимо решить на какой форме

информации эта модель будет основана: абсолютной, относительной или аналитической.

1.2.2.2.2. Выбор базовой численной меры

Абсолютная,

относительная и аналитическая информация.

Широко

известны абсолютная и относительная формы информации. Абсолютная форма – это

просто количество, частота. Относительная форма – это доли, проценты,

относительные частоты и вероятности.

Менее

знакомы специалисты с аналитической формой информации, примером которой

является условные вероятности, стандартизированные статистические значения, эластичность

и количество информации.

Очевидно,

что и из относительной информации, взятой изолированно, вырванной из контекста,

делать какие-либо обоснованные выводы не представляется возможным. Для того,

чтобы о чем-то судить по процентам, нужен их сопоставительный анализ, т.е. анализ всего процентного распределения. Обычно для используется "база

оценки", в качестве которой используется среднего по всей совокупности или

"скользящее среднее" (нормативный подход: норма – среднее).

Аналитическая

(сопоставительная) информация – это информация, содержащаяся в отношении вероятности (или процента) к

некоторой базовой величине, например

к средней вероятности по всей выборке. Аналитическими являются также стандартизированные

величины в статистике и количество информации в теории информации.

Очевидно,

именно аналитическая информация является наиболее кондиционной для употребления

с той точки зрения, что позволяет непосредственно делать содержательные выводы

об исследуемой предметной области (точнее будет сказать, что она сама и

является выводом), тогда как для того, чтобы сделать аналогичные выводы на

основе относительной, и особенно абсолютной информации требуется ее

значительная предварительная обработка.

Выбор в качестве базовой численной меры

количества информации

Как

было показано в лекции 2, системный анализ представляет собой теоретический

метод познания, т.е. информационный процесс, в котором поток информации

направлен от познаваемого объекта к познающему субъекту. Процесс труда,

напротив, представляет собой процесс, в

котором поток информации направлен от субъекта к объекту. При этом информация

передается по каналу связи, представляющему собой средства труда, и записывается

в носитель информации (предмет труда), который в ходе этого процесса

преобразуется в заранее заданную форму, т.е. в продукт труда.

Таким образом, процесс труда по сути дела представляет собой информационный

процесс, обратный по направлению потока информации процессу познания.

Управление представляет собой процесс, на различных этапах которого выполняются

функции, сходные с процессами труда (управляющее воздействие) и познания

(обратная связь). По мнению автора, информационный подход к управлению является

наиболее общим. Поэтому

в качестве количественной меры взаимосвязи факторов и будущих состояний АОУ

целесообразно использовать количество информации. Более подробное

обоснование целесообразности выбора в качестве численной меры количества информации

приведено в работе автора [81].

Однако,

известно много различных информационных мер и, следовательно, возникает задача

выбора одной из них, оптимальной по выбранным критериям. Различные выражения

классической теории информации для количества информации: Хартли, Шеннона,

Харкевича и др., учитывают различные аспекты информационного моделирования

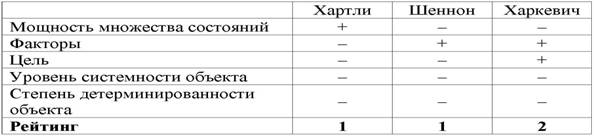

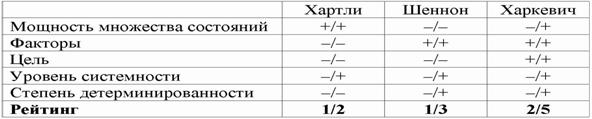

объектов (таблице 8):

|

Таблица 8 – СООТВЕТСТВИЕ ТРЕБОВАНИЯМ |

|

|

–

формула Хартли учитывает количество классов (мощность множества состояний

объекта управления) но никак не учитывает их признаков или факторов,

переводящих объект в эти состояния, т.е. содержит интегральное описание

объектов;

–

формула Шеннона основывается на учете признаков, т.е. основывается на

дискретном описании объектов;

–

формула Харкевича учитывает понятие цели и также как формула Шеннона основана

на статистике признаков, но не учитывает мощности множества будущих состояний

объекта управления, включающего целевые и другие будущие состояния объекта

управления и также как формула Шеннона основывается на дискретном описании

объектов.

Как

видно из таблицы 8, классическая формула Харкевича по учитываемым критериям

имеет преимущества перед классическими формулами Хартли и Шеннона, т.к.

учитывает как факторы, так и понятие цели, ключевое для системного

анализа, теории и практики управления (в т.ч. АСУ). Поэтому именно

выражение для семантической целесообразности информации Харкевича взято за

основу при выводе обобщающего выражения, удовлетворяющего всем предъявляемым

требованиям.

1.2.2.2.3. Конструирование системной

численной меры на основе базовой

Системное

обобщение формулы Хартли для количества информации

Классическая

формула Хартли имеет вид:

|

|

Будем

искать ее системное обобщение в виде:

|

|

где:

W –

количество чистых (классических) состояний системы.

j – коэффициент эмерджентности Хартли (уровень

системной организации объекта, имеющего W чистых состояний);

Учитывая,

что возможны смешанные состояния, являющиеся

нелинейной суперпозицией или одновременной реализацией чистых (классических)

состояний "из W по m", всего возможно ![]() состояний системы, являющихся сочетаниями классических

состояний. Таким образом, примем за аксиому, что системное

обобщение формулы Хартли имеет вид [81]:

состояний системы, являющихся сочетаниями классических

состояний. Таким образом, примем за аксиому, что системное

обобщение формулы Хартли имеет вид [81]:

|

|

где:

W – количество элементов в системе альтернативных будущих состояний АОУ

(количество чистых состояний); m – сложность смешанных состояний АОУ; M – максимальная

сложность смешанных состояний АОУ.

Выражение

(1) дает количество информации в активной системе, в которой чистые и смешанные

состояния равновероятны. Смешанные состояния активных систем, возникающие под

действием системы нелинейно-взаимодействующих факторов, считаются такими же

измеримыми, как и чистые альтернативные состояния, возникающие под действием

детерминистских факторов. Так как ![]() , то при M=1 выражение (3.3) приобретает вид (3.1), т.е.

выполняется принцип соответствия, являющийся

обязательным для более общей теории.

, то при M=1 выражение (3.3) приобретает вид (3.1), т.е.

выполняется принцип соответствия, являющийся

обязательным для более общей теории.

Рассмотрим

подробнее смысл выражения (3.3), представив сумму в виде ряда слагаемых:

|

|

Первое

слагаемое в (3.4) дает количество информации по классической формуле Хартли, а

остальные слагаемые – дополнительное

количество информации, получаемое за счет системного эффекта, т.е. за счет

наличия у системы иерархической структуры или смешанных состояний. По сути дела эта дополнительная информация

является информацией об иерархической структуре системы, как состоящей из ряда

подсистем различных уровней сложности.

Например, пусть система состоит из W пронумерованных

элементов 1-го уровня иерархии. Тогда на 2-м уровне иерархии элементы соединены

в подсистемы из 2 элементов 1-го уровня, на 3-м – из 3, и т.д. Если выборка

любого элемента равновероятна, то из факта выбора n-го элемента по классической

формуле Хартли мы получаем количество информации согласно (3.1). Если же при

этом известно, что данный элемент входит

в определенную подсистему 2-го уровня, то это дает дополнительное количество

информации, за счет учета второго слагаемого, поэтому общее количество

получаемой при этом информации будет определяться выражением (3.4) уже с двумя

слагаемыми (M=2). Если элемент одновременно входит в M подсистем разных

уровней, то количество информации, получаемое о системе и ее подсистемах при

выборке этого элемента определяется выражением (3.4). Так, если мы вытаскиваем

кирпич из неструктурированной кучи, состоящей из 32 кирпичей, то получаем 5 бит

информации, если же из этих кирпичей сложен дом, то при аналогичном действии мы

получаем дополнительное количество информации о том, из каких части дома

(подсистем различного уровня иерархии) вытащен этот кирпич. Действия каменщика,

укладывающего кирпич на место, предусмотренное проектом, значительно выше по целесообразности, чем у грузчика,

складывающего кирпичи в кучу. Учитывая, что при M=W:

|

|

в

этом случае получаем:

|

|

Выражение

(3.5) дает оценку максимального

количества информации, которое может содержаться в элементе системы с

учетом его вхождения в различные подсистемы ее иерархической структуры.

Однако

реально в любой системе осуществляются не все формально возможные сочетания

элементов 1-го уровня иерархии, т.к. существуют различные правила запрета, различные для разных систем. Это

означает, что возможно множество различных систем, состоящих из одинакового

количества тождественных элементов, и отличающихся своей структурой, т.е.

строением подсистем различных иерархических уровней. Эти различия систем как

раз и возникают благодаря различию действующих для них этих правил запрета. По

этой причине систему правил запрета

предлагается назвать информационным

проектом системы. Различные системы, состоящие из равного количества

одинаковых элементов (например, дома, состоящие из 20000 кирпичей), отличаются

друг от друга именно по причине различия своих информационных проектов.

Из

выражения (3.5) очевидно, что I быстро стремится к W:

|

|

В

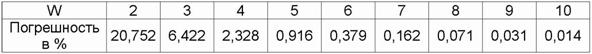

действительности уже при W>4 погрешность выражения (3.5) не превышает 1%

(таблица 9):

|

Таблица 9 – ЗАВИСИМОСТЬ ПОГРЕШНОСТИ |

|

|

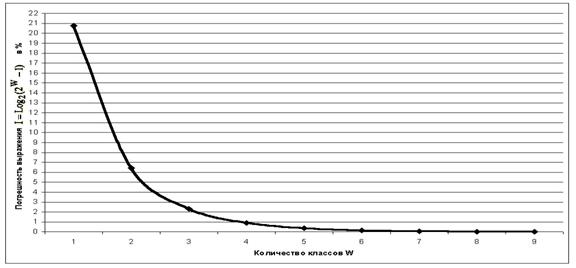

График

зависимости погрешности выражения (3.5) от количества классов W приведен на

рисунке 24.

|

|

|

Рисунок 24. Зависимость погрешности приближенного выражения системного

обобщения формулы Хартли от количества классов W |

Приравняв

правые части выражений (3.2) и (3.3):

|

|

получим

выражение для коэффициента эмерджентности Хартли (терм. авт.):

|

|

Непосредственно из вида выражения для

коэффициента эмерджентности Хартли (3.9) ясно, что он представляет собой

относительное превышение количества информации о системе при учете системных

эффектов (смешанных состояний, иерархической структуры ее подсистем и т.п.) над

количеством информации без учета системности, т.е. этот коэффициент отражает уровень системности объекта.

С

учетом выражения (3.9) выражение (3.2) примет вид:

|

|

или

при M=W и больших W, учитывая (3.4 – 3.6):

|

|

Выражение

(3.10) и представляет собой искомое системное обобщение классической формулы

Хартли, а выражение (3.11) – его достаточно хорошее приближение при большом

количестве элементов или состояний системы (W).

Коэффициент эмерджентности Хартли представляет собой

относительное превышение количества информации о системе при учете системных

эффектов (смешанных состояний, иерархической структуры ее подсистем и т.п.) над

количеством информации без учета системности, т.е. этот коэффициент является

аналитическим выражением для уровня

системности объекта. Таким образом, коэффициент эмерджентности Хартли отражает уровень

системности объекта и изменяется от 1 (системность минимальна, т.е. отсутствует)

до W/Log2W (системность максимальна). Очевидно, для

каждого количества элементов системы существует свой максимальный уровень

системности, который никогда реально не достигается из-за действия правил

запрета на реализацию в системе ряда подсистем различных уровней

иерархии.

Например: из 32 букв русского

алфавита может быть образовано не ![]() осмысленных

6-буквенных слов, а значительно меньше. Если мы услышим одно из этих в принципе

возможных слов, то получим не 5´6=30 информации,

содержащейся непосредственно в буквах (в одной букве содержится Log232=5

бит), а 30+19,79=49,79 бит, т.е. в 1.66 раз больше. Это и есть уровень системности иерархического уровня 6-буквенных

слов русского языка. Уровень системности русского языка, как системы, состоящей из слов длиной от одной до 6 букв, согласно

выражения (3.9) с учетом (3.5), равен примерно 6,4. Но при этом еще не была

учтена информация, содержащаяся в последовательности слов, в последовательности

предложений и т.д.

осмысленных

6-буквенных слов, а значительно меньше. Если мы услышим одно из этих в принципе

возможных слов, то получим не 5´6=30 информации,

содержащейся непосредственно в буквах (в одной букве содержится Log232=5

бит), а 30+19,79=49,79 бит, т.е. в 1.66 раз больше. Это и есть уровень системности иерархического уровня 6-буквенных

слов русского языка. Уровень системности русского языка, как системы, состоящей из слов длиной от одной до 6 букв, согласно

выражения (3.9) с учетом (3.5), равен примерно 6,4. Но при этом еще не была

учтена информация, содержащаяся в последовательности слов, в последовательности

предложений и т.д.

Итак, в предложении сдержится значительно больше информации,

чем в буквах, с помощью которых оно написано, т.к. кроме букв информацию

содержат слова, сочетания слов, последовательность предложений и т.д.. Буквы

образуют 1-й иерархический уровень языка, слова – 2-й, предложения – 3-й,

абзацы – 4-й, параграфы – 5-й, главы – 6-й, произведения – 7-й. Теория Шеннона

концентрирует основное внимание на рассмотрении 1-го уровня, т.е. рассматривает

тексты, прежде всего, как последовательность символов. Но именно иерархическая

организация, не учитываемая в теории Шеннона и отраженная в системной теории

информации, обеспечивает языку его

удивительную мощь, как средства отражения и моделирования реальности.

Аналогично

и в генах, этих своеобразных "символах генома", содержится значительно

больше информации о фенотипе, чем предполагается в классической генетике

Менделя, т.к. гены образуют ансамбли

различных уровней иерархии в зависимости от влияния среды и технологий

управления (явление адаптивности системы "генотип-среда", Драгавцев

В.А., 1993). Если ген уподобить букве алфавита, а смысл фразы – фенотипическому

признаку, то можно сказать, что возможно очень большое количество фраз с практически

тождественным смысловым содержанием (тогда как в классической генетике

считалось, что признак соответствует гену, хотя есть и такие). После

расшифровки генома человека мы настолько же приблизились к его пониманию, как

изучивший русскую или немецкую азбуку англичанин, не знающий этих языков,

приблизился к чтению в оригинале и пониманию содержания "Войны и

Мира" Льва Толстого или "Феноменологии Духа" Георга В.Ф.Гегеля.

На

уровне слов верхняя оценка уровня системности русского языка с учетом (3.5)

составляет огромную величину: 2616,48 (предполагается, что в русском языке

40000 слов и предложения могут иметь любую длину). Необходимо отметить, что правила запрета на порядок слов в русском

языке значительно слабее, чем, например в английском, поэтому в русском языке

возможно гораздо больше грамматически правильных и несущих различную информацию

предложений из одних и тех же слов, чем в английском. Это значит, что

уровень системности русского языка на уровне предложений, по-видимому,

значительно превосходит уровень системности английского языка. При длине

предложения до 2-х слов системность русского языка на уровне предложений

согласно (3.9) составляет: 52330916.

Анализ

выражения (3.9) показывает, что при М=1 оно преобразуется в (3.1), т.е. выполняется принцип соответствия. При

М>1 количество информации в соответствии с системной теорией информации

(СТИ) (3.9) будет превосходить количество информации, рассчитанное по

классической теории информации (КТИ) (3.1). Непосредственно из выражения (3.2)

получаем:

|

|

Первое

слагаемое в выражении (3.12) отражает количество информации, согласно КТИ, а

второе – СТИ, т.е. доля системной информации.

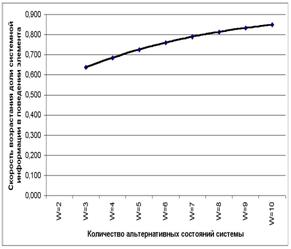

Представляет

несомненный интерес исследование закономерностей изменения доли системной

информации в поведении элемента системы в зависимости от количества классов W и

сложности смешанных состояний M.

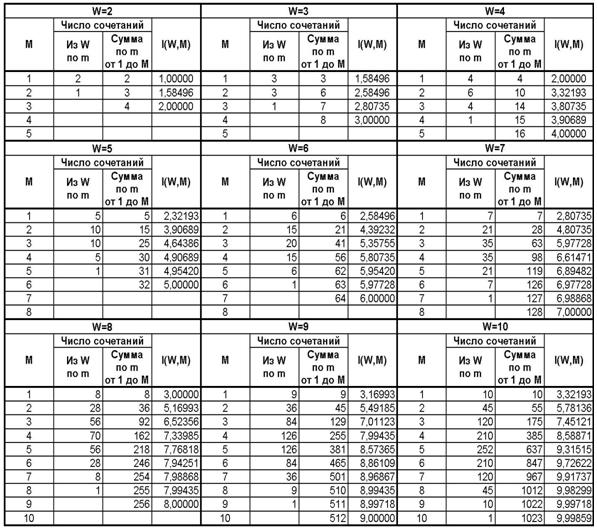

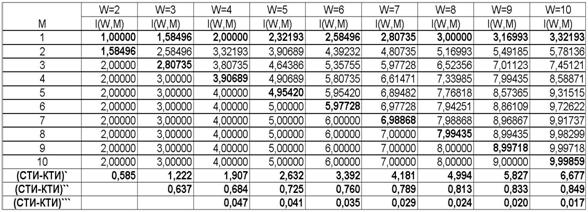

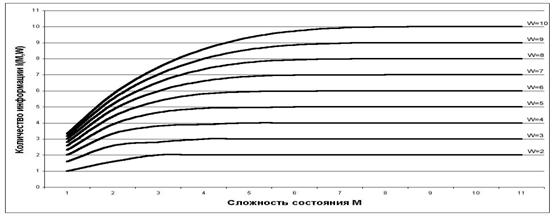

В

таблице 10 приведены результаты численных расчетов в соответствии с выражением

(3.9). Сводные

данные из таблицы 10 приведены в таблице 11, а в графическом виде они представлены

на рисунке 25.

Таблица 10 – ЗАВИСИМОСТЬ I(W,M) ОТ КОЛИЧЕСТВА

КЛАССОВ W И СЛОЖНОСТИ СМЕШАННЫХ СОСТОЯНИЙ М

|

|

Таблица 11 – ЗАВИСИМОСТЬ КОЛИЧЕСТВА ИНФОРМАЦИИ I(W,M) ОТ СЛОЖНОСТИ

СМЕШАННЫХ СОСТОЯНИЙ M ДЛЯ РАЗЛИЧНОГО КОЛИЧЕСТВА КЛАССОВ W

|

|

|

|

|

Рисунок 25. Зависимость количества информации I(W,M) |

Рост

количества информации в СТИ по сравнению с КТИ обусловлен системным эффектом

(эмерджентностью), который связан с учетом смешанных состояний, возникающих

путем одновременной реализации (суперпозиции) нескольких чистых (классических)

состояний под действием системы нелинейно-взаимодействующих недетерминистских

факторов. Выражение (3.9) дает максимальную возможную оценку количества информации,

т.к. могут существовать различные правила

запрета на реализацию тех или иных смешанных состояний.

Фактически

это означает, что в СТИ множество возможных состояний объекта рассматривается

не как совокупность несвязанных друг с другом состояний, как в КТИ, а как система, уровень системности которой как

раз и определяется коэффициентом эмерджентности Хартли j (3.9), являющегося монотонно возрастающей

функцией сложности смешанных состояний M. Следовательно, дополнительная информация, которую мы получаем из поведения объекта в

СТИ, по сути дела является информацией о системе всех возможных состояний

объекта, элементом которой является объект в некотором данном состоянии.

Гипотеза

о законе возрастания эмерджентности и следствия из него

Численные

расчеты и аналитические выкладки в соответствии с СТИ показывают, что при

возрастании количества элементов в системе доля системной информации в

поведении ее элементов возрастает. Это обнаруженное нами новое фундаментальное

свойство систем предлагается назвать законом возрастания эмерджентности.

Закон

возрастания эмерджентности: "Чем больше элементов в системе, тем

большую долю содержащейся в ней информации составляет информация, содержащаяся

во взаимосвязях ее элементов".

На

рисунках 26 и 27 приведены графики скорости и ускорения возрастания

эмерджентности в зависимости от количества элементов W в системе.

|

|

|

|

Рисунок 26. Возрастание доли системной информации в поведении

элемента системы при увеличении количества элементов W |

Рисунок 27. Ускорение возрастания доли системной информации в

поведении элемента системы от количества элементов W |

Более

детальный анализ предполагаемого закона возрастания эмерджентности с

использованием конечных разностей первого и второго порядка (таблица 11)

показывает, что при увеличении количества элементов в системе доля системной информации

в ней возрастает с ускорением, которое постепенно уменьшается.

Это утверждение будем называть леммой 1.

Продолжим

анализ закона возрастания эмерджентности. Учитывая, что:

|

|

|

выражение (3.3) принимает вид:

|

|

где: 1<=М<=W.

|

|

|

и учитывая, что Log21=0, выражение

(3.13) приобретает вид:

|

|

Где введены обозначения:

|

|

С учетом (3.14) выражение (3.9) для

коэффициента эмерджентности Хартли приобретает вид:

|

|

|

Заменяя в (3.13) факториал на Гамма-функцию,

получаем обобщение выражения (3.3) на непрерывный случай:

|

|

|

Или окончательно:

|

|

Для непрерывного случая обозначения (3.15)

принимают вид:

|

|

Учитывая выражения (3.9) и (3.16) получим

выражение для коэффициента эмерджентности Хартли для непрерывного случая:

|

|

|

И окончательно для непрерывного случая:

|

|

(3. 18) |

Анализируя выражения (3.14) и (3.16) видим,

что количество информации, получаемое при выборке из системы некоторого ее

элемента, состоит из двух слагаемых:

1) I(W), зависящего только от количества

элементов в системе W (первое слагаемое);

2) I(W, M), зависящего как от количества

элементов в системе W, так и от максимальной сложности, т.е. связности элементов

подсистем M между собой (второе слагаемое).

Этот

результат позволяет высказать гипотезы

"О природе сложности системы" и "О видах системной

информации":

–

сложность системы определяется количеством содержащейся в ней информации;

–

системная информация включает две составляющих: зависящее от количества

элементов системы и зависящее также от характера взаимосвязей между элементами.

Изучим какой относительный вклад вносит

каждое слагаемое в общее количество информации системы в зависимости от числа

элементов в системе W и сложности подсистем M. Результаты численных расчетов

показывают, что чем выше уровень

системности, тем большая доля информации системы содержится во взаимосвязях ее

элементов, и чем меньше элементов с системе, тем быстрее возрастает доля

информации, содержащейся во взаимосвязях элементов при возрастании уровня системности. Эти утверждения будем

рассматривать как леммы 2 и 3. Таким образом полная формулировка гипотезы о

законе возрастания эмерджентности с гипотезой о видах информации в системе и

тремя леммами приобретает вид:

Гипотеза о законе возрастания эмерджености:

"Чем

больше элементов в системе, тем большую долю содержащейся в ней информации составляет

информация, содержащаяся во взаимосвязях ее элементов" (рисунок 28).

Гипотеза 1: "О природе сложности

системы": сложность системы определяется количеством

содержащейся в ней информации.

Гипотеза 2: "О видах системной

информации": системная информация включает две

составляющие:

–

зависящую от количества элементов системы;

–

зависящую как от количества элементов системы, так и от сложности взаимосвязей

между ними.

Лемма-1: при увеличении количества элементов в

системе доля системной информации в ней возрастает с ускорением, которое

постепенно уменьшается.

Лемма-2: чем выше уровень системности, тем большая доля

информации системы содержится во взаимосвязях ее элементов.

Лемма-3: чем

меньше элементов в системе, тем быстрее возрастает доля информации, содержащейся

во взаимосвязях элементов при возрастании

уровня системности.

|

|

|

Рисунок 28. Закон возрастания эмерджентности |

Системное

обобщение классической формулы Харкевича, как количественная мера знаний

Это

обобщение представляет большой интерес, в связи с тем, что А.Харкевич впервые ввел в теорию информации понятие цели. Он

считал, что количество информации, сообщенное объекту, можно измерять по

изменению вероятности достижения цели этим объектом за счет использования им этой

информации.

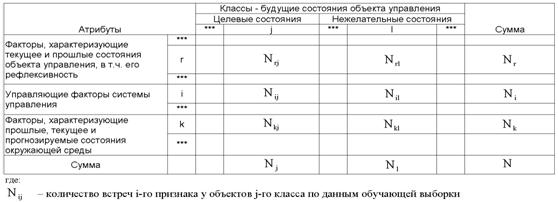

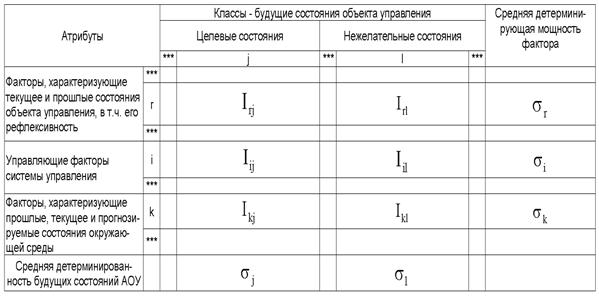

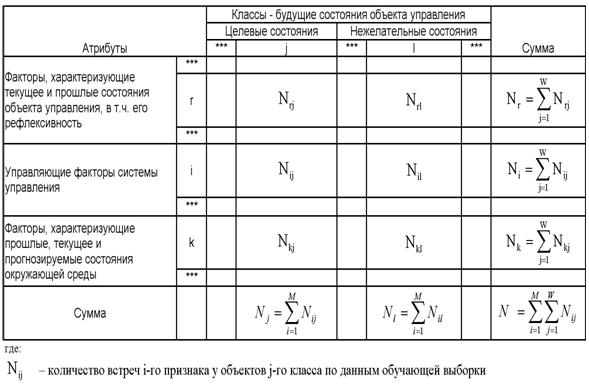

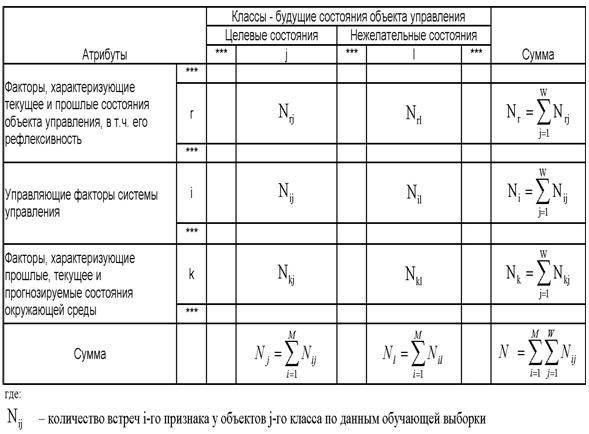

Рассмотрим таблицу 12, в которой столбцы

соответствуют будущим состояниям АОУ (целевым и нежелательным), а строки

факторам, характеризующим объект управления, управляющую систему и окружающую

среду.

|

|

Классическая

формула А.Харкевича имеет вид:

|

|

где:

–

W – количество классов (мощность

множества будущих состояний объекта управления); M – максимальный уровень

сложности смешанных состояний объекта управления;

–

индекс i обозначает фактор: 1£ i £ M; индекс j обозначает класс: 1£ j £ W;

– Pij

– вероятность достижения объектом управления j-й цели при условии сообщения ему

i-й информации;

– Pj

– вероятность самопроизвольного достижения объектом управления j-й цели.

Из

3.19 видно, что формула Харкевича для

семантической меры информации по сути является логарифмом от формулы Байеса

(отношение условной вероятности к безусловной).

Ниже

глобальные параметры модели W и M в выражениях для I опускаются, т.к. они

являются константами для конкретной математической модели СК-анализа.

Однако:

А.Харкевич в своем выражении для количества информации не ввел зависимости

количества информации, от мощности

пространства будущих состояний объекта управления, в т.ч. от количества его

целевых состояний. Вместе с тем, один из возможных вариантов учета количества

будущих состояний объекта управления обеспечивается классической и системной

формулами Хартли (3.1) и (3.9); выражение

(3.19) при подстановке в него реальных численных значений вероятностей Pij

и Pj не дает количества информации в битах; для выражения (3.19) не

выполняется принцип соответствия, считающийся обязательным для обобщающих

теорий. Возможно, в этом состоит одна из причин слабого взаимодействия между

классической теорией информации Шеннона и семантической теорией информации.

Чтобы

снять эти вопросы, приближенно выразим вероятности Pij, Pi

и Pj через частоты:

|

|

В

(3.20) использованы обозначения:

Nij

– суммарное количество наблюдений факта: "действовал i-й фактор и объект

перешел в j-е состояние";

Nj – суммарное количество встреч различных

факторов у объектов, перешедших в j-е состояние;

Ni – суммарное количество встреч i-го фактора у

всех объектов;

N – суммарное количество встреч различных

факторов у всех объектов.

Подставим

в выражение (3.19) значения для Pij и Pj из (3.20):

|

|

Введем

коэффициент эмерджентности Y в модифицированную формулу А.Харкевича:

|

|

где:

Y –

коэффициент эмерджентности Харкевича (как будет показано выше, он определяет

степень детерминированности объекта с уровнем системной организации j, имеющего W чистых состояний, на переходы в

которые оказывают влияние M факторов, о чем в модели накоплено N фактов).

Известно, что классическая формула Шеннона для количества

информации для неравновероятных событий преобразуется в формулу Хартли при условии,

что события равновероятны, т.е. удовлетворяет фундаментальному принципу соответствия [81].

Естественно

потребовать, чтобы и обобщенная формула Харкевича также удовлетворяла

аналогичному принципу соответствия, т.е. преобразовывалась в формулу Хартли в

предельном случае, когда каждому классу (состоянию объекта) соответствует один

признак (фактор), и каждому признаку – один класс, и эти классы (а, значит и

признаки), равновероятны. Иначе говоря факторов

столько же, сколько и будущих состояний объекта управления, все факторы

детерминистские, а состояния объекта управления – альтернативные, т.е. каждый

фактор однозначно определяет переход объекта управления в определенное

состояние.

В этом предельном случае отпадает необходимость двухвекторного

описания объектов, при котором 1-й вектор (классификационный) содержит интегральное

описание объекта, как принадлежащего к определенным классам, а 2-й вектор (описательный)

– дискретное его описание, как имеющего определенные атрибуты. Соответственно,

двухвекторная модель, предложенная в данной работе, преобразуется в

"вырожденный" частный случай – стандартную статистическую модель. В

этом случае количество информации, содержащейся в признаке о принадлежности

объекта к классу является максимальным

и равным количеству информации, вычисляемому по системной формуле Хартли (3.9).

Таким образом при взаимно-однозначном соответствии

классов и признаков:

|

|

формула А.Харкевича (3.13) приобретает вид:

|

|

откуда:

|

|

или, учитывая выражение для коэффициента

эмерджентности Хартли (3.8):

|

|

Смысл коэффициента эмерджентности Харкевича (3.25)

проясняется, если учесть, что при количестве состояний системы W равном

количеству фактов N о действии на эту систему различных факторов он равен 1. В

этом случае факторы однозначно

определяют состояния объекта управления, т.е. являются детерминистскими. Если

же количество фактов N о действии на эту систему различных факторов превосходит

количество ее состояний W, что является гораздо более типичным случаем, то этот

коэффициент меньше 1. По-видимому, это означает, что в этом случае факторы как

правило не однозначно (и не так жестко как детерминистские) определяют

поведение объекта управления, т.е. являются статистическими.

Таким образом, коэффициент эмерджентности Харкевича Y изменяется от 0 до 1 и

определяет степень детерминированности системы:

– Y=1 соответствует полностью

детерминированной системе, поведение которой однозначно определяется действием

минимального количества факторов, которых столько же, сколько состояний системы;

– Y=0 соответствует полностью

случайной системе, поведение которой никак не зависит действия факторов независимо

от их количества;

– 0<Y<1 соответствуют

большинству реальных систем поведение которых зависит от многих факторов, число

которых превосходит количество состояний системы, причем ни одно из состояний

не определяется однозначно никакими сочетаниями действующих факторов (рисунок

29):

|

|

|

Рисунок 29. Интерпретация коэффициентов |

Из

выражения (3.25) видно, что в частном случае, когда реализуются только чистые

состояния объекта управления, т.е. M=1, коэффициент эмерджентности А.Харкевича

приобретает вид:

|

|

Подставив

коэффициент эмерджентности А.Харкевича (3.25) в выражение (3.22), получим:

|

|

|

или окончательно:

|

|

Из вида

выражения (3.25) для Y очевидно, что увеличение уровня системности влияет на

семантическую информационную модель (3.28) аналогично повышению уровня

детерминированности системы: понижение

уровня системности, также как и степени детерминированности системы приводит к

ослаблению влияния факторов на поведение системы, т.е. к понижению

управляемости системы за счет своего рода "инфляции факторов".

Например: управлять толпой из 1000

человек значительно сложнее, чем воздушно-десантным полком той же численности.

Процесс превращения 1000 новобранцев в воздушно-десантный полк это и есть

процесс повышения уровня системности и степени детерминированности системы.

Этот процесс включает процесс иерархического структурирования (на отделения,

взвода, роты, батальоны), а также процесс повышения степени детерминированности

команд, путем повышения "степени беспрекословности" их исполнения.

Оркестр, настраивающий инструменты, также весьма существенно отличается от

оркестра, исполняющего произведение под управлением дирижера.

Необходимо отметить, что при повторном использовании той же самой обучающей выборки степень

детерминированности модели уменьшается. Очевидно, с формальной математической

точки зрения этого явления можно избежать, если перед расчетом информативностей

признаков делить абсолютные частоты на количество объектов обучающей выборки.

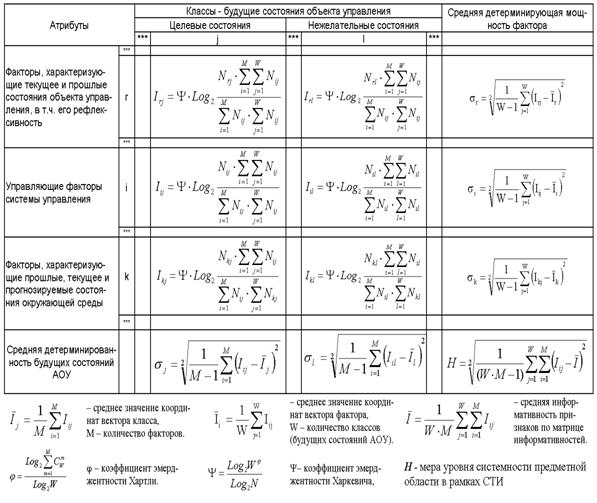

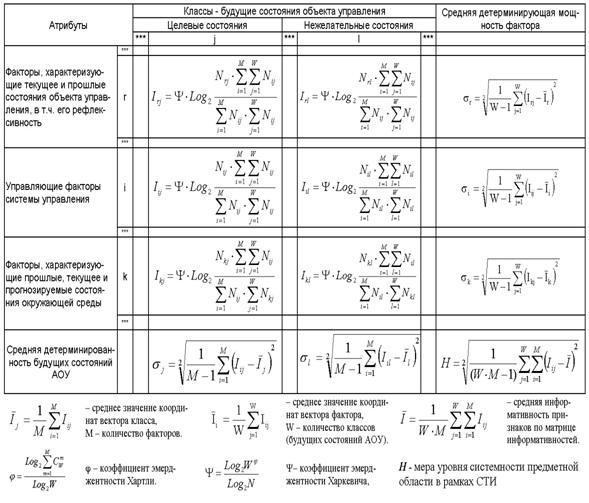

С использованием выражения (3.28) непосредственно из

матрицы абсолютных частот (таблица 12) рассчитывается матрица информативностей

(таблица 13), содержащая связи между факторами и будущими состояниями АОУ и

имеющая много различных интерпретаций и играющая основополагающую роль в данном

исследовании.

|

|

Из рассмотрения основополагающего выражения (3.28) видно,

что:

1. При выполнении условий взаимно-однозначного соответствия

классов и признаков (3.23) первое слагаемое в выражении (3.28) обращается в

ноль и при всех реальных значениях входящих в него переменных оно отрицательно.

2. Выражение (3.28) является нелинейной суперпозицией

двух выражений: системного общения формулы Хартли (второе слагаемое), и первого

слагаемого, которое имеет вид формулы

Шеннона для плотности информации и отличается от него тем, что выражение под

логарифмом находится в степени, которая совпадает с коэффициентом

эмерджентности Харкевича, а также способом

взаимосвязи входящих в него абсолютных частот с вероятностями.

Это дает

основание предположить, что первое слагаемое в выражении (3.28) является одной

из форм системного обобщения выражения Шеннона для плотности информации:

|

|

Поэтому вполне оправданным будет назвать степень в

(3.29) коэффициентом эмерджентности Шеннона-Харкевича.

Генезис системной

(эмерджентной) теории информации

Полученное

системное обобщение формулы Харкевича (3.28) учитывает как взаимосвязь между

признаками (факторами) и будущими, в т.ч. целевыми состояниями объекта управления,

так и мощность множества будущих состояний объекта управления. Кроме того она

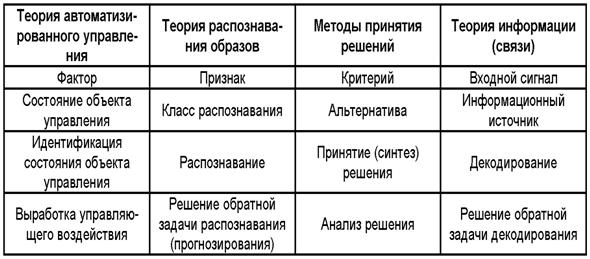

объединяет возможности интегрального и дискретного описания объектов, учитывает

уровень системности и степень детерминированности описываемой системы (таблица

14):

|

|

При этом факторами являются управляющие факторы, т.е.

управления со стороны системы управления, факторы окружающей среды, а также

факторы, характеризующие текущее и прошлые состояния объекта управления. Все

это делает полученное выражение (3.28) оптимальным по сформулированным критериям

для целей построения содержательных информационных моделей активных объектов

управления и для применения для синтеза адаптивных систем управления (см.

диаграмму: "Генезис системного обобщения формулы Харкевича для количества

информации", рисунок 30).

|

|

|

Рисунок 30. Генезис системной (эмерджентной) теории информации |

Итак,

различные выражения классической теории информации для количества информации:

Хартли, Шеннона и Харкевича учитывают различные аспекты информационного

моделирования объектов.

Полученное системное обобщение формулы

А.Харкевича (3.28) учитывает как взаимосвязь между признаками (факторами) и

будущими, в т.ч. целевыми состояниями объекта управления, так и мощность

множества будущих состояний. Кроме того она объединяет возможности

интегрального и дискретного описания объектов, учитывает уровень системности и

степень детерминированности системы.

Различие

между классическим понятием информации и его предложенным системным обобщением

определяется различием между понятиями множества и системы, на основе которых

они сформированы. Система при этом рассматривается как множество элементов,

объединенных определенными видами взаимодействия ради достижения некоторой

общей цели.

Все это делает полученное выражение (3.28)

оптимальным по сформулированным критериям для целей построения содержательных

информационных моделей активных объектов управления и для применения для

синтеза рефлексивных АСУ активными объектами.

1.2.2.3. Семантическая информационная модель

СК-анализа

Основная

проблема, решаемая в аналитической модели: выбор способа вычисления весовых

коэффициентов, отражающих степень и характер влияния факторов на переход

активного объекта управления в различные состояния.

Основное отличие

предлагаемого подхода от методов обобщения экспертных оценок состоит в том, что

в предлагаемом подходе от экспертов требуется лишь само решение, а весовые

коэффициенты автоматически подбираются в соответствии с моделью таким образом,

что в сходных случаях будут приниматься решения, аналогичные предлагаемым

экспертами. В традиционных подходах от экспертов требуют либо самих весовых коэффициентов,

либо правил принятия решения (продукций).

1.2.2.3.1.

Формализм динамики взаимодействующих семантических информационных пространств. Двухвекторное

представление данных.

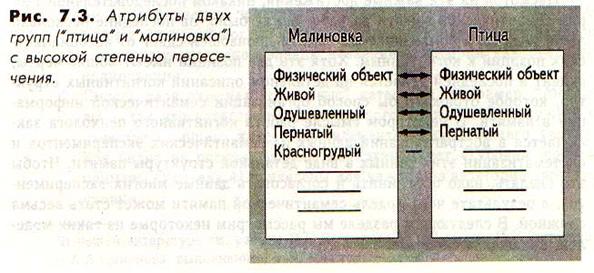

Не

всегда и не все классы являются атрибутами, также не всегда и не все атрибуты

являются классами по смыслу (в данной модели это может быть так в многослойной

нейронной сети) Поэтому традиционное представление данных в форме одной матрицы

с одинаковыми строками и столбцами представляется нецелесообразным и

предлагается более общее – двухвекторное представление. В предлагаемой

математической модели формальное описание объекта представляет собой совокупность

его интенсионального и экстенсионального описаний.

Интенсиональное (дискретное) описание – это последовательность

информативностей (но не кодов) тех и только тех признаков, которые реально

фактически встретились у данного конкретного объекта.

Экстенсиональное (континуальное) описание состоит из

информативностей (но не кодов) тех классов распознавания, для формирования образов которых по мнению экспертов целесообразно

использовать интенсиональное описание данного конкретного объекта.

Именно взаимодействие и взаимная

дополнительность этих двух взаимоисключающих видов описания объектов формирует

то, что психологи, логики и философы называют "смысл".

Таким

образом, формальное описание объекта в предлагаемой модели состоит из двух

векторов. Первый вектор описывает к каким обобщенным категориям (классам

распознавания) относится объект с точки зрения экспертов (вектор субъективной,

смысловой, человеческой оценки). Второй же вектор содержит информацию о том,

какими признаками обладает данный объект (вектор объективных характеристик).

Необходимо особо подчеркнуть, что связь этих двух векторов друг с другом имеет вообще говоря не

детерминистский, а вероятностный, статистический характер.

Если

объект описан обоими векторами, то это описание можно использовать для

формирования обобщенных образов классов распознавания, а также для проверки степени успешности выполнения этой задачи.

Если

объект описан только вторым вектором – вектором признаков, то его можно

использовать только для решения задачи распознавания (идентификации), которую

можно рассматривать как задачу восстановления вектора классов данного объекта

по его известному вектору признаков.

Предлагаемая

модель удовлетворяет принципу соответствия, т.е. в ней одновекторный вариант

описания предметной области получается как некоторое подмножество из возможных в ней вариантов, определяемое двумя ограничениями:

–

справочник классов распознавания тождественно совпадает со справочником признаков;

–

наличие какого-либо признака у объекта обучающей выборки однозначно (детерминистским образом) определяет принадлежность

этого объекта к соответствующему классу распознавания (взаимно-однозначное соответствие классов и признаков).

Очевидно,

эти ограничения приводят и к соответствующим ограничениям, накладываемым в свою

очередь на варианты обработки информации и анализа данных в подобных системах.

Если

говорить конкретнее, такая модель данных стирает различие между атрибутами и

классами и не позволяет решать ряд задач, в которых эта абстракция является

недопустимым упрощением. Эти задачи

будут подробнее рассмотрены ниже.

Семантические пространства классов и атрибутов

Наглядно

модель данных целесообразно представить себе в виде двух взаимосвязанных

фазовых (т.е. абстрактных) пространств, в первом из которых осями координат

служат шкалы атрибутов (пространство атрибутов), а во втором – шкалы классов

(пространство классов).

В

пространстве атрибутов векторами являются объекты обучающей выборки и

обобщенные образы классов. Вектор класса представляет собой массив координат в

фазовом пространстве, каждый элемент массива, т.е. координата, соответствует

определенному атрибуту, а значение этой

координаты – весовому коэффициенту, отражающему количество информации, содержащееся в факте наблюдения данного

атрибута у объекта о принадлежности этого объекта к данному классу.

В

пространстве классов векторами являются атрибуты. Вектор атрибута представляет

собой массив координат в фазовом пространстве, каждый элемент массива, т.е.

координата, соответствует определенному классу, а значение этой координаты – весовому

коэффициенту, отражающему количество информации, содержащееся в факте

наблюдения объекта данного класса о том, что у этого объекта будет определенный

атрибут.

Таким

образом, выбор смысла и математической формы значений весовых коэффициентов в

виде количества информации вводит метрику в этих фазовых пространствах. Поэтому данные пространства являются

нелинейными самосогласованными пространствами. Ясно, что линейная

разделяющая функция в нелинейном пространстве является нелинейной функцией в

линейном пространстве. Самосогласованность семантических пространств означает,

что любое изменение одной координаты в общем случае связано с изменением всех

остальных. Нелинейность и самосогласованность самым существенным образом отличает предложенные семантические

информационные пространства классов и атрибутов от линейного семантического

пространства, используемого в основном в психодиагностике [38], в котором осями

являются признаки (шкалы), а значениями

координат по осям являются непосредственно градации признаков.

Однако

этого недостаточно. Чтобы над векторами в фазовых пространствах можно было

корректно выполнять стандартные операции сложения, вычитания, скалярного и

векторного умножения, выполнять преобразования системы координат, переход от

одной системы координат к другой, и вообще применять аппарат линейной алгебры и

аналитической геометрии, что представляет большой научный и практический

интерес и является очень актуальным, необходимо корректно ввести в этих

пространствах системы координат т.е. системы отсчета, удовлетворяющие определенным

требованиям.

Требования к системам координат, свойства

векторов классов и атрибутов, решение проблемы снижения размерности описания и

ортонормирования

В

качестве осей координат пространства атрибутов целесообразно выбрать вектора

атрибутов, обладающие следующими свойствами:

1.

Их должно быть минимальное количество, достаточное для полного описания

предметной области.

2.

Эти вектора должны пересекаться в одной точке.

3.

Значения координат вектора должны измеряться в одной единице измерения, т.е.

должны быть сопоставимы.

Для

выполнения первого требования необходимо, чтобы математическая форма и смысл

весовых коэффициентов были выбраны таким образом, чтобы модули векторов

атрибутов в пространстве классов были пропорциональны их значимости для решения

задач идентификации, прогнозирования и управления. Причем наиболее значимые

вектора атрибутов не должны коррелировать друг с другом, т.е. должны быть

ортонормированны. В этом случае при удалении векторов с минимальными модулями

автоматически останутся наиболее значимые практически ортонормированные вектора,

которые можно принять за базисные, т.е. в качестве осей системы координат.

Второе

требование означает, что минимальное расстояние между этими векторами в

пространстве классов должно быть равно нулю.

Третье

требование предполагает соответствующий выбор математической формы для значений

координат.

Эти

идеальные требования практически никогда не будут соблюдаться на практике с

абсолютной точностью. Однако этого и не требуется. Достаточно, чтобы реально

выбранные в качестве базисных атрибуты отображались в пространстве классов векторами,

для которых эти требования выполняются с точностью, достаточной для применения

соответствующих математических моделей и математического аппарата на практике.

Аналогично

обстоит дело и с минимизацией размерности пространства классов. В качестве

базисных могут выбраны вектора классов, имеющие максимальную длину и взаимно

(попарно) ортонормированные.

Очевидно,

задача выбора базисных векторов имеет не единственное решение, т.е. может

существовать несколько систем таких векторов, которые можно рассматривать как

результат действия преобразований системы координат, состоящих из смещений и

поворотов.

1.2.2.3.2. Применение классической теории информации

К.Шеннона для расчета весовых коэффициентов и мер сходства

Формально,

распознавание есть не что иное,

как принятие решения о принадлежности распознаваемого объекта или его

состояния к определенному классу (классам) [12, 125, 221]. Из этого следует

внутренняя и органичная связь методов распознавания образов и принятия решений.

Аналитический обзор позволяет сделать вывод, что наиболее глубокая основа этой

связи состоит в том, что и распознавание образов, и принятие решений есть

прежде всего снятие неопределенности. Распознавание снимает

неопределенность в вопросе о том, к какому классу относится распознаваемый

объект. Если до распознавания существовала неопределенность в вопросе о том, к

какому классу относится распознаваемый объект или его состояние, то в

результате распознавания эта неопределенность уменьшается, причем возможно и до

нуля (когда объект идентифицируется однозначно). Принятие решения (выбор) также

снимает неопределенность в вопросе о том, какое из возможных решений будет

принято, если существовало несколько альтернативных вариантов решений и

принимается одно из них.

Для

строгого исследования процессов снятия неопределенности оптимальным является

применение аппарата теории информации, которая как бы специально создана для

этой цели. Из этого непосредственно следует возможность применения методов

теории информации для решения задач распознавания и принятия решений в АСУ.

Таким образом, теория информации может рассматриваться как единая основа

методов распознавания образов и принятия решений.

Формальная постановка задачи

В

рефлексивных АСУ активными объектами модели распознавания образов и принятия

решений применимы в подсистемах идентификации состояния АОУ и выработки

управляющего воздействия: идентификация состояния АОУ представляет собой

принятие решения о принадлежности этого состояния к определенной

классификационной категории (задача распознавания); выбор многофакторного

управляющего воздействия из множества возможных вариантов представляет собой

принятие решения (обратная задача распознавания).

Распознавание

образов есть принятие решения о принадлежности объекта или его состояния к

определенному классу. Если до распознавания существовала неопределенность в

вопросе о том, к какому классу относится распознаваемый объект или его

состояние, то в результате распознавания эта неопределенность уменьшается, в

том числе может быть и до нуля (когда объект идентифицируется однозначно). Из

данной постановки непосредственно следует возможность применения методов

теории информации для решения задач распознавания образов и принятия решений в

АСУ.

Информация как мера снятия неопределенности

Как было показано выше, теория информация

применима в АСУ для решения задач идентификации состояния сложного объекта

управления (задача распознавания) и принятия решения о выборе многофакторного

управляющего воздействия (обратная задача распознавания).

Так

в результате процесса познания уменьшается неопределенность в наших знаниях о

состоянии объекта познания, а в результате процесса труда (по сути управления)

– уменьшается неопределенность поведения продукта труда (или объекта

управления). В любом случае количество переданной информации представляет собой

количественную меру степени снятия неопределенности.

Процесс получения информации можно

интерпретировать как изменение неопределенности в вопросе о том, от какого источника

отправлено сообщение в результате приема сигнала по каналу связи. Подробно

данная модель приведена в работе [81].

Количество информации в индивидуальных

событиях и лемма Неймана–Пирсона

В классическом анализе Шеннона идет речь лишь

о передаче символов по одному информационному каналу от одного источника к

одному приемнику. Его интересует прежде всего передача самого сообщения.

В данном исследовании ставится другая задача:

идентифицировать информационный источник по сообщению от него. Поэтому

метод Шеннона был обобщен путем учета в математической модели возможности

существования многих источников информации, о которых к приемнику по

зашумленному каналу связи приходят не отдельные символы–признаки, а сообщения,

состоящие из последовательностей символов (признаков) любой длины.

Следовательно, ставится задача идентификации

информационного источника по сообщению от него, полученному приемником по

зашумленному каналу. Метод, являющийся обобщением метода К.Шеннона, позволяет

применить классическую теорию информации для построения моделей систем

распознавания образов и принятия решений, ориентированных на применение для

синтеза адаптивных АСУ сложными объектами.

Для

решения поставленной задачи необходимо вычислять не средние информационные

характеристики, как в теории Шеннона, а количество информации, содержащееся в

конкретном i–м признаке (символе) о том, что он пришел от данного j–го источника

информации. Это позволит определить и суммарное количество информации в

сообщении о каждом информационном источнике, что дает интегральный критерий для

идентификации или прогнозирования состояния АОУ.

Логично предположить, что среднее количество

информации, содержащейся в системе признаков о системе классов

|

|

является ничем иным, как усреднением (с

учетом условной вероятности наблюдения) "индивидуальных количеств

информации", которые содержатся в конкретных признаках о конкретных классах

(источниках), т.е.:

|

|

Это выражение определяет так называемую

"плотность информации", т.е. количество информации, которое

содержится в одном отдельно взятом факте наблюдения i–го символа (признака) на

приемнике о том, что этот символ (признак) послан j–м источником.

Если в сообщении содержится M символов, то

суммарное количество информации о принадлежности данного сообщения j–му

информационному источнику (классу) составляет:

|

|

Необходимо отметить, что применение сложения

в выражении (3.43) является вполне корректным и оправданным, так как информация

с самого начала вводилась как аддитивная величина, для которой операция

сложения является корректной.

Преобразуем выражение (3.50) к виду, более

удобному для практического применения (численных расчетов). Для этого выразим

вероятности встреч признаков через частоты их наблюдения:

|

|

Подставив (3.44) в (3.25), получим:

|

|

Если ранжировать классы в порядке убывания

суммарного количества информации о принадлежности к ним, содержащейся в данном

сообщении (т.е. описании объекта), и выбирать первый из них, т.е. тот, о

котором в сообщении содержится наибольшее количество информации, то мы получим

обоснованную статистическую процедуру, основанную на классической теории информации,

оптимальность которой доказывается в фундаментальной лемме Неймана–Пирсона [194].

Сравнивая выражения (3.34) и (3.28) видим,

что в системное обобщенное формулы Харкевича входит слагаемое, сходное с выражением Шеннона для плотности

информации. Различия

состоят в том, что в выражении (3.28) это слагаемое возведено в степень,

имеющую смысл коэффициента эмерджентности Харкевича. Необходимо отметить, что

значения частот в этих формулах связаны с вероятностями несколько различным образом

(выражения 3.20 и 3.33).

Если

ранжировать классы в порядке убывания суммарного количества информации о

принадлежности к ним, содержащейся в данном сообщении (т.е. описании объекта),

и выбирать первый из них, т.е. тот, о котором в сообщении содержится наибольшее

количество информации, то мы получим

обоснованную статистическую процедуру, основанную на классической теории информации,

оптимальность которой доказывается в фундаментальной лемме Неймана–Пирсона [194].

Таким

образом, распознавание образов есть принятие решения о принадлежности объекта

или его состояния к определенному классу. Если до распознавания существовала

неопределенность в вопросе о том, к какому классу относится распознаваемый

объект или его состояние, то в результате распознавания эта неопределенность

уменьшается, в том числе может быть и до нуля. Понятие информации может быть

определено следующим образом: "Информация есть количественная мера степени

снятия неопределенности". Количество информации является мерой соответствия

распознаваемого объекта (его состояния) обобщенному образу класса.

Количество

информации имеет ряд вполне определенных свойств. Эти свойства позволяют ввести

понятие "количество информации в индивидуальных событиях", которое

является весьма перспективным для применения в системах распознавания образов и

поддержки принятия решений.

1.2.2.3.3.

Математическая модель метода распознавания образов и принятия решений,

основанного на системной теории информации

Формальная постановка основной задачи

рефлексивной АСУ активными объектами и ее декомпозиция

Рассмотрим

некоторые основные понятия, необходимые для дальнейшего изложения. При этом

будут использованы как литературные данные, так и результаты, полученные в

предыдущих главах данной работы.

Принятие

решения в АСУ – это выбор некоторого наиболее предпочтительного

управляющего воздействия из исходного множества всех возможных управляющих

воздействий, обеспечивающего наиболее эффективное достижение целей управления.

В результате выбора неопределенность исходного множества уменьшается на

величину информации, которая порождается самим актом выбора [81].

Следовательно, теория информации может быть применена как для идентификации

состояний объекта управления, так и для принятия решений об управляющих воздействиях

в АСУ.

Модель

АСУ включает в себя: модель объекта управления, модель управляющей подсистемы,

а также модель внешней среды. Управляющая подсистема реализует следующие

функции: идентификация состояния объекта управления, выработка управляющего

воздействия, реализация управляющего воздействия.

С

позиций теории информации сложный объект управления (АОУ) может рассматриваться

как шумящий (определенным образом) информационный канал, на вход которого

подаются входные параметры ![]() , представляющие собой управляющие воздействия, а также

факторы предыстории и среды, а на выходе фиксируются выходные параметры

, представляющие собой управляющие воздействия, а также

факторы предыстории и среды, а на выходе фиксируются выходные параметры ![]() , связанные как с входными параметрами, так и с целевыми и

иными состояниями объекта управления.

, связанные как с входными параметрами, так и с целевыми и

иными состояниями объекта управления.

Одной

из основных задач АСУ является задача принятия решения о наиболее эффективном

управляющем воздействии. В терминах теории информации эта задача формулируется

следующим образом: зная целевое состояние

объекта управления, на основе его информационной модели определить такие входные

параметры ![]() , которые с учетом предыстории и актуального состояния

объекта управления, а также влияния среды с наибольшей эффективностью переведут

его в целевое состояние, характеризующееся выходными параметрами

, которые с учетом предыстории и актуального состояния

объекта управления, а также влияния среды с наибольшей эффективностью переведут

его в целевое состояние, характеризующееся выходными параметрами ![]() .

.

С

решением этой задачи тесно связана задача декодирования теории информации: "По полученному в условиях помех сообщению

определить, какое сообщение было передано" [221]. Для решения данной

задачи используются коды, корректирующие ошибки, а в более общем случае, - различные методы распознавания образов.

Учитывая

вышесказанное, предлагается рассматривать принятие решения об управляющем

воздействии в АСУ как решение обратной задачи декодирования, которая

формулируется следующим образом: "Какое

сообщение необходимо подать на вход зашумленного канала связи, чтобы на его

выходе получить заранее заданное сообщение". Данная задача решается на

основе математической модели канала связи.

Декомпозиция

основной задачи в ряд частных подзадач

Построение

аналитической модели АОУ затруднено из-за отсутствия или недостатка априорной

информации об объекте управления, а также из-за ограниченности и сложности

используемого математического аппарата. В связи с этим предлагается путь

решения данной проблемы, состоящий в поэтапном решении следующих задач:

1–я задача: разработать абстрактную модель более общего

класса (содержательную информационную);

2–я задача: обучить абстрактную информационную модель

путем учета информации о реальном поведении АОУ, поступающей в процессе

экспериментальной эксплуатации АСУ; на этом этапе адаптируется и

конкретизируется абстрактная модель АОУ, т.е. в ней все более точно отражаются

взаимосвязи между входными параметрами и состояниями АОУ;

3–я задача: на основе конкретной содержательной информационной

модели разработать алгоритмы решения следующих задач АСУ:

3.1.

Расчет влияния факторов на переход АОУ в различные возможные состояния

(обучение, адаптация).

3.2.

Прогнозирование поведения АОУ при конкретном управляющем воздействии и

выработка многофакторного управляющего воздействия (основная задача АСУ).

3.3.

Выявление факторов, вносящих основной вклад в детерминацию состояния АОУ;

контролируемое удаление второстепенных факторов с низкой дифференцирующей

способностью, т.е. снижение размерности модели при заданных ограничениях.

3.4.

Сравнение влияния факторов. Сравнение состояний АОУ.

Сформулируем

предлагаемую абстрактную модель АОУ, опишем способ ее конкретизации и приведем

алгоритмы решения задач адаптивных АСУ АОУ на основе данной модели.

Решение задачи 1: "Синтез семантической информационной

модели активного объекта управления"

Исходные

данные для выявления взаимосвязей между факторами и состояниями объекта

управления предлагается представить в виде корреляционной матрицы – матрицы

абсолютных частот (таблица 15):

В

этой матрице в качестве классов (столбцов) приняты будущие состояния объекта

управления, как целевые, так и нежелательные, а в качестве атрибутов (строк) –

факторы, которые разделены на три основных группы, математически обрабатываемые

единообразно: факторы, характеризующие текущее и прошлые состояния объекта

управления; управляющие факторы системы управления; факторы, характеризующие

прошлые, текущее и прогнозируемые состояния окружающей среды. Отметим, что

форма таблицы 15 является универсальной формой представления и обобщения фактов

– эмпирических

данных в единстве их дискретного и интегрального представления (причины

– следствия, факторы – результирующие состояния, признаки – обобщенные образы

классов, образное – логическое и т.п.).

|

Таблица 15 – МАТРИЦА

АБСОЛЮТНЫХ ЧАСТОТ |

|

|

Управляющие факторы объединяются в группы, внутри каждой

из которых они альтернативны (несовместны), а между которыми - нет (совместны). В этом

случае внутри каждой группы выбирают одно из доступных управляющих воздействий

с максимальным влиянием. Варианты

содержательной информационной модели без учета прошлых состояний объекта

управления и с их учетом, аналогичны, соответственно, простым и составным цепям

Маркова, автоматам без памяти и с памятью.

В качестве количественной меры влияния факторов, предложено

использовать обобщенную формулу А.Харкевича (3.28), полученную на основе

предложенной эмерджентной теории информации. При этом по формуле (3.28)

непосредственно из матрицы абсолютных частот (таблица 15) рассчитывается матрица

информативностей (таблица 16), которая

и представляет собой основу содержательной информационной модели предметной

области.

Весовые коэффициенты таблицы 3.28 непосредственно

определяют, какое количество информации Iij система управления получает

о наступлении события: "активный объект управления перейдет в j–е

состояние", из сообщения: "на активный объект управления действует

i–й фактор".

Принципиально важно, что эти весовые коэффициенты не

определяются экспертами неформализуемым способом, а рассчитываются непосредственно на основе эмпирических данных

и удовлетворяют всем ранее сформулированным требованиям, т.е. являются

сопоставимыми, содержательно интерпретируемыми, отражают понятия

"достижение цели управления" и "мощность множества будущих

состояний объекта управления" и т.д.

|

Таблица 16 – МАТРИЦА

ИНФОРМАТИВНОСТЕЙ |

|

|

В

данной работе показано, что предложенная информационная мера обеспечивает

сопоставимость индивидуальных количеств информации, содержащейся в факторах о

классах, а также сопоставимость интегральных критериев, рассчитанных для одного

объекта и разных классов, для разных объектов и разных классов.

Когда

количество информации Iij>0

– i–й фактор способствует переходу

объекта управления в j–е состояние,

когда Iij<0 –

препятствует этому переходу, когда же Iij=0

– никак не влияет на это. В векторе i–го

фактора (строка матрицы информативностей) отображается, какое количество

информации о переходе объекта управления в каждое из будущих состояний содержится

в том факте, что данный фактор действует. В векторе j–го состояния класса (столбец матрицы информативностей)

отображается, какое количество информации о переходе объекта управления в соответствующее

состояние содержится в каждом из факторов.

Таким образом, матрица информативностей

(таблица 16) является обобщенной таблицей решений, в которой входы (факторы) и

выходы (будущие состояния АОУ) связаны друг с другом не с помощью классических

(Аристотелевских) импликаций, принимающих только значения: "Истина" и

"Ложь", а различными

значениями истинности, выраженными в битах и принимающими значения от

положительного теоретически-максимально-возможного ("Максимальная степень

истинности"), до теоретически неограниченного отрицательного

("Степень ложности").

Фактически

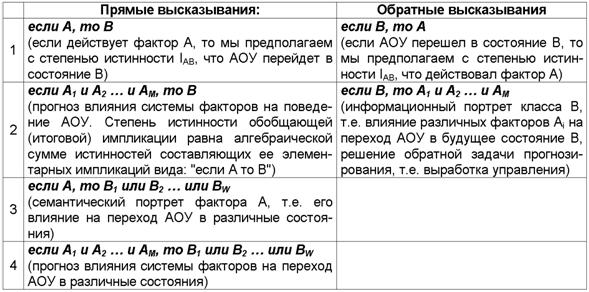

предложенная модель позволяет осуществить синтез

обобщенных таблиц решений для различных предметных областей непосредственно

на основе эмпирических исходных данных и продуцировать

на их основе прямые и обратные правдоподобные (нечеткие) логические рассуждения

по неклассическим схемам с различными

расчетными значениями истинности, являющимся обобщением классических

импликаций (таблица 17).

|

Таблица 17 – ПРЯМЫЕ И ОБРАТНЫЕ ПРАВДОПОДОБНЫЕ

ЛОГИЧЕСКИЕ ВЫСКАЗЫВАНИЯ С РАСЧЕТНОЙ (В СООТВЕТСТВИИ С СТИ) СТЕПЕНЬЮ ИСТИННОСТИ ИМПЛИКАЦИЙ |

|

|

Приведем

пример более сложного высказывания, которое может быть рассчитано

непосредственно на основе матрицы информативностей – обобщенной таблицы решений

(таблица 16):

Если

A, со степенью истинности a(A,B) детерминирует B, и если С, со степенью

истинности a(C,D) детерминирует D, и A совпадает по

смыслу с C со степенью истинности a(A,C), то это вносит вклад в совпадение B с

D, равный степени истинности a(B,D).

При

этом в прямых рассуждениях как предпосылки рассматриваются факторы, а как

заключение – будущие состояния АОУ, а в обратных – наоборот: как предпосылки –

будущие состояния АОУ, а как заключение – факторы. Степень истинности i-й

предпосылки – это просто количество информации Iij, содержащейся в

ней о наступлении j-го будущего состояния АОУ. Если предпосылок несколько, то степень истинности наступления j-го

состояния АОУ равна суммарному количеству информации, содержащемуся в них об

этом. Количество информации в i-м факторе о наступлении j-го состояния АОУ,

рассчитывается в соответствии с выражением (3.28) СТИ.

Прямые

правдоподобные логические рассуждения позволяют прогнозировать степень достоверности наступления события по

действующим факторам, а обратные – по заданному состоянию восстановить степень

необходимости и степень нежелательности каждого фактора для наступления этого

состояния, т.е. принимать решение по выбору управляющих

воздействий на АОУ, оптимальных для перевода его в заданное целевое состояние.

Необходимо

отметить, что предложенная модель, основывающаяся на теории информации,