РАЗДЕЛ 1.3.

ПРИНЦИПЫ ПОСТРОЕНИЯ ИНТЕЛЛЕКТУАЛЬНЫХ

ИНФОРМАЦИОННЫХ СИСТЕМ

1.3.1. ЛЕКЦИЯ-7.

Системы с интеллектуальной

обратной связью и интеллектуальными интерфейсами

Учебные вопросы

1. Интеллектуальные интерфейсы. Использование биометрической информации о пользователе в управлении системами.

2. Системы с биологической обратной связью.

3. Системы с семантическим резонансом. Компьютерные (Y-технологии и интеллектуальный подсознательный интерфейс.

4. Системы виртуальной реальности и критерии реальности. Эффекты присутствия, деперсонализации и модификация сознания пользователя.

5. Системы с дистанционным телекинетическим интерфейсом.

1.3.1.1. Интеллектуальные интерфейсы. Использование биометрической информации о пользователе в управлении системами

1.3.1.1.1. Идентификация и аутентификация личности по почерку. Понятие клавиатурного почерка

Рассмотрим, в чем заключается различие между двумя формами представления одного и того же текста: рукописной и печатной. При этом могут исследоваться и сравниваться как сам процесс формирования текста, так и его результаты, т.е. уже сформированные тексты.

При исследовании уже сформированных текстов обнаруживается, что главное отличие рукописного текста от печатного состоит в значительно большей степени вариабельности начертаний одной и той же буквы разными людьми и одним и тем же человеком в различных состояниях, чем при воспроизведении тех же букв на различных пишущих машинках и принтерах.

Почерком будем называть систему индивидуальных особенностей начертания и

динамики воспроизведения букв, слов и предложений вручную различными

людьми или на различных устройствах печати.

В рукописной форме начертание букв является индивидуальным для каждого человека и зависит также от его состояния, хотя, конечно, в начертаниях каждой конкретной буквы всеми людьми безусловно есть и нечто общее, что и позволяет идентифицировать ее именно как данную букву при чтении.

К индивидуальным особенностям рукописного начертания букв в работе [125] отнесено 13 шкал с десятками градаций в каждой.

В печатной форме вариабельность начертания букв значительно меньше, чем в рукописной, но все же присутствует, особенно на печатных машинках, барабанных, знакосинтезирующих и литерных принтерах.

В СССР печатные машинки при продаже регистрировались и образец печати всех символов вместе с паспортными данными покупателя направлялся в "комптентные" органы. Это позволяло установить на какой машинке и кем напечатан тот или иной материал. Считается, что принтер тем лучше, чем меньше у него индивидуальных особенностей, т.е. чем ближе реально распечатываемые им тексты к некоторому идеалу – стандарту. Современные лазерные и струйные принтеры в исправном состоянии (новый барабан и картридж) практически не имеют индивидуальных особенностей.

На современных компьютерах основным устройством ввода текстовой информации является клавиатура. Результат ввода текста в компьютер с точки зрения начертания букв, слов и предложений не имеет особых индивидуальных особенностей (если не считать частот использования различных шрифтов, кеглей, жирностей, подчеркиваний и других эффектов, изменяющих вид текста). Поэтому необходимо ввести понятие клавиатурного почерка, под которым будем понимать систему индивидуальных особенностей начертаний и динамики воспроизведения букв, слов и предложений на клавиатуре.

1.3.1.1.2. Соотношение психографологии и атрибуции текстов

Таким образом, любой текст содержит не только ту информацию, для передачи которой его собственно и создавали, но и информацию о самом авторе этого текста и о технических средствах и технологии его создания.

Существует целая наука – "Психографология", которая ставит своей задачей получение максимального количества информации об авторах текстов на основе изучения индивидуальных особенностей их почерка [125].

В настоящее время в России действует институт графологии. На сайте этого института http://graphology.boom.ru можно познакомится с тем, что такое графология, с ее историей и задачами, которые она позволяет решать сегодня. Графологическое исследование имеет значительное преимущество перед простым тестированием или собеседованием, поскольку нет необходимости информировать человека, чей почерк подвергается изучению о производимых исследованиях.

Но текст представляет собой не просто совокупность букв, а сложную иерархическую структуру, в которой буквы образуют лишь фундамент пирамиды, а на более высоких ее уровнях находятся слова, предложения, и другие части текстов различных размеров, обладающие относительной целостностью и самостоятельностью (абзацы, параграфы, главы, части, книги).

Понятие почерка акцентирует внимание именно на начертании и динамике воспроизведения букв и слов. При этом в понятие почерка не входят индивидуальные особенности текстов, обнаруживаемые на более высоких уровнях иерархической организации текстов, например: частоты употребления тех или иных слов и словосочетаний, средние длины предложений и абзацев, и т.п. Но именно эти индивидуальные особенности текстов исследуются и используются при атрибуции анонимных и псевдонимных текстов (определении их вероятного авторства) и датировки.

Соответственно и текст может представлять для читателя интерес по крайней мере с трех точек зрения:

1. Как источник информации о том, о чем говорит автор, т.е. о предмете изложения.

2. Как источник информации о самом авторе.

3. Как источник информации о предмете изложения и об авторе.

В этом смысле читать Пушкина в рукописи может быть значительно интереснее, чем в взяв томик с полки. Это объясняется просто: в томике есть лишь сам результат работы поэта и выхолощена вся информация о процессе, т.е. о самом поэте, содержащаяся в почерке, способе размещения текста на листе, порядке и динамике его формирования, различных вариантах и ассоциациях, возникавших в процессе создания произведения.

Таким

образом, система, оснащенная интеллектуальным интерфейсом, может вести по-разному

в зависимости от результатов идентификации пользователя, его профессионального

уровня и текущего психофизиологического состояния.

1.3.1.1.3. Идентификация и аутентификация личности пользователя компьютера по клавиатурному почерку

Рассмотрим подробнее некоторые вопросы идентификации пользователей по клавиатурному почерку. При этом мы будем самым существенным образом основываться на работе: Завгородний В.В. и Мельников Ю.Н. Идентификация по клавиатурному почерку, "Банковские Технологии" №9, 1998 [37].

Проблемы идентификации и аутентификации пользователей компьютеров являются актуальными в связи с все большим распространением компьютерных преступлений. Использование для идентификации клавиатурного почерка является одним из направлений биометрических методов идентификации личности.

Подобные системы не обеспечивают такую же точность распознавания, как системы идентификации по отпечаткам пальцев или по рисунку радужной оболочки глаз, но имеют то преимущество, что система может быть полностью скрыта от пользователя, т. е. он может даже не подозревать о наличии такой системы контроля доступа.

Варианты постановки задачи распознавания клавиатурного почерка

Аутентификация – это проверка, действительно ли пользователь является тем, за кого себя выдает. При этом пользователь должен предварительно сообщить о себе идентификационную информацию: свое имя и пароль, соответствующий названному имени.

Идентификация – это установление его личности.

И идентификация, и аутентификация являются типичными задачами распознавания образов, которое может проводиться по заранее определенной или произвольной последовательности нажатий клавиш.

Характеристики клавиатурного почерка

При вводе информации пользователь последовательно нажимает и отпускает клавиши, соответствующие вводимому тексту. При этом для каждой нажимаемой клавиши можно фиксировать моменты нажатия и отпускания.

На IBM-совместимых персональных компьютерах на следующую клавишу можно нажимать до отпускания предыдущих, т.е. символ помещается в буфер клавиатуры только по нажатию клавиши, тогда как аппаратные прерывания от клавиатуры возникают и при нажатии, и при отпускании клавиши.

Основной характеристикой клавиатурного почерка следует считать временные интервалы между различными моментами ввода текста:

– между нажатиями клавиш;

– между отпусканиями клавиш;

– между нажатием и отпусканием одной клавиши;

– между отпусканием предыдущей и нажатием следующей клавиши.

Кроме того, могут учитываться производные от временных интервалов вторичные показатели, например такие как скорость и ускорение ввода.

Математические методы распознавания клавиатурного почерка

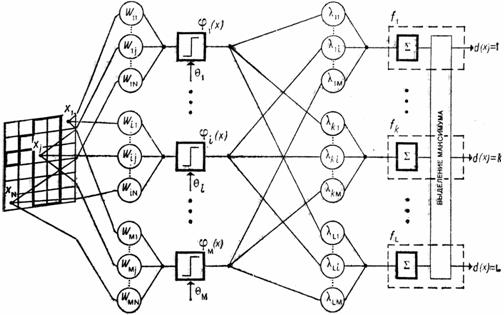

В литературе описано четыре математических подхода к решению задачи распознавания клавиатурного почерка пользователя ЭВМ:

– статистический;

– вероятностно-статистический;

– на базе теории распознавания образов и нечеткой логики;

– на основе нейросетевых алгоритмов.

За более подробным анализом подходов к использованию компьютерного почерка для идентификации и аутентификации пользователей компьютеров отсылаем к в вышеназванной статье.

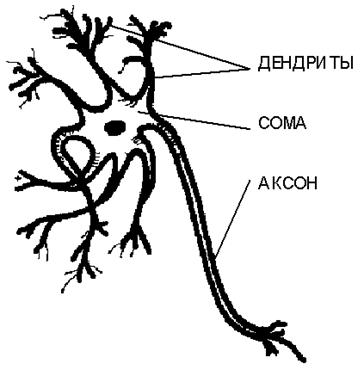

1.3.1.1.4. Прогнозирование ошибок оператора по изменениям в его электроэнцефалограмме

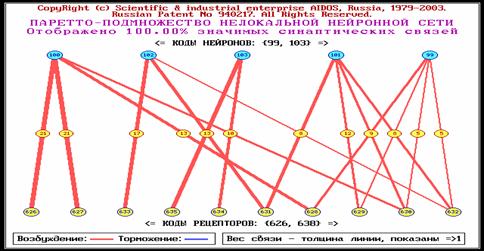

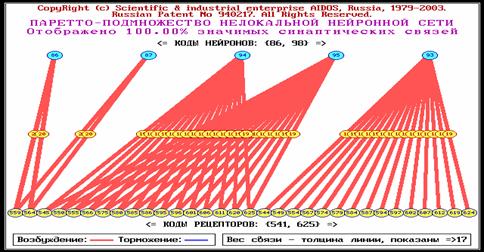

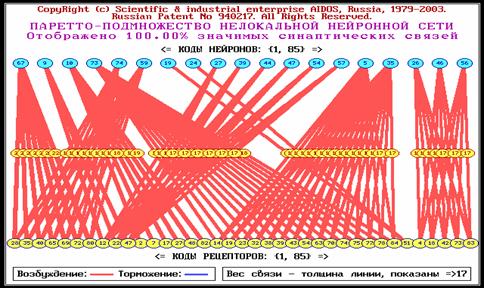

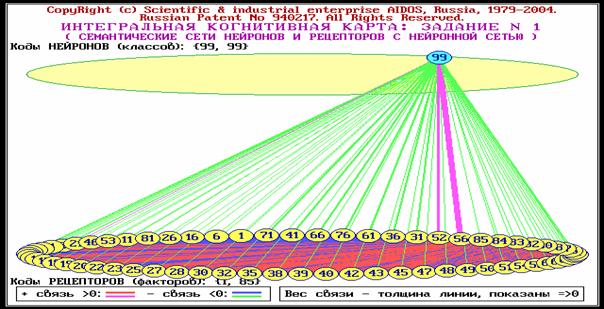

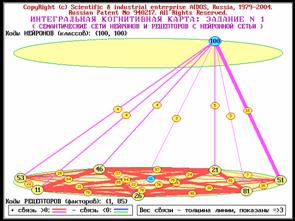

В настоящее время в Институтом психологии РАН, Институтом Высшей Нервной Деятельности и Нейрофизиологии РАН, Высшей Школой Экономики и Кубанским государственном аграрным университетом (Щукин Т.Н., Дорохов В. Б., Лебедев А.Н., Луценко Е.В.) проводятся исследования, продемонстрировавшие принципиальную возможность прогнозирования ошибок оператора при работе с клавиатурой, типа "ошибочное нажатие клавиши", "ошибочное ненажатие клавиши" и т.п. по изменениям в его электроэнцефалограмме (ЭЭГ). При этом для обработки информации успешно была применена система "Эйдос" [108, 224, 225, 226].

Эти работы в перспективе позволяют создать интеллектуальные высоконадежные интерфейсы, обеспечивающие решение этих и ряда других задач идентификации и прогнозирования состояния оператора в режиме реального времени непосредственно в процессе его работы с системой. При этом система в своей работе будет гибко учитывать текущее и прогнозируемое состояние оператора, что может проявляться в адаптации как алгоритмов работы, так и вида и содержания интерфейса.

Эти работы дополняют возможности заблаговременного отбора операторов, обладающих свойствами, необходимыми для высоко ответственных работ в экстремальных ситуациях [64, 67, 74, 77, 78, 85 – 88, 92, 104, 107, 111, 169].

1.3.1.2. Системы с биологической обратной связью

1.3.1.2.1. Общие положения

Системами с биологической обратной связью

(БОС) будем называть системы,

поведение которых зависит от психофизиологического (биологического) состояния

пользователя.

Это означает, что в состав систем с БОС в качестве подсистем входят информационно-измерительные системы и системы искусственного интеллекта.

Съем информации о состоянии пользователя осуществляется с помощью контактных и/или дистанционных датчиков в режиме реального времени с применением транспьютерных или обычных карт (плат) с аналого-цифровыми преобразователями (АЦП).

При этом информация может сниматься по большому количеству каналов – показателей (количество которых обычно кратно степеням двойки), подавляющее большинство которых обычно являются несознаваемыми для пользователя. Это является весьма существенным обстоятельством, т.к. означает, что системы БОС позволяют вывести на уровень сознания обычно ранее не осознаваемую информацию о состоянии своего организма, т.е. расширить область осознаваемого. А это значит, что у человека появляются условия, обеспечивающие возможность сознательного управления своими состояниями, ранее не управляемыми на сознательном уровне, что является важным эволюционным достижением технократической цивилизации.

Передача информации от блока съема информации к АЦП-карте может также осуществляться либо по проводной связи, либо дистанционно с использованием каналов инфракрасной или радиосвязи.

Приведем три примера применения подобных систем:

1. Мониторинг состояния сотрудников на конвейере с целью обеспечения высокого качества продукции.

2. Компьютерные тренажеры, основанные на БОС, для обучения больных с функциональными нарушениями управлению своим состоянием.

3. Компьютерные игры с БОС.

1.3.1.2.1. Мониторинг состояния сотрудников сборочного конвейера с целью обеспечения высокого качества продукции

Известно, что одной из основных причин производственного брака является ухудшение состояния сотрудников. Но сотрудники не всегда могут вовремя заметить это ухудшение, т.к. самооценка (самочувствие) обычно запаздывает по времени за моментом объективного ухудшения состояния. Поэтому является актуальным своевременное обнаружение объективного ухудшения параметров и адекватное реагирование на него.

С помощью систем БОС это достигается тем, что:

1. Каждому сотруднику одевается на руку браслет с компактным устройством диагностики ряда параметров, например таких, как:

– частота и наполнение пульса;

– кожно-гальваническая реакция;

– температура;

– давление;

– пототделение.

2. Это же устройство и периодически передает значения данных параметров на компьютер по радиоканалу.

3. Параметры от каждого сотрудника накапливаются в базе данных системы мониторинга на сервере, а также анализируются в режиме реального времени с учетом текущего состояния и динамики, в т.ч. вторичных (расчетных) показателей.

4. Когда параметры выходят за пределы коридора "нормы" или по их совокупности может быть поставлен диагноз, – сотрудник оперативно снимается с рабочего места и заменяется другим из резерва, а затем, при наличии показаний, направляется на лечение.

1.3.1.2.2. Компьютерные тренажеры, основанные на БОС, для обучения больных навыкам управления своим состоянием

Некоторыми процессами в своем организме мы не можем управлять не потому, что у нас нет рычагов управления, а лишь потому, что мы их не знаем, не имеем навыков их использования и не знаем результатов их применения. Но ключевой проблемой, без решения которой невозможно управление, является отсутствие быстрого и надежного, адекватного по содержанию канала обратной связи.

Все эти проблемы снимаются системами БОС:

– на экран компьютера в наглядной и легко интерпретируемой форме в режиме реального времени выводится информация о состоянии какой-либо подсистемы организма, например, об уровне pH (кислотности) в желудке;

– в качестве рычагов управления пациенту предлагается применить метод визуализации тех или иных образов, которые сообщаются врачом;

– когда пациент ярко зрительно представляет заданные образы, то при этом он обнаруживает, что кривая кислотности на экране начинает ползти вверх или вниз в прямом соответствии с тем, что именно он себе представляет.

Через пару недель подобных тренировок, проводимых по 15-20 минут через день пациент приобретает такой уровень навыков управления ранее не осознаваемыми процессами в своем организме, которых Хатха-йоги добиваются за многие годы упорных тренировок под руководством профессиональных опытных и ответственных наставников (Гуру). Причем скоро пациент начинает понимать, когда необходимо повысить или понизить кислотность и без компьютера с системой БОС и может делать это прямо в той обстановке, в которой возникла такая необходимость. Столь высокая эффективность метода БОС объясняется высокой скоростью, наглядностью и адекватностью обратной связи, что является одним из основных факторов, влияющих на эффективность формирования навыков управления своим состоянием.

Имеется информация, что такими методами могут лечиться или облегчаться многие заболевания, вплоть до диабета, причем не только на стадии функциональных нарушений, но даже и при наличии органических изменений.

1.3.1.2.3. Компьютерные игры с БОС

В последнее время появляется все больше компьютерных игр, включающих элементы БОС. При этом от психофизиологического состояния игрока может зависеть, например, и развитие сценария, и точность прицеливания при использовании оптического прицела.

В этих играх часто создаются ситуации, в которых человеку нужно быстро принимать и реализовать решения, при этом цена ошибки, а значит и психическая напряженность, и волнение игрока, постоянно увеличиваются. Этим самым создается экстремальная ситуация, напряженность которой все больше возрастает. В этих условиях лучших результатов достигает тот, у кого "крепче нервы", кто лучше может управлять собой в экстремальных ситуациях.

Поэтому игры с элементами БОС можно считать своего рода тренажерами по формированию и совершенствованию навыков адекватного поведения в экстремальных ситуациях.

Здесь необходимо отметить один очень существенный момент. В обычной реальности развитие событий зависит не непосредственно от нашего психофизиологического состояния, а лишь от того, как оно проявляется в наших действиях. В случае же виртуальной реальности развитие сценария игры может зависеть непосредственно от состояния игрока. Таким образом, в виртуальной реальности само сознательное (произвольное) или несознательное (непроизвольное) изменение нашего состояния по сути дела является действием. Аналогичная ситуация в обычной реальности может иметь место при высших формах сознания и проявлении сверхспособностей.

1.3.1.3. Системы с семантическим резонансом. Компьютерные Y-технологии и интеллектуальный подсознательный интерфейс

Системами с семантическим резонансом будем называть системы, поведение которых

зависит от состояния сознания пользователя и его психологической реакции на

смысловые стимулы.

Это означает, что в состав систем с семантическим резонансом, также как и систем с БОС, в качестве подсистем входят информационно-измерительные системы и системы искусственного интеллекта, аналогично осуществляется и съем информации о состоянии пользователя.

Различие между системами с БОС и с семантическим резонансом состоит в том, что в первом случае набор снимаемых параметров и методы их математической обработки определяются необходимостью идентификации биологического состояния пользователя, тогда как во втором – его реакции на смысловые стимулы (раздражители).

В частности, имеется возможность по наличию в электроэнцефалограмме так называемых вызванных потенциалов [221] установить реакцию человека на стимул: заинтересовался он или нет.

Здесь принципиально важно, что вызванные потенциалы после предъявления стимула по времени возникают гораздо раньше, чем его осознание.

Из этого следует ряд важных выводов:

1. Если

это осознание не наступает по каким-либо причинам, то вызванные потенциалы все

равно с очень высокой достоверностью позволяют прогнозировать ту реакцию,

которая была бы у человека, если бы информация о стимуле проникла в его

сознание (причинами, по которым зрительный образ стимула может не успеть

сформироваться и проникнуть в сознание пользователя, могут быть, например, его

очень сильную зашумленность, фрагментарность или слишком короткое время его

предъявления).

2. Реакция на стимул на уровне вызванных потенциалов не подвергается критическому анализу и корректировке на уровне сознания, т.е. является гораздо более "искренней" и "откровенной", адекватной и достоверной, чем сознательные ответы на опросник с тем же самым стимульным материалом (сознательные ответы зависят от мотивации, коньюктуры и массы других обстоятельств).

3. Для получения информации о подсознательной реакции пользователя на стимульный материал он может предъявляться в значительно более высоком темпе, чем при сознательном тестировании.

4. При подсознательном тестировании пользователь может даже не знать о том, что оно проводится.

Все это в совокупности означает, что системы с семантическим резонансом позволяют получить и вывести на уровень сознания обычно ранее не осознаваемую адекватную информацию о состоянии своего сознания, систем мотивации, целеполагания, ценностей и т.д., т.е. расширить область осознаваемого. Это позволяет создать качественно более благоприятные условия для управления состоянием сознания, чем ранее, что является важным эволюционным достижением технократической цивилизации.

Системы с семантическим резонансом могут эффективно использоваться в ряде направлений:

– психологическое и профессиональное тестирование, подбор персонала, в т.ч. для действий в специальных условиях и в измененных формах сознания;

– модификация сознания, систем мотиваций, целеполагания, ценностей и др. (компьютерное нейролингвистическое программирование: "компьютерные НЛП-технологии");

– компьютерные игры с системами семантической обратной связи.

1.3.1.4. Системы виртуальной реальности и критерии реальности. Эффекты присутствия, деперсонализации и модификация сознания пользователя

1.3.1.4.1. Классическое определение системы виртуальной реальности

ВИРТУАЛЬНАЯ

РЕАЛЬНОСТЬ (ВР) – модельная

трехмерная (3D) окружающая среда, создаваемая компьютерными средствами и

реалистично реагирующая на взаимодействие с пользователями

(http://dlc.miem.edu.ru/newsite.nsf/docs/CSD309).

Технической базой систем виртуальной реальности являются современные мощные персональные компьютеры и программное обеспечение высококачественной трехмерной визуализации и анимации. В качестве устройств ввода-вывода информации в системах ВР применяются виртуальные шлемы с дисплеями (HMD), в частности шлемы со стереоскопическими очками, и устройства 3D-ввода, например, мышь с пространственно управляемым курсором или "цифровые перчатки", которые обеспечивают тактильную обратную связь с пользователем.

Совершенствование систем виртуальной реальности

приводит ко все большей изоляции пользователя от обычной реальности, т.к. все

больше каналов взаимодействия

пользователя с окружающей средой замыкаются не на обычную, а на виртуальную

среду – виртуальную реальность, которая, при этом, становится все более и более

функционально-замкнутой и самодостаточной.

Создание систем ВР является закономерным следствием процесса совершенствования компьютерных систем отображения информации и интерфейса управления.

При обычной работе на компьютере монитор занимает не более 20% поля зрения пользователя. Системы ВР перекрывают все поле зрения.

Обычные мониторы не являются стереоскопическими, т.е. не создают объемного изображения. Правда, в последнее время появились разработки, которые, позволяют преодолеть это ограничение (достаточно сделать поиск в yandex.ru по запросу "Стереоскопический монитор"). Системы ВР изначально были стереоскопическими.

Звуковое сопровождение, в том числе со стерео и квадро-звуком, сегодня уже стали стандартом. В системах ВР человек не слышит ничего, кроме звуков этой виртуальной реальности.

В некоторых моделях систем виртуальной реальности пользователи имеют возможность восприятия изменяющейся перспективы и видят объекты с разных точек наблюдения, как если бы они сами находились и перемещались внутри модели.

Если пользователь располагает более развитыми (погруженными) устройствами ввода, например, такими, как цифровые перчатки и виртуальные шлемы, то модель может даже надлежащим образом реагировать на такие действия пользователя, как поворот головы или движение глаз.

Необходимо отметить, что в настоящее время системы виртуальной реальности развиваются очень быстрыми темпами и явно выражена тенденция проникновения технологий виртуальной реальности в стандартные компьютерные технологии широкого применения.

Развитие этих и других подобных средств привело к появлению качественно новых эффектов, которые ранее не наблюдались или наблюдались в очень малой степени:

– эффект присутствия пользователя в виртуальной реальности;

– эффект деперсонализации и модификации самосознания и сознания пользователя в виртуальной реальности.

1.3.1.4.2. "Эффект присутствия" в виртуальной реальности

Эффект

присутствия – это создаваемая для

пользователя иллюзия его присутствия

в смоделированной компьютером среде, при этом создается полное впечатление

"присутствия" в виртуальной среде, очень сходное с ощущением

присутствия в обычном "реальном" мире.

При этом виртуальная среда начинает осознаваться как реальная, а о реальной среде пользователь на время как бы совершенно или почти полностью "забывает". При этом технические особенности интерфейса также вытесняются из сознания, т.е. мы не замечаем этот интерфейс примерно так же, как собственное физическое тело или глаза, когда смотрим на захватывающий сюжет. Таким образом, реальная среда замещается виртуальной средой.

Исследования показывают, что для возникновения и силы эффекта присутствия определяющую роль играет реалистичность движения различных объектов в виртуальной реальности, а также убедительность реагирования объектов виртуальной реальности при взаимодействии с ними виртуального тела пользователя или других виртуальных объектов. В то же время, как это ни странно, естественность вида объектов виртуальной среды играет сравнительно меньшую роль.

1.3.1.4.3. Применения систем виртуальной реальности

Системы виртуальной реальности уже в настоящее время широко применяется во многих сферах жизни.

Одними из первых технологии виртуальной реальности были применены НАСА США для тренировки пилотов космических челноков и военных самолетов, при отработке приемов посадки, дозаправки в воздухе и т.п.

Самолет-невидика "Стелс" вообще управляется пилотом, практически находящемся в виртуальной реальности.

Из виртуальной реальности человек управляет роботом, выполняющим опасную или тонкую работу.

Технология Motion Capture, позволяет дистанционно "снять" движения с человека и присвоить их его трехмерной модели, что широко применяется для создания компьютерных игр и анимации рисованных персонажей в фильмах.

Особенно эффективно применение виртуальной реальности в рекламе, особенно в Интернет-рекламе на стадии информирования и убеждения.

С использованием виртуальной реальности можно показывать различные помещения, например, совершить виртуальную экскурсию по музею, учебному заведению, дому, коттеджу или местности (прогулка по Парижу от туристической фирмы).

Во всех этих приложениях важно, что в отличие от трехмерной графики, виртуальная реальность обеспечивает эффект присутствия и личного участия пользователя в наблюдаемых им событиях.

1.3.1.4.4. Модификация сознания и самосознания пользователя в виртуальной реальности

Сегодня уже для всех вполне очевидно, что виртуальная реальность может с успехом использоваться для развлечений, ведь она помогает представить себя в другой роли и в другом обличии. Однако в действительности этот эффект связан с модификацией "Образа Я", т.е. сознания и самосознания пользователя. Это значит, что последствия этого в действительности значительно серьезнее, чем обычно представляют, и далеко выходит за рамки собственно развлечений.

Как показано автором в ряде работ, приведенных на сайте http://Lc.kubagro.ru, форма сознания и самосознания человека определяются тем, как он осознает себя и окружающее, т.е. тем:

– что он осознает, как объективное, субъективное и несуществующее;

– с чем он отождествляет себя и что осознает как объекты окружающий среды.

Очевидно, что разработчики новейших компьютерных технологий совершенно неожиданно вторглись в абсолютно новую для себя сферу исследования измененных форм сознания, и далеко идущие системные последствия этого ими, как и вообще научным сообществом, пока еще очень мало осознаны.

Еще в 1079-1981 годах автором и Л.А.Бакурадзе были оформлены заявки на изобретение компьютерной системы, выполняющей все трудовые функции физического тела, обеспечивающую управление с использованием дистанционного мысленного воздействия, т.е. микротелекинеза. По мнению автора телекинез представляет собой управление физическими объектами путем воздействия на них непосредственно с высших планов без использования физического тела, т.е. тем же способом, с помощью которого любой человек, осознает он это или нет, управляет своим физическим телом. Были предложены технические и программные решения и инженерно – психологические методики. Система предлагалась адаптивной, т.е. автоматически настраивающейся на индивидуальные особенности, "почерк" оператора и его состояние сознания, с плавным переключением на дистанционные каналы при повышении их надежности (которая измерялась автоматически) и могла одновременно с выполнением основной работы выступать в качестве тренажера. Человек, начиная работу с системой в обычной форме сознания с использованием традиционных каналов (интерфейса), имея мгновенную адекватную по форме и содержанию обратную связь об эффективности своего телекинетического воздействия, должен быстро переходить в форму сознания, оптимальную для использования телекинеза в качестве управляющего воздействия.

1.3.1.4.5. Авторское определение системы виртуальной реальности

С учетом вышесказанного, предлагается следующее определение виртуальной реальности.

Система виртуальной реальности (ВР) – это система, обеспечивающая:

1. Генерацию полиперцептивной модели реальности в соответствии с математической моделью этой реальности, реализованной в программной системе.

2. Погружение пользователя в модель реальности путем подачи на все или основные его перцептивные каналы – органы восприятия, программно-управляемых по величине и содержанию воздействий: зрительного, слухового, тактильного, термического, вкусового и обонятельного и других.

3. Управление системой путем использования виртуального "образа Я" пользователя и виртуальных органов управления системой (интерфейса), на которые он воздействует, представляющие собой зависящую от пользователя часть модели реальности.

4. Реалистичную реакцию моделируемой реальности на виртуальное воздействие и управление со стороны пользователя.

5. Разрыв отождествления пользователя со своим "Образом Я" из обычной реальности (деперсонализация), и отождествление себя с "виртуальным образом Я", генерируемым системой виртуальной реальности (модификация сознания и самосознания пользователя).

6. Эффект присутствия пользователя в моделируемой реальности в своем "виртуальном образе Я", т.е. эффект личного участия пользователя в наблюдаемых виртуальных событиях.

7. Положительные

результаты применения критериев реальности, т.е. функциональную

замкнутость и самодостаточность виртуальной реальности, вследствие чего никакими действиями внутри виртуальной

реальности, осуществляемыми над ее объектами, в т.ч. объектами виртуального

интерфейса, с помощью своего виртуального тела, невозможно установить,

"истинная" эта реальность или виртуальная.

1.3.1.4.6. Критерии реальности при различных формах сознания и их применение в виртуальной реальности

В этой связи вспоминается ставший уже классическим первый фильм "Матрица", в котором Морфей, обращаясь к Нео, произносит свою знаменитую фразу: "Сейчас я покажу тебе, как выглядит окончательная истинная реальность". Эта фраза сразу вызвала у меня массу ассоциаций и вопросов, в частности:

1. А каковы критерии реальности?

2. А вдруг и эта реальность, которую Морфей назвал окончательной, истинной, в действительности является не более, чем симулятором следующего иерархического уровня, так сказать более фундаментальным симулятором?

Здесь возникает сложный мировоззренческий вопрос о том, возможно ли хотя бы в принципе находясь в виртуальной реальности не выходя за ее пределы установить, что ты находишься именно в виртуальной, а не истинной реальности, или это возможно сделать только задним числом, после выхода из виртуальной реальности и перехода в истинную реальность?

Итак, каковы же критерии реальности?

По нашему мнению, прежде всего это самосогласованность реальности, т.е. получение одной и той же информации качественно различными способами и по различным каналом связи (принцип наблюдаемости):

–

согласованность реальности самой с собой во времени;

– согласованность и взаимное

подтверждение информации от различных органов восприятия, которые обычно

реагируют на различные формы материи и часто являются парными (зрение, слух,

обоняние) и расположенными в различных точках пространства.

Например, мы не только что-то видим, но и

слышим, и осязаем, и можем попробовать его на вкус и ощутить запах и все эти

восприятия ОТ РАЗЛИЧНЫХ ОРГАНОВ ЧУВСТВ соответствуют друг другу и

означают, что перед нами некий определенный объект, а не галлюцинация или

визуализация. Согласованная и взаимно подтверждающая информация с различных

органов чувств, в соответствии с принципом наблюдаемости, также может рассматриваться

как повышающая достоверность и адекватность восприятия.

В современных компьютерных играх мы не

только видим довольно качественную визуализацию, но и соответствующее

реалистичное звуковое сопровождение. А в системах виртуальной реальности –

визуализация стереоскопическая (то, что мы видим РАЗНЫМИ глазами как бы с

разных точек в ПРОСТРАНСТВЕ также взаимно подтверждается), а также появляется

тактильный канал с обратной связью, который позволяет ощутить даже твердость,

вес и температуру моделируемого в виртуальной реальности объекта. Все это

вместе уже создает на столько высокую степень реалистичности, что может

возникнуть эффект присутствия в виртуальной реальности, деперсонализация и

отождествление с измененным образом Я, моделируемым в виртуальной реальности

(переход в измененную форму сознания).

Представим, что эти сформулированные критерии реальности не выполняются, т.е. нарушается ее самосогласованность. Как и в чем это может проявляться?

По-видимому, как своего рода "сбои" и различные "нарушения физических законов" и несогласованности в виртуальной реальности:

– "зацикливание" событий, как на заезженной пластинке, т.е. их многократное повторное осуществление без каких-либо изменений (пример: повторный проход черной кошки, с характерной остановкой и поворотом головы, в дверном проеме в "Матрице");

– прохождение сквозь стены;

– полеты и очень длинные прыжки, а также телепортация в своем "реальном" теле;

– действия в другом темпе времени, т.е. эффект замедления внешнего времени, соответствующий аналогичному ускорению внутреннего времени;

– действия в другом масштабе пространства, "увеличение" и "уменьшение" размеров, наблюдение мега и микроструктуры материи;

– видение сквозь стены, видение на больших расстояниях (в т.ч. с увеличением "как в телескоп"), видение прошлого и будущего;

– телекинез, пирокинез, психосинтез, левитация и т.п.;

– одновременное нахождение в нескольких местах.

Нетрудно заметить, что все эти проявления весьма напоминают так называемые "паранормальные явления", которые традиционно связывают с сверхвозможностями человека, т.е. с его возможностями при высших формах сознания.

Эти явления хотя и редко, но все же наблюдаются в нашем мире, что может указывать на то, что наша "истинная реальность" в определенной мере возможно является виртуальной, по крайней мере в большей степени, чем ранее предполагалось.

1.3.1.4.7. Принципы эквивалентности (относительности) Галилея и Эйнштейна и критерии виртуальной реальности

Вспомним известные в физике принципы относительности Галилея и Эйнштейна:

1. Никакими экспериментами внутри замкнутой системы невозможно отличить состояние покоя от состояния равномерного и прямолинейного движения (Галилей). Следовательно, покоящаяся система отсчета физически эквивалентна системе отсчета, движущейся равномерно и прямолинейно под действием сил инерции.

2. Никакими экспериментами внутри ограниченной по размерам замкнутой системы невозможно установить, движется она под действием сил гравитации или по инерции (Эйнштейн). Следовательно, система отсчета, движущаяся в поле сил тяготения физически эквивалентна системе отсчета, движущейся под действием сил инерции.

Легко заметить, что формулировка 7-го пункта в определении системы виртуальной реальности весьма сходна с формулировками принципов относительности Галилея и Эйнштейна: никакими действиями внутри виртуальной реальности, осуществляемыми над ее объектами, в т.ч. объектами виртуального интерфейса, с помощью своего виртуального тела, невозможно установить, "истинная" эта реальность или виртуальная.

Следовательно, виртуальная система отсчета, локализованная в полнофункциональной виртуальной реальности полностью физически эквивалентна физической системе отсчета, локализованной в "истинной реальности". Учитывая эту аналогию, принцип, предложенный автором, назовем принципом относительности или принципом эквивалентности виртуальной и истинной реальности.

1.3.1.5. Системы с дистанционным телекинетическим интерфейсом

В 1981 году Л.А.Бакурадзе и Е.В.Луценко были оформлены заявки на изобретение компьютерной системы, выполняющей все трудовые функции физического тела, обеспечивающую управление с использованием дистанционного мысленного воздействия, т.е. микротелекинеза.

По мнению автора телекинез представляет собой управление физическими объектами путем воздействия на них непосредственно с высших планов без использования физического тела, т.е. тем же способом, с помощью которого любой человек, осознает он это или нет, управляет своим физическим телом.

Были предложены технические и программные решения и инженерно – психологические методики. Система предлагалась адаптивной, т.е. автоматически настраивающейся на индивидуальные особенности, "почерк" оператора и его состояние сознания, с плавным переключением на дистанционные каналы при повышении их надежности (которая измерялась автоматически) и могла одновременно с выполнением основной работы выступать в качестве тренажера для овладения высшими формами сознания.

Человек, начиная работу с системой в обычной форме сознания с использованием традиционных каналов (интерфейса), имея мгновенную адекватную по форме и содержанию обратную связь об эффективности своего телекинетического воздействия, должен быстро переходить в одну из высших форм сознания, оптимальную для использования телекинеза в качестве управляющего воздействия.

Контрольные вопросы

1. Интеллектуальные интерфейсы. Использование биометрической информации о пользователе в управлении системами.

2. Идентификация и аутентификация личности по почерку. Понятие клавиатурного почерка.

3. Соотношение психографологии и атрибуции текстов.

4. Идентификация и аутентификация личности пользователя компьютера по клавиатурному почерку.

5. Прогнозирование ошибок оператора по изменениям в его электроэнцефалограмме.

6. Системы с биологической обратной связью (БОС).

7. Мониторинг состояния сотрудников сборочного конвейера с целью обеспечения высокого качества продукции.

8. Компьютерные тренажеры, основанные на БОС, для обучения больных навыкам управления своим состоянием.

9. Компьютерные игры с БОС.

10. Системы с семантическим резонансом. Компьютерные (Y-технологии и интеллектуальный подсознательный интерфейс.

11. Системы виртуальной реальности и критерии реальности. Эффекты присутствия, деперсонализации и модификация сознания пользователя.

12. Классическое определение системы виртуальной реальности.

13. "Эффект присутствия" в виртуальной реальности.

14. Применения систем виртуальной реальности.

15. Модификация сознания и самосознания пользователя в виртуальной реальности.

16. Авторское определение системы виртуальной реальности.

17. Критерии реальности при различных формах сознания и их применение в виртуальной реальности.

18. Принципы эквивалентности (относительности) Галилея и Эйнштейна и критерии виртуальной реальности.

19. Системы с дистанционным телекинетическим интерфейсом.

Рекомендуемая литература

1. Завгородний В.В., Мельников Ю.Н., Идентификация по клавиатурному почерку. "Банковские Технологии", №9, 1998.

2. Иванов А.И. Биометрическая идентификация личности по динамике подсознательных движений. Пенза. Издательство Пензенского государственного университета –2000, –188 с.

3. Луценко Е.В., Лаптев В.Н., Третьяк В.Г. Прогнозирование качества специальной деятельности методом подсознательного (подпорогового) тестирования на основе семантического резонанса. //В сб.: "Материалы II межвузовской научно-технической конференции". – Краснодар: КВИ, 2001. – С.127-128.

4. Луценко Е.В., Лебедев А.Н. Диагностика и прогнозирование профессиональных и творческих способностей методом АСК-анализа электроэнцефалограмм в системе "Эйдос". // Межвузовский сборник научных трудов, том 1. –Краснодар: КВИ. 2003.–С. 227-229.

5. Щукин Т.Н., Дорохов В. Б., Лебедев А.Н., Луценко Е.В. ЭЭГ прогноз успешности выполнения психомоторного теста при снижении уровня бодрствования: постановка задачи. // Научный журнал КубГАУ. – 2004.– №4(6). – 9 с. http://ej.kubagro.ru.

6. Щукин Т.Н., Дорохов В. Б., Лебедев А.Н., Луценко Е.В. ЭЭГ прогноз успешности выполнения психомоторного теста при снижении уровня бодрствования: описание эксперимента. // Научный журнал КубГАУ. – 2004.– №4(6). – 13 с. http://ej.kubagro.ru.

7. Щукин Т.Н., Дорохов В. Б., Лебедев А.Н., Луценко Е.В. ЭЭГ прогноз успешности выполнения психомоторного теста при снижении уровня бодрствования: анализ результатов исследования. // Научный журнал КубГАУ. – 2004.– №4(6). – 17 с. http://ej.kubagro.ru.

8. Смирнов И., Безносюк Е., Журавлёв А. Психотехнологии: Компьютерный психосемантический анализ и психокоррекция на неосознаваемом уровне. - М.: Изд. группа Прогресс-Культура, 1995. - 416с.

9. Шагас Ч. Вызванные потенциалы мозга в норме и патологии. –М.: Мир, 1975. –314 с.

10. Сайт Луценко Е.В. http://Lc.kubagro.ru.

1.3.2. ЛЕКЦИЯ-8.

Автоматизированные системы

распознавания образов

Учебные вопросы

1. Основные понятия и определения, связанные с системами распознавания образов.

2. Проблема распознавания образов.

3. Классификация методов распознавания образов.

4. Применение распознавания образов для идентификации и прогнозирования. Сходство и различие в содержании понятий "идентификация" и "прогнозирование".

5. Роль и место распознавания образов в автоматизации управления сложными системами.

6. Методы кластерного анализа.

1.3.2.1. Основные понятия

Системой распознавания образов будем называть класс систем искусственного интеллекта, обеспечивающих:

– формирование конкретных образов объектов и обобщенных образов классов;

– обучение, т.е. формирование обобщенных образов классов на основе ряда примеров объектов, классифицированных (т.е. отнесенных к тем или иным категориям – классам) учителем и составляющих обучающую выборку;

– самообучение, т.е. формирование кластеров объектов на основе анализа неклассифицированной обучающей выборки;

– распознавание, т.е. идентификацию (и прогнозирование) состояний объектов, описанных признаками, друг с другом и с обобщенными образами классов;

– измерение степени адекватности модели;

– решение обратной задачи идентификации и прогнозирования (обеспечивается не всеми моделями).

1.3.2.1.1. Признаки и образы конкретных объектов, метафора фазового пространства

Признаками объектов будем называть конкретные результаты измерения значений их свойств.

Свойства объектов отличаются своим качеством и измеряются с помощью различных органов восприятия или измерительных приборов в различных единицах измерения.

Результатом измерения является снижение неопределенности в наших знаниях о значении свойств объекта. Значения свойств конкретизируются путем их сопоставления определенным градациям соответствующих измерительных шкал: номинальных, порядковых или отношений.

В номинальных шкалах отсутствуют отношения порядка, начало отсчета и единица измерения.

На порядковых шкалах определены отношения "больше – меньше", но отсутствуют начало отсчета и единица измерения.

На шкалах отношений определены отношения порядка, все арифметические операции, есть начало отсчета и единица измерения.

Можно представить себе, что шкалы образуют оси координат некоторого абстрактного многомерного пространства, которое будем называть "фазовым пространством".

В этом фазовом пространстве каждый конкретный объект представляется определенной точкой, имеющей координаты, соответствующие значениям его свойств по осям координат, т.е. градациям описательных шкал.

Оси координат фазового пространства в общем случае не являются взаимно-перпендикулярными шкалами отношений, т.е. в общем случае это пространство неортонормированное, более того – неметрическое. Следовательно, в нем в общем случае не применима Евклидова мера расстояний, т.е. не действует Евклидова метрика. Применение этой меры расстояний корректно, если одновременно выполняются два условия:

1. Все оси координат фазового пространства являются шкалами отношений.

2. Все оси координат взаимно-перпендикулярны или очень близки к этому.

1.3.2.1.2. Признаки и обобщенные образы классов

Обобщенный образ класса формируется из нескольких образов конкретных объектов, относящихся к данному классу, т.е. одной градации некоторой классификационной шкалы.

Обобщенные образы классов формализуются (кодируются) путем использования классификационных шкал и градаций, которые могут быть тех же типов, что и описательные, т.е. номинальные, порядковые и отношений.

Сама принадлежность конкретных объектов к данному классу определятся либо человеком-учителем, после чего фиксируется в обучающей выборке, либо самой системой автоматически на основе кластерного анализа конкретных объектов.

1.3.2.1.3. Обучающая выборка и ее репрезентативность по отношению к генеральной совокупности. Ремонт (взвешивание) данных

Рассмотрим, как зависит степень достоверности выводов о генеральной совокупности от объема обучающей выборки.

Если обучающая выборка включает все объекты генеральной совокупности, т.е. они совпадают, то достоверность выводов будет наиболее высокой (при всех прочих равных условиях).

Если же обучающая выборка очень мала, то вряд ли на ее основе могут быть сделаны достоверные выводы о генеральной совокупности, т.к. в этом случае в обучающую выборку могут даже не входить примеры объектов всех или подавляющего большинства классов.

Под репрезентативностью обучающей выборки будем понимать ее способность адекватно представлять генеральную совокупность, так что изучение самой генеральной совокупности можно корректно заменить исследованием обучающей выборки.

Но репрезентативность зависит не только от объема, но и от структуры обучающей выборки, т.е. от того, насколько полно представлены все категории объектов генеральной совокупности (классы) и от того, насколько полно они описаны признаками.

Взвешивание

данных или ремонт обучающей выборки – это операция, в результате которой частное распределение объектов по

классам в обучающей выборке максимально, на сколько это возможно, приближается

либо к частотному распределению генеральной совокупности (если оно известно из

независимых источников), либо к равномерному.

В системе "Эйдос" режим взвешивания данных реализован.

1.3.2.1.4. Основные операции: обобщение и распознавание

Сразу необходимо отметить, что операция обобщения реализуется далеко не во всех моделях систем распознавания (например, в методе k-ближайших соседей), а в тех, в которых оно реализуется, – это делается по-разному.

Обычно, пока не реализовано обобщение нет возможности определить ценность признаков для решения задачи идентификации.

Например, если у нас есть 10 конкретных мячей разного размера и цвета, состоящих из разных материалов и предназначенных для разных игр, и мы рассматриваем их как совершенно независимые друг от друга объекты, наряду с другими, то у нас нет возможности определить, какие признаки являются наиболее характерными для мячей и наиболее сильно отличают их от этих других объектов. Но как только мы сформируем обобщенные образы "мяч", "стул", и т.д., сразу выясниться, что цвет мяча и материал, из которого он сделан, не является жестко связанными с обобщенным образом класса "мяч", а наиболее существенно то, что он круглый и его можно бросать или бить во время игры.

Распознавание – это операция сравнения и определения

степени сходства образа данного конкретного объекта с образами других

конкретных объектов или с обобщенными образами классов, в результате которой

формируется рейтинг объектов или классов по убыванию сходства с распознаваемым

объектом.

Ключевым моментом при реализации операции распознавания в математической модели является выбор вида интегрального критерия или меры сходства, который бы на основе знания о признаках конкретного объекта позволил бы количественно определить степень его сходства с другими объектами или обобщенными образами классов.

В ортонормированном пространстве, осями которого являются шкалы отношений, вполне естественным является использовать в качестве такой меры сходства Евклидово расстояние. Однако, такие пространства на практике встречаются скорее как исключение из правила, а операция ортонормирования является довольно трудоемкой в вычислительном отношении и приводит к обеднению модели, а значит ее не всегда удобно и целесообразно осуществлять.

Поэтому актуальной является задача выбора или конструирования интегрального критерия сходства, применение которого было бы корректно и в неортонормированных пространствах. Кроме того, этот интегральный критерий должен быть устойчив к наличию шума, т.е. к неполноте и искажению как в исходных данных, так и самой численной модели.

Требование устойчивости к наличию шума математически означает, что результат применения интегрального критерия к сигналу, состоящему только из белого шума, должен быть равным нулю. Это значит, что в качестве интегрального критерия может быть применена функция, используемая при определении самого понятия "белый шум", т.е. свертка, скалярное произведение, корреляция.

Такой интегральный критерий предложен в математической модели системно-когнитивного анализа и реализован в системе "Эйдос".

1.3.2.1.5. Обучение с учителем (экспертом) и самообучение (кластерный анализ)

Причем, если описательные характеристики могут формироваться с помощью информационно-измерительной системы автоматически, то классификационные – представляют собой результат вообще говоря неформализуемого процесса оценки степени принадлежности данных объектов к различным классам, который осуществляется человеком-экспертом или, как традиционно говорят специалисты по распознаванию образов, "учителем". В этом случае не возникает вопроса о том, для формирования обобщенного образа каких классов использовать описание данного конкретного объекта.

Обучение

без учителя или самообучение –

это процесс формирования обобщенных образов классов, на основе обучающей

выборки, содержащей характеристики конкретных объектов, причем только в

описательных шкалах и градациях.

Поэтому этот процесс реализуется в три этапа:

1. Кластерный анализ объектов обучающей выборки, в результате которого определяются группы наиболее сходных их них по их признакам (кластеры).

2. Присвоение кластерам статуса обобщенных классов, для формирования обобщенных образов которых используются конкретные объекты, входящие именно в эти кластеры.

3. Формирование обобщенных образов классов, аналогично тому, как это делалось при обучении с учителем.

1.3.2.1.6. Верификация, адаптация и синтез модели

Как только произнесено или написано слово "модель", сразу неизбежно возникает вопрос о степени ее адекватности.

Верификация модели – это операция установления степени ее

адекватности (валидности) путем сравнения результатов идентификации конкретных

объектов с их фактической принадлежностью к обобщенным образам классов.

Различают внутреннюю и внешнюю, интегральную и дифференциальную валидность.

Внутренняя валидность – это способность модели верно идентифицировать объекты обучающей выборки.

Если модель имеет низкую внутреннюю валидность, то модель нельзя считать удачно сформированной.

Внешняя валидность – это способность модели верно идентифицировать объекты, не входящие в обучающую выборку.

Интегральная валидность – это средневзвешенная достоверность идентификации по всем классам и распознаваемым объектам.

Дифференциальная валидность – это способность модели верно идентифицировать объекты в разрезе по классам.

Адаптация модели – это учет в модели объектов, не входящих в обучающую выборку, но входящих в генеральную совокупность, по отношению к которой данная обучающая выборка репрезентативна.

Если моделью верно идентифицируются объекты, не входящие в обучающую выборку, то это означает, что эти объекты входят в генеральную совокупность, по отношению к которой данная обучающая выборка репрезентативна. Следовательно, на основе обучающей выборки удалось выявить закономерности взаимосвязей между признаками и принадлежностью объектов к классам, которые действуют не только в обучающей выборке, но имеют силу и для генеральной совокупности.

Адаптация модели не требует изменения классификационных и описательных шкал и градаций, а лишь объема обучающей выборки, и приводит к количественному изменению модели.

Синтез (или повторный синтез – пересинтез) модели – это учет в модели объектов, не входящих ни в обучающую выборку, ни в генеральную совокупность, по отношению к которой данная обучающая выборка репрезентативна.

Это объекты с новыми, ранее неизвестными закономерностями взаимосвязей признаков с принадлежностью этих объектов к тем или иным классам. Причем и признаки, и классы, могут быть как те, которые уже были отражены в модели ранее, так и новые. Пересинтез модели приводит к ее качественному изменению.

1.3.2.2. Проблема распознавания образов

Проблема распознавания образов сводится к двум задачам: обучения и распознавания. Поэтому, прежде чем сформулировать задачу обучения распознаванию образов уточним, в чем смысл их распознавания.

Простейшим вариантом распознавания является строгий запрос на поиск объекта в базе данных по его признакам, который реализуется в информационно-поисковых системах. При этом каждому полю соответствует признак (описательная шкала), а значению поля – значение признака (градация описательной шкалы). Если в базе данных есть записи, все значения заданных полей которых точно совпадают со значениями, заданными в запросе на поиск, то эти записи извлекаются в отчет, иначе запись не извлекается.

Более сложными вариантами распознавания является нечеткий запрос с неполнотой информации, когда не все признаки искомых объектов задаются в запросе на поиск, т.к. не все они известны, и нечеткий запрос с шумом, когда не все признаки объекта известны, а некоторые считаются известными ошибочно. В этих случаях из базы данных извлекаются все объекты, у которых совпадает хотя бы один признак и в отчете объекты сортируются (ранжируются) в порядке убывания количества совпавших признаков. При этом при определении ранга объекта в отсортированном списке все признаки считаются имеющими одинаковый "вес" и учитывается только их количество.

Однако:

– во-первых, на самом деле признаки имеют разный вес, т.е. один и тот же признак в разной степени характерен для различных объектов;

– во-вторых, нас могут интересовать не столько сами объекты, извлекаемые из базы данных прецедентов по запросам, сколько классификация самого запроса, т.е. отнесение его к определенной категории, т.е. к тому или иному обобщенному образу класса.

Если реализация строгих и даже нечетких запросов не вызывает особых сложностей, то распознавание как идентификация с обобщенными образами классов, причем с учетом различия весов признаков представляет собой определенную проблему.

Обучение осуществляется путем предъявления системе отдельных объектов, описанных на языке признаков, с указанием их принадлежности тому или другому классу. При этом сама принадлежность к классам сообщается системе человеком – Учителем (экспертом).

В результате обучения распознающая система должна приобрести способность:

1. Относить объекты к классам, к которым они принадлежат (идентифицировать объекты верно).

2. Не относить объекты к классам, к которым они не принадлежат (неидентифицировать объекты ошибочно).

Эта и есть проблема обучения распознаванию образов, и состоит она в следующем:

1. В разработке математической модели, обеспечивающей: обобщение образов конкретных объектов и формирование обобщенных образов классов; расчет весов признаков; определение степени сходства конкретных объектов с классами и ранжирование классов по степени сходства с конкретным объектом, включая и положительное, и отрицательное сходство.

2. В наполнении этой модели конкретной информацией, характеризующей определенную предметную область.

1.3.2.3. Классификация методов распознавания образов

Распознаванием образов называются задачи установления отношений эквивалентности между конкретными и обобщенными образами-моделями объектов реального или идеального мира.

Отношения эквивалентности выражают принадлежность оцениваемых объектов к каким–либо классам, рассматриваемым как самостоятельные семантические единицы.

При построении алгоритмов распознавания классы эквивалентности могут задаваться исследователем, который пользуется собственными содержательными представлениями или использует внешнюю дополнительную информацию о сходстве и различии объектов в контексте решаемой задачи. Тогда говорят о "распознавании с учителем". В противном случае, т.е. когда автоматизированная система решает задачу классификации без привлечения внешней обучающей информации, говорят об автоматической классификации или "распознавании без учителя".

Большинство алгоритмов распознавания образов требует привлечения весьма значительных вычислительных мощностей, которые могут быть обеспечены только высокопроизводительной компьютерной техникой.

Различные авторы (Ю.Л. Барабаш, В.И. Васильев, А.Л. Горелик, В.А. Скрипкин, Р. Дуда, П. Харт, Л.Т.Кузин, Ф.И. Перегудов, Ф.П. Тарасенко, Темников Ф.Е., Афонин В.А., Дмитриев В.И., Дж. Ту, Р. Гонсалес, П. Уинстон, К. Фу, Я.З. Цыпкин и др.) дают различную типологию методов распознавания образов. Одни авторы различают параметрические, непараметрические и эвристические методы, другие – выделяют группы методов, исходя из исторически сложившихся школ и направлений в данной области.

Например, в работах В.А. Дюка [32, 33], в которых дан академический обзор методов распознавания, используется следующая типология методов распознавания образов:

– методы, основанные на принципе разделения;

– статистические методы;

– методы, построенные на основе "потенциальных функций";

– методы вычисления оценок (голосования);

– методы, основанные на исчислении высказываний, в частности на аппарате алгебры логики.

В основе данной классификации лежит различие в формальных методах распознавания образов и поэтому опущено рассмотрение эвристического подхода к распознаванию, получившего полное и адекватное развитие в экспертных системах.

Эвристический подход основан на трудно формализуемых знаниях и интуиции исследователя. При этом исследователь сам определяет, какую информацию и каким образом система должна использовать для достижения требуемого эффекта распознавания.

Подобная типология методов распознавания с той или иной степенью детализации встречается во многих работах по распознаванию. В то же время известные типологии не учитывают одну очень существенную характеристику, которая отражает специфику способа представления знаний о предметной области с помощью какого–либо формального алгоритма распознавания образов.

В.А. Дюка [32, 33] выделяет два основных способа представления знаний:

– интенсиональное, в виде схемы связей между атрибутами (признаками).

– экстенсиональное, с помощью конкретных фактов (объекты, примеры).

Интенсиональное представление фиксируют закономерности и связи, которыми объясняется структура данных. Применительно к диагностическим задачам такая фиксация заключается в определении операций над атрибутами (признаками) объектов, приводящих к требуемому диагностическому результату. Интенсиональные представления реализуются посредством операций над значениями атрибутов и не предполагают произведения операций над конкретными информационными фактами (объектами).

В свою очередь, экстенсиональные представления знаний связаны с описанием и фиксацией конкретных объектов из предметной области и реализуются в операциях, элементами которых служат объекты как целостные системы.

На наш

взгляд, можно провести глубокую и далеко идущую аналогию между интенсиональными и экстенсиональными представлениями знаний и механизмами, лежащими в основе деятельности левого

и правого полушарий головного мозга человека. Если для правого полушария

характерна целостная прототипная репрезентация окружающего мира, то левое полушарие оперирует закономерностями,

отражающими связи атрибутов этого мира.

Описанные выше два фундаментальных способа представления знаний позволяют предложить следующую классификацию методов распознавания образов:

– интенсиональные методы, основанные на операциях с признаками.

– экстенсиональные методы, основанные на операциях с объектами.

Необходимо

особо подчеркнуть, что существование именно этих двух (и только двух)

групп методов распознавания: оперирующих с признаками, и оперирующих с объектами, на наш взгляд,

глубоко закономерно. С этой точки зрения ни один из этих методов, взятый

отдельно от другого, не позволяет сформировать адекватное отражение предметной

области. Между этими методами существует отношение дополнительности в смысле Н.Бора, поэтому перспективные системы распознавания

должны обеспечивать реализацию обоих этих методов, а не только какого–либо

одного из них.

Таким образом, в основу классификации методов распознавания, предложенной В.А. Дюка [32, 33], положены фундаментальные закономерности, лежащие в основе человеческого способа познания вообще, что ставит ее в совершенно особое (привилегированное) положение по сравнению с другими классификациями, которые на этом фоне выглядят более легковесными и искусственными.

1.3.2.4. Применение распознавания образов для идентификации и прогнозирования. Сходство и различие в содержании понятий "идентификация" и "прогнозирование"

Термины "Распознавание образов" и "Идентификация" являются синонимами.

Идентификация и прогнозирование часто практически ничем друг от друга не отличаются по математическим моделям и алгоритмам. Основное различие между ними состоит в том, что при идентификации признаки и состояния объекта относятся к одному времени, тогда как при прогнозировании признаки (факторы) относятся к прошлому, а состояния объекта – к будущему.

Это означает, что системы распознавания образов с успехом могут применяться не только для решения задач идентификации, но и прогнозирования.

1.3.2.5. Роль и место распознавания образов в автоматизации управления сложными системами

1.3.2.5.1. Обобщенная структура системы управления

Автоматизированная система управления состоит из двух основных частей: объекта управления и управляющей системы (рисунок 71).

Управляющая система осуществляет следующие функции:

– идентификация состояния объекта управления;

– выработка управляющего воздействия исходя из целей управления с учетом состояния объекта управления и окружающей среды;

– оказание управляющего воздействия на объект управления.

|

|

|

Рисунок 71. Обобщенная схема рефлексивной

системы управления |

1.3.2.5.2. Место системы идентификации в системе управления

Распознавание образов есть не что иное, как идентификация состояния некоторого объекта. Автоматизированная система управления АСУ), построенная на традиционных принципах, может работать только на основе параметров, закономерности связей которых уже известны, изучены и отражены в математической модели. В итоге АСУ, основанные на традиционном подходе, практически не эффективны с активными многопараметрическими слабодетерминированными объектами управления, такими, например, как макро– и микро– социально-экономические системы в условиях динамичной экономики "переходного периода", иерархические элитные и этнические группы, социум и электорат, физиология и психика человека, природные и искусственные экосистемы и многие другие.

Поэтому,

в состав перспективных АСУ, обеспечивающих устойчивое управление активными

объектами в качестве существенных функциональных звеньев должны войти

подсистемы идентификации и прогнозирования состояний среды и объекта

управления, основанные на методах искусственного интеллекта (прежде всего

распознавания образов), методах поддержки принятия решений и теории информации.

1.3.2.5.3. Управление как задача, обратная идентификации и прогнозированию

Кратко рассмотрим вопрос о применении систем распознавания образов для принятия решений об управляющем воздействии. Очевидно, что применение систем распознавания для прогнозирования результатов управления при различных сочетаниях управляющих факторов позволяет рассмотреть и сравнить различные варианты управления и выбрать наилучшие из них по определенным критериям. Однако, этот подход на практике малоэффективен, особенно если факторов много, т.к. в этом случае количество сочетаний их значений может быть чрезвычайно большим.

Если в качестве классов распознавания взять целевые и иные будущие состояния объекта управления, а в качестве признаков – факторы, влияющие на него, то в модели распознавания образов может быть сформирована количественная мера причинно-следственной связи факторов и состояний.

Это позволяет по заданному целевому состоянию объекта управления получить информацию о силе и направлении влияния факторов, способствующих или препятствующих переходу объекта в это состояние, и, на этой основе, выработать решение об управляющем воздействии.

Задача выбора факторов по состоянию является обратной задачей прогнозирования, т.к. при прогнозировании, наоборот, определяется состояние по факторам.

Факторы могут быть разделены на следующие группы:

– характеризующие предысторию объекта управления и его актуальное состояние управления;

– технологические (управляющие) факторы;

– факторы окружающей среды;

Таким образом, системы распознавания образов могут быть применены в составе АСУ в подсистемах:

– идентификации состояния объекта управления;

– выработки управляющих воздействий.

Это целесообразно в случае, когда объект управления представляет собой сложную или активную систему.

1.3.2.6. Методы кластерного анализа

Термин "Кластерный анализ" впервые ввел Tryon в 1939.

Кластеризация – это операция автоматической классификации, в ходе которой объекты объединяются в группы (кластеры) таким образом, что внутри групп различия между объектами минимальны, а между группами – максимальны. При этом в ходе кластеризации не только определяется состав кластеров, но и сам их набор и границы.

Поэтому вполне обоснованно считается, что методы кластерного анализа используются в большинстве случаев тогда, когда нет каких-либо априорных гипотез относительно классов, т.е. исследование находится на первой эмпирической стадии: описательной.

Существует большое количество различных алгоритмов кластеризации, которые обычно связаны с полным перебором объектов и весьма трудоемки в вычислительном отношении, здесь же мы упомянем лишь о трех из них:

– объединение (древовидная кластеризация);

– двухвходовое объединение;

– метод K средних.

Рассмотрим кратко эти алгоритмы (описание взято с сайта http://StatSoft.ru).

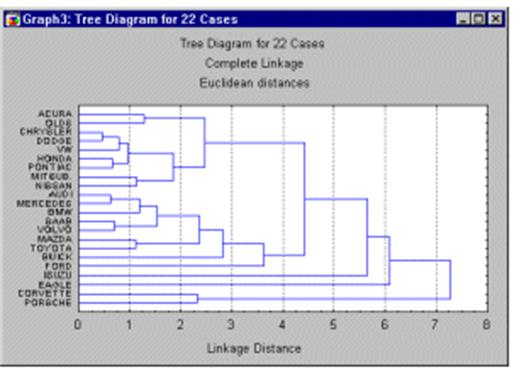

1.3.2.6.1. Древовидная кластеризация

Древовидная диаграмма (диаграмму (рисунок 72) начинается с конкретных объектов (в левой части диаграммы). Теперь представим себе, что постепенно (очень малыми шагами) вы "ослабляете" ваш критерий о том, какие объекты являются уникальными, а какие нет. Другими словами, вы понижаете порог, относящийся к решению об объединении двух или более объектов в один кластер.

В результате, вы связываете вместе всё большее и большее число объектов и агрегируете (объединяете) все больше и больше кластеров, состоящих из все сильнее различающихся элементов. Окончательно, на последнем шаге все объекты объединяются вместе.

|

|

|

Рисунок 72. Древовидная диаграмма последовательной кластеризации |

1.3.2.6.2. Двухвходовое объединение

Исследователь может кластеризовать конкретные образы наблюдаемых объектов для определения кластеров объектов со сходными признаками.

Он может также кластеризовать признаки для определения кластеров признаков, которые связаны со сходными конкретными объектами.

В двувходовом алгоритме эти процессы осуществляются одновременно.

1.3.2.6.3. Метод K средних

В этом методе принадлежность объектов к кластерам определяется таким образом, чтобы:

– минимизировать изменчивость (различия) объектов внутри кластеров;

– максимизировать изменчивость объектов между кластерами.

Контрольные вопросы

1. Основные понятия и определения, связанные с системами распознавания образов.

2. Признаки и образы конкретных объектов, метафора фазового пространства.

3. Признаки и обобщенные образы классов.

4. Обучающая выборка и ее репрезентативность по отношению к генеральной совокупности. Ремонт (взвешивание) данных.

5. Основные операции: обобщение и распознавание.

6. Обучение с учителем (экспертом) и самообучение (кластерный анализ).

7. Верификация, адаптация и синтез модели.

8. Проблема распознавания образов.

9. Классификация методов распознавания образов.

10. Применение распознавания образов для идентификации и прогнозирования. Сходство и различие в содержании понятий "идентификация" и "прогнозирование".

11. Роль и место распознавания образов в автоматизации управления сложными системами.

12. Обобщенная структура системы управления.

13. Место системы идентификации в системе управления.

14. Управление как задача, обратная идентификации и прогнозированию.

15. Методы кластерного анализа.

16. Метод кластеризации: "Древовидная кластеризация".

17. Метод кластеризации: "Двувходовое объединение".

18. Метод кластеризации: "Метод K средних".

Рекомендуемая литература

1. Луценко Е.В. Теоретические основы и технология адаптивного семантического анализа в поддержке принятия решений (на примере универсальной автоматизированной системы распознавания образов "ЭЙДОС-5.1"). - Краснодар: КЮИ МВД РФ, 1996. - 280с.

2. Луценко Е. В. Автоматизированный системно-когнитивный анализ в управлении активными объектами (системная теория информации и ее применение в исследовании экономических, социально-психологических, технологических и организационно-технических систем): Монография (научное издание). – Краснодар: КубГАУ. 2002. – 605 с.

1.3.3.

ЛЕКЦИЯ-9.

Математические методы

и автоматизированные системы

поддержки принятия решений

Учебные

вопросы

1. Многообразие задач принятия решений.

2. Языки описания методов принятия решений.

3. Выбор в условиях неопределенности.

4. Решение как компромисс и баланс различных интересов. О некоторых ограничениях оптимизационного подхода.

5. Экспертные методы выбора.

6. Юридическая ответственность за решения, принятые с применением систем поддержки принятия решений.

7. Условия корректности использования систем поддержки принятия решений.

8. Хранилища данных для принятия решений.

1.3.3.1. Многообразие задач принятия решений

1.3.3.1.1. Принятие решений, как реализация цели

Определение: принятие решения есть действие над

множеством альтернатив, в результате которого исходное множество альтернатив

сужается. Это действие называется "выбор".

Выбор является действием, придающим всей деятельности целенаправленность. Именно через акты выбора реализуется подчиненность всей деятельности определенной цели или совокупности взаимосвязанных целей.

Таким образом, для того, чтобы стал возможен акт выбора, необходимо следующее:

Порождение или обнаружение множества альтернатив, на котором предстоит совершить выбор.

Определение целей, ради достижения которых осуществляется выбор.

Разработка и применение способа сравнения альтернатив между собой, т.е. определение рейтинга предпочтения для каждой альтернативы, согласно определенным критериям, позволяющим косвенно оценивать, насколько каждая альтернатива соответствует цели.

Современные работы в области поддержки принятия решений выявили характерную ситуацию, которая состоит в том, что полная формализация нахождения наилучшего (в определенном смысле) решения возможна только для хорошо изученных, относительно простых задач, тогда как на практике чаще встречаются слабо структурированные задачи для которых полностью формализованных алгоритмов не разработано (если не считать полного перебора и метода проб и ошибок). Вместе с тем, опытные, компетентные и способные специалисты, часто делают выбор, который оказывается достаточно хорошим. Поэтому современная тенденция практики принятия решений в естественных ситуациях состоит в сочетании способности человека решать неформализованные задачи с возможностями формальных методов и компьютерного моделирования: диалоговые системы поддержки принятия решений, экспертные системы, адаптивные человеко-машинные автоматизированные системы управления, нейронные сети и когнитивные системы.

1.3.3.1.2. Принятие решений, как снятие неопределенности (информационный подход)

Процесс получения информации можно рассматривать как уменьшение неопределенности в результате приема сигнала, а количество информации, как количественную меру степени снятия неопределенности.

Но в результате выбора некоторого подмножества альтернатив из множества, т.е. в результате принятия решения, происходит тоже самое (уменьшение неопределенности).

Это значит, что каждый выбор, каждое решение порождает определенное количество информации, а значит может быть описано в терминах теории информации.

Простейшее понятие об информации (подход Хартли).

Будем считать, что если существует множество элементов и осуществляется выбор одного из них, то этим самым сообщается или генерируется определенное количество информации. Эта информация состоит в том, что если до выбора не было известно, какой элемент будет выбран, то после выбора это становится известным.

Найдем вид функции, связывающей количество информации, получаемой при выборе некоторого элемента из множества, с количеством элементов в этом множестве, т.е. с его мощностью.

Если множество элементов, из которых осуществляется выбор, состоит из одного-единственного элемента, то ясно, что его выбор предопределен, т.е. никакой неопределенности выбора нет. Таким образом, если мы узнаем, что выбран этот единственный элемент, то, очевидно, при этом мы не получаем никакой новой информации, т.е. получаем нулевое количество информации.

Если множество состоит из двух элементов, то неопределенность выбора минимальна. В этом случае минимально и количество информации, которое мы получаем, узнав, что совершен выбор одного из элементов. Минимальное количество информации получается при выборе одного из двух равновероятных вариантов. Это количество информации принято за единицу измерения и называется "бит".

Чем больше элементов в множестве, тем больше неопределенность выбора, тем больше информации мы получаем, узнав о том, какой выбран элемент.

Рассмотрим множество, состоящее из чисел в двоичной системе счисления длиной i двоичных разрядов. При этом каждый из разрядов может принимать значения только 0 и 1 (таблица 32).

Таблица 32 – К ЭВРИСТИЧЕСКОМУ ВЫВОДУ ФОРМУЛЫ КОЛИЧЕСТВА ИНФОРМАЦИИ

ПО ХАРТЛИ

|

Кол-во двоичных разрядов (i) |

Кол-во состояний N, которое можно

пронумеровать i-разрядными двоичными

числами |

Основание системы счисления |

||

|

10 |

16 |

2 |

||

|

1 |

2 |

0 1 |

0 1 |

0 1 |

|

2 |

4 |

0 1 2 3 |

0 1 2 3 |

00 01 10 11 |

|

3 |

8 |

0 1 2 3 4 5 6 7 |

0 1 2 3 4 5 6 7 |

000 001 010 011 100 101 110 111 |

|

4 |

16 |

0 1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 |

0 1 2 3 4 5 6 7 8 9 A B C D E F |

0000 0001 0010 0011 0100 0101 0110 0111 1000 1001 1010 1011 1100 1101 1110 1111 |

|

*** |

*** |

|

|

|

|

i |

N=2i |

|

|

|

Из таблицы 32 очевидно, что количество этих чисел (элементов) в множестве равно:

|

|

|

Рассмотрим процесс выбора чисел из рассмотренного множества. До выбора вероятность выбрать любое число одинакова. Существует объективная неопределенность в вопросе о том, какое число будет выбрано. Эта неопределенность тем больше, чем больше N – количество чисел в множестве, а чисел тем больше – чем больше разрядность i этих чисел.

Примем, что выбор одного числа дает нам следующее количество информации:

|

|

|

Таким

образом, количество информации, содержащейся в двоичном числе, равно количеству

двоичных разрядов в этом числе. Это количество информации i мы получаем, когда

случайным равновероятным образом выпадает одно из двоичных чисел, записанных i

разрядами, или из некоторого множества выбирается объект произвольной природы,

пронумерованный этим числом (предполагается, что остальные объекты этого

множества пронумерованы остальными числами и этим они и отличаются).

Это выражение и представляет собой формулу Хартли для количества информации. Отметим, что оно полностью совпадает с выражением для энтропии (по Эшби), которая рассматривалась им как количественная мера степени неопределенности состояния системы.

Сам Хартли, возможно, пришел к своей мере на основе эвристических соображений, подобных только что изложенным, но в настоящее время строго доказано, что логарифмическая мера для количества информации однозначно следует из этих двух постулированных им условий.

Таким образом, информация по своей сущности

теснейшим и органичным образом связана с выбором и принятием решений.

Отсюда

следует простейшее на первый взгляд заключение: "Для принятия решений нужна информация, без информации принятие

решений невозможно, значение информации для принятия решений является определяющим,

процесс принятия решений генерирует информацию".

Мера Шеннона, как обобщение меры Хартли для неравновероятных событий.

Представим себе, что имеются объекты различных видов, причем:

– всего имеется M видов объектов;

– объектов каждого i-го вида имеется Ni.