1.1.2.

ЛЕКЦИЯ-2.

Определение и критерии идентификации

систем искусственного интеллекта

Учебные вопросы

1. Данные, информация, знания. Системно-когнитивный анализ как развитие концепции смысла Шенка-Абельсона.

2. Понятие: "Система искусственного интеллекта", место СИИ в классификации информационных систем.

3. Определение и классификация систем искусственного интеллекта, цели и пути их создания.

4. Информационная модель деятельности специалиста и место систем искусственного интеллекта в этой деятельности.

5. Жизненный цикл системы искусственного интеллекта и критерии перехода между этапами этого цикла.

1.1.2.1. Данные, информация, знания. Системно-когнитивный анализ как развитие концепции смысла Шенка-Абельсона

1.1.2.1.1. Постановка проблемы

При создании систем искусственного интеллекта разработчики оперируют такими основополагающими понятиями, как:

– данные,

информация, знания;

– факт,

смысл, мысль;

–

мониторинг, анализ и управление.

От того, какое конкретное содержание вкладывается разработчиками в данные понятия, самым существенным образом зависят и подходы к созданию математических моделей, структур данных и алгоритмов функционирования СИИ.

Проблема состоит в том, что смысловое содержание этих понятий чаще всего не конкретизируется.

И это не случайно. Одной из основных причин этого положения дел, на наш взгляд, является то, что конкретизировать смысловое содержание данных понятий представляется возможным лишь на основе интуитивно-ясной и хорошо обоснованной концепции смысла.

Однако, как это ни удивительно и парадоксально, но реальные разработчики СИИ, обычно являющиеся математиками и программистами, чаще всего недостаточно знакомы с подобными концепциями.

Конечно, возникает вопрос о том, насколько вообще возможны, т.е. имеют смысл концепции смысла, не бессмысленны ли они? Может быть вопрос: "Какой смысл имеют концепции смысла?" – является одним из вариантов логического парадокса Рассела? Хотя эти вопросы имеют "несерьезный" оттенок, по сути, они сводятся к очень серьезному вопросу о том, насколько или в какой степени интеллект может познать сам себя, т.е. о том, является интеллектуальная форма познания адекватным инструментом для познания интеллекта? В более общем теоретическом плане этот вопрос может быть сформулирован и так: "Может ли часть системы адекватно отразить (отобразить) систему в целом?", или, другими словами, "Может ли система в целом в определенном смысле включать себя как составную часть?"

От ответа на эти вопросы самым непосредственным образом зависит и ответ на ключевой вопрос о том, может ли человек создать искусственный интеллект по своему образу и подобию.

Мы отвечаем на эти вопросы утвердительно. Более того, системы, содержащие информацию о системе в целом в каждой своей части определенного уровня структурной иерархии, широко известны, это:

– биологические системы в каждой клетке которых (кроме половых) содержится полный геном;

– фрактальные системы;

– высокоорганизованные системы с большой взаимной информацией в своих частях, успешно противостоящие закону возрастания энтропии.

Выдающийся немецкий философ Георг Вильгельм Фридрих Гегель называл такие системы "Истинно бесконечными".

1.1.2.1.2. Традиционные пути решения проблемы

1.1.2.1.2.1. Классификация и характеристика концепций смысла

Наиболее полный и всесторонний на данный момент обзор различных подходов к автоматизации процессов понимания смысла дан в основополагающей работе Л.Г. Васильева [10].

Все теории понимания смысла классифицированы им на три группы: объектные; субъект-объектные; субъектные.

Объектные теории основаны на структурно-семантическом анализе, а понимание онтологизируется, т.е. приравнивается к самому объекту. Понять означает установить значение языкового знака.

Субъект-объектные теории синтактико-семантический анализ дополняют прагмалингвистическим описанием или описанием реальных психологических процессов при создании и/или анализе языкового знака.

Субъектные теории помимо собственно процедур понимания акцентируют внимание на оценке реципиентом результатов понимания (при помощи обратной связи в диалоге, рефлексии или монологе).

1.1.2.1.2.2. Суть концепции смысла Шенка-Абельсона

Согласно Л.Г. Васильеву [10] суть концепции смысла Шенка-Абельсона состоит в том, что факты рассматриваются как причины и их смысл считается известным, если известны последствия данного факта. Таким образом, понимание смысла определенных конкретных событий заключается в выявлении причинно-следственных взаимосвязей между этими событиями и другими.

По нашему мнению, данная концепция смысла является одной из наиболее интуитивно убедительных и хорошо обоснованных, поэтому она в целом принята нами за основу.

Естественно, в этой концепции одним из ключевых моментов является определение способа выявления силы и направленности влияния причинно-следственных взаимосвязей и их количественной оценки (меры).

На наш взгляд слабым местом концепции смысла Шенка-Абельсона является сложность корректного и обоснованного выбора количественной меры силы и направленности причинно-следственных связей, а также конкретного способа определения численной величины этой меры в каждом конкретном случае (т.е. для каждого факта), причем непосредственно на основе эмпирических данных.

Проблема в том, что в общественном сознании продолжает господствовать упрощенческая точка зрения, состоящая в том, что корреляция является мерой причинно-следственных связей. И это имеет место не смотря на многочисленные разъяснения в специальной литературе о том, что это не так, точнее не совсем так.

Поэтому одной из целей данной работы будет обоснована другой меры силы и направленности причинно-следственных взаимодействий.

1.1.2.1.3. Идея решения проблемы

1.1.2.1.3.1. Формулировка идеи

Предлагаемая идея создания искусственного интеллекта очень проста и состоит в том, что для этого предлагается:

– во-первых, выявить основные моменты играющие существенную роль при создании естественного интеллекта;

– во-вторых, попробовать реализовать эти моменты на базе современных компьютерных технологий.

Наблюдения за системами естественного интеллекта позволяют сформулировать следующую гипотезу.

1. Естественный интеллект реально существует.

2. Естественный интеллект создается не мгновенно, а в течение довольно длительного времени по вполне определенной сложной технологии, которая включает три основных этапа:

– создание материальной системы поддержки естественного интеллекта по сложной технологии в изолированных от среды условиях;

– создание активной информационной структуры, базирующейся на материальной системе поддержки, способной к развитию и саморазвитию в систему естественного интеллекта, т.е. создание системы потенциального естественного интеллекта (оболочки, инструментальной системы);

– формирование структуры и функций естественного интеллекта во взаимодействии системы его поддержки с другими подобными системами и с окружающей средой, как с природной, так и с "социальной", т.е. созданной другими подобными системами, в результате чего происходит трансформация системы потенциального естественного интеллекта в систему реального естественного интеллекта.

3. Системы искусственного интеллекта (СИИ) полностью функционально эквивалентные естественному интеллекту могут быть созданы на базе другой материальной структуры системы поддержки системы и другой системы потенциального искусственного интеллекта.

4. Создание СИИ должно включать три этапа:

– создание материальной системы поддержки (эта проблема в основном решена, т.к. СИИ могут создаваться даже на базе современных персональных компьютеров);

– создание системы потенциального искусственного интеллекта, т.е. программной оболочки, инструментальной системы (таких систем в настоящее время существует пока еще очень мало);

– обучение и самообучение системы потенциального искусственного интеллекта и преобразование ее в реальную СИИ.

5. Основополагающую роль в создании системы потенциального искусственного интеллекта играет разработка научной концепции и теории, адекватно отражающей способы реализации функций естественного интеллекта и пути его трансформации из потенциального в реальный.

1.1.2.1.3.2. Обоснование принципиальной возможности реализации идеи

Относительная независимость функций от поддерживающих их структур

При рассмотрении самой идеи реализации естественного интеллекта на иной материальной основе сразу возникает вопрос о том, на сколько это вообще в принципе возможно, т.е. вопрос о том, могут ли интеллектуальные функции быть реализованы на основе иной, чем мозг, материальной структуры. Это вопрос о соотношении функций и поддерживающих их структур.

Конечно, структура зависит от функций, которые она поддерживает, и в целом более сложные функции поддерживаются более сложными структурами. Однако к счастью эта связь "структура – функция" не однозначна, т.е. одни и те же функции могут поддерживаться самыми разнообразными, т.е. альтернативными структурами. Так, например, согласно современным представлениям (В.А. Драгавцев) определенные фенотипические признаки могут поддерживаться различными генными ансамблями, а не только конкретными генами, как в теории Менделя.

Если ген уподобить букве алфавита, а смысл фразы – фенотипическому признаку, то можно сказать, что возможно очень большое количество фраз с одним и тем же смысловым содержанием (тогда как в классической генетике считалось, что признак соответствует гену, хотя есть и такие). После расшифровки генома человека мы настолько же приблизились к его пониманию, как изучивший русскую или немецкую азбуку англичанин, не знающий этих языков, приблизился к чтению в оригинале и пониманию содержания "Войны и Мира" Льва Толстого или "Феноменологии Духа" Георга В.Ф.Гегеля.

При этом обычно функциональная универсальность достигается за счет определенной структурной избыточности, что неизбежно приводит к уменьшению эффективности поддержки конкретных функций, по сравнению с их специализированной реализацией. На этих закономерностях самым существенным образом основано все развитие нашей технократической цивилизации, т.к. прогресс техники представляет собой ни что иное, как процесс последовательной передачи трудовых функций человека средствам труда.

И системы искусственного интеллекта, с этой точки зрения, представляют собой совершенно закономерный, более того – даже неизбежный, этап развития информационных средств труда, т.е. современных информационных технологий.

Но функция (или определенное качество) вполне корректно рассматривать и как свойство соответствующей поддерживающей его структуры. Поэтому, для того, чтобы сформировать более углубленное представление о соотношении структуры и поддерживаемых ими функций кратко рассмотрим диалектику "Структура – свойство – отношение".

Диалектика: "Структура – свойство – отношение"

Рассмотрим простой пример. Два электрона определенным образом взаимодействуют друг с другом, находясь в определенных отношениях, а именно – отталкиваясь друг от друга с различной силой, зависящей от расстояния между ними. Но о каждом электроне можно сказать, что он обладает свойством отталкиваться от другого электрона. Чем поддерживается (обеспечивается) это свойство электронов, благодаря которому они могут быть в определенных отношениях друг с другом?

В науке настоящего времени считается, что существует соответствующая материальная структура, которая называется "электрическое поле" и является одной из форм электромагнитного поля. Возникает вопрос - а может ли эта структура существовать независимо от электрона?

Уже давно Герцем и Максвеллом получен однозначный положительный ответ на этот вопрос: "Да, может, и это – электромагнитные волны!!!"

Таким образом, свойство может существовать как некая материальная структура отдельно и независимо от объекта, свойством которого оно являлось и благодаря которому этот объект вступал в определенные отношения с другими объектами, обладавшими тем же свойством.

Так нам светят звезды, которых, давно уже нет. Мы восхищаемся произведениями художников, поэтов и музыкантов давно прошедших времен. Поэтому шутка Л.Кэррола об улыбке Чеширского кота, висевшей в воздухе, хотя сам кот и ушел, не так уж и далека от истины. Ряд исследований о квантовой природе сознания [165, 219] свидетельствует в пользу того, что определенные формы сознания может существовать независимо от физического организма.

Итак, существуют

различные точки зрения на одно и то же, которое, при различных условиях, может

рассматриваться либо как определенные отношения

объектов, либо как свойства этих

объектов, на которых основаны их отношения, либо как самостоятельно

существующая материальная структура.

Каждая точка зрения имеет право на существование, но, по-видимому, каждая последующая из этих точек зрения является более глубокой, чем предыдущая.

1.1.2.1.4. Когнитивная концепция СК-анализа и синтез когнитивного конфигуратора

В качестве теории, позволяющей конкретизировать основополагающие понятия, связанные с СИИ, предлагается системно-когнитивный анализ (СК-анализ), представляющий собой системный анализ, как метод познания, т.е. структурированный по базовым когнитивным операциям.

Когнитивная концепция СК-анализа разработана с учетом двух основных требований:

1. Адекватное отражение в когнитивной концепции реальных процессов, реализуемых человеком в процессах познания.

2. Высокая степень приспособленности

когнитивной концепции для формализации в виде достаточно простых математических

и алгоритмических моделей, допускающих прозрачную программную реализацию в

автоматизированной системе.

1.1.2.1.4.1. Понятие когнитивного конфигуратора и необходимость естественнонаучной (формализуемой) когнитивной концепции

Определение понятия конфигуратора

Понятие

конфигуратора, по-видимому, впервые предложено В.А. Лефевром [148], хотя

безусловно это понятие использовалось и раньше, но, во-первых, оно не получало

самостоятельного названия, а, во-вторых, использовалось в частных случаях и не

получало обобщения. Под конфигуратором

В.А.Лефевр понимал минимальный полный набор понятийных шкал или конструктов,

достаточный для адекватного описания предметной области. Примеры

конфигураторов приведены в [148].

Понятие когнитивного конфигуратора

В

исследованиях по когнитивной психологии изучается значительное количество

различных операций, связанных с процессом познания [64]. Однако, насколько известно из литературы,

психологами не ставился вопрос о выделении из всего множества когнитивных

операций такого минимального (базового) набора наиболее элементарных из них, из

которых как составные могли бы строится другие операции. Ясно, что для

выделения таких базовых когнитивных операций (БКО) необходимо построить их

иерархическую систему, в фундаменте которой будут находится наиболее

элементарные из них, на втором уровне – производные от них, обладающие более

высоким уровнем интегративности, и т.д.

Таким

образом, под когнитивным конфигуратором будем понимать минимальный полный набор

базовых когнитивных операций, достаточный для представления различных процессов

познания.

Когнитивные концепции и операции

Проведенный анализ когнитивных концепций показал, что они разрабатывались ведущими психологами (Пиаже, Солсо, Найсер) [64] без учета требований, связанных с их дальнейшей формализацией и автоматизацией. Поэтому имеющиеся концепции когнитивной психологии слабо подходят для этой цели; в когнитивной психологии не ставилась и не решалась задача конструирования когнитивного конфигуратора и, соответственно, не сформулировано понятие базовой когнитивной операции.

1.1.2.1.4.2. Базовая когнитивная концепция

Автоматизировать процесс познания в целом безусловно значительно сложнее, чем отдельные операции процесса познания. Но для этого прежде всего необходимо:

– выявить эти операции;

– найти место каждой из них в системе или последовательности процесса познания.

Сделать это предлагается в форме когнитивной концепции, которая должна удовлетворять следующим требованиям:

– адекватность, т.е. точное отражение сущности процессов познания, характерных для человека, в частности описание процессов вербализации, семантической адаптации и семантического синтеза (уточнения смысла слов и понятий и включения в словарь новых слов и понятий);

– высокая степень детализации и структурированности до уровня достаточно простых базовых когнитивных операций;

– возможность математического описания, формализации и автоматизации.

Однако приходится констатировать, что даже концепции когнитивной психологии, значительно более конкретные, чем философские (гносеологические), разрабатывались без учета необходимости построения реализующих их математических и алгоритмических моделей и программных систем. Более того, в когнитивной психологии из всего многообразия различных исследуемых когнитивных операций не выделены базовые, к суперпозиции и различным вариантам сочетаний которых сводятся различные процессы познания. В этой науке в настоящее время господствует эмпирический подход, т.е. имеется тенденция не к теоретическим обобщениям, а тщательному изучению отдельных когнитивных операций. Поэтому для достижения целей данного исследования концепции когнитивной психологии мало применимы.

В связи с этим в данном исследовании предлагается когнитивная концепция, удовлетворяющая сформулированным выше требованиям. Эта концепция достаточно проста, иначе было бы невозможно ее формализовать, многие ее положения интуитивно очевидны или хорошо известны, тем ни менее в целостном виде она впервые сформулирована лишь в работах [64, 91]. Положения когнитивной концепции приведены в определенном порядке, соответствующем реальному ходу процесса познания "от конкретных эмпирических исходных данных к содержательным информационным моделям, а затем к их верификации, адаптации и, в случае необходимости, к пересинтезу".

На базе выше сформулированных положений предложена целостная система взглядов на процесс познания, т.е. формализуемая когнитивная концепция [64], предназначенная для построения систем искусственного интеллекта.

Суть предложенной когнитивной концепции

Процесс познания рассматривается нами как многоуровневая иерархическая система обработки информации, в которой каждый последующий уровень является результатом интеграции элементов предыдущего уровня. На 1-м уровне этой системы находятся дискретные элементы потока чувственного восприятия, которые на 2-м уровне интегрируются в чувственный образ конкретного объекта. Те, в свою очередь, на 3-м уровне интегрируются в обобщенные образы классов и факторов, образующие на 4-м уровне кластеры, а на 5-м конструкты. Система конструктов на 6-м уровне образуют текущую парадигму реальности (т.е. человек познает мир путем синтеза и применения конструктов). На 7-м же уровне обнаруживается, что текущая парадигма не является единственно-возможной.

Данные, информация, знания

Существует неопределенность смыслового содержания "разночтения" терминов: "данные", "информация", "знания". Мы считаем целесообразным определить их следующим образом.

Данные представляют собой информацию, рассматриваемую в чисто синтаксическом аспекте, т.е. безотносительно к ее содержанию и использованию, т.е. семантике и телеологии (обычно на каком-либо носителе или в канале передачи).

Информация – это данные, проинтерпретированные с использованием тезауруса, т.е. осмысленные данные, рассматриваемые в единстве синтаксического и семантического аспектов.

Знания, есть система информации, обеспечивающая увеличение вероятности достижения какой-либо цели, т.е. по сути знания – это "Ноу-хау" или технологии.

Вышесказанное резюмируем в следующей форме:

знание

= информация + цель

информация

= данные + смысл;

знания

= данные + смысл + цель.

При разработке предложенной интерпретации

содержания данных понятий и формы его представления учтены и использованы

разработки Лаптева В.Н., а также Владимира Кива, приведенные на его сайте: http://vlak.webzone.ru/rus/it/knowledge.html.

В этой связи необходимо отметить, что название теории информации Шеннона не вполне соответствует предлагаемому пониманию содержания понятий "данные – информация – знания": теорию Шеннона по сути дела более точно было бы называть "теорией передачи данных по каналам связи". Общеизвестная количественная мера Шеннона "для измерения количества информации" также в этом смысле является лишь мерой количества данных, т.к. не содержит семантического аспекта.

Количественная теория автоматизированной интерпретации данных, основанная на теории информации, в настоящее время лишь только создается и получила название семантической теории информации. Предложены различные количественные меры для измерения смысла информации [64]. Из этих мер выделяется мера А.Харкевича, в основу которой положено понятие цели.

В литературе и А.Харкевичем это не отмечается, но, учитывая вышеизложенное, по сути дела можно утверждать, что по сути дела им в 1962 году впервые предложена научная количественная мера знаний.

Однако предложенная А.Харкевичем мера не удовлетворяет принципу соответствия, обязательному для более общей теории, аналогично тому, как, например, мера Шеннона сводится к мере Хартли в случае равновероятных событий. Поэтому теория А.Харкеивча как бы "стояла особняком" от теории информации Найквиста-Хартли-Больцмана и Шеннона и в этом плане она нуждалась в развитии, что и было осуществлено автором [1, 64, 75, 79, 93].

Известно, что корреляция не является мерой причинно-следственных связей. Если корреляция между действием некоторого фактора и переходом объекта управления в определенное состояние высока, то это еще не значит, что данный фактор является причиной этого перехода. Для того чтобы по корреляции можно было судить о наличии причинно-следственной связи необходимо сравнить исследуемую группу с контрольной группой, т.е. с группой, в которой данный фактор не действовал.

Также и высокая вероятность перехода объекта управления в определенное состояние в условиях действия некоторого фактора сама по себе не говорит о наличии причинно-следственной связи между ними, т.е. о том, что данный фактор обусловил переход объекта в это состояние. Это связано с тем, что вероятность перехода объекта в это состояние может быть и сама по себе очень высокой независимо от действия фактора. Поэтому в качестве меры силы причинной обусловленности определенного состояния объекта действием некоторого фактора Харкевич предложил логарифм отношения вероятностей перехода в объекта в это состояние в условиях действия фактора и при его отсутствии или в среднем (13). Таким образом, вероятность перехода объектов в некоторое состояние в исследуемой группе сравнивается с средней вероятностью перехода в это состояние по всем группам и это среднее выступает в качестве контрольной группы.

Таким образом семантическая мера информации

Харкевича является мерой наличия причинно-следственных связей между факторами и

состояниями объекта управления.

В связи с тем, что подход Харкевича является ярким примером нормативного подхода, будет уместно вспомнить о нормативном и критериальном подходах к оценке (идентификации) состояния объекта.

При критериальном подходе это состояние оценивают по жесткой системе критериев. Правда при этом остается открытым вопрос о том, каким образом формируется эта система критериев.

При нормативном подходе, который получил свое

название от понятия "норма", сначала формируется эта норма, а затем

состояние объектов оценивается относительно этой нормы. В частности, если это

сформированное понятие нормы зафиксировать, стандартизировать, как и критерии

его определения и сравнения с ним, то мы получим одни из вариантов синтеза

критериального подхода.

Мониторинг, анализ, прогнозирование, управление

Существует определенная иерархия задач обработки данных, информации и знаний:

Мониторинг – накопление данных по ряду показателей об объекте управления с привязкой ко времени.

Анализ – выявление смысла в данных, т.е. выявление в них причинно-следственных взаимосвязей.

Прогнозирование – использование смысла причинно-следственных зависимостей в предметной области для предсказания поведения объекта управления в условиях действия определенных факторов.

Управление – использования знаний для достижения определенных целей управления:

– сохранение стабильного функционирования объекта управления;

– перевод объекта управления в заранее заданное целевое состояние.

Таким образом, управление – это высшая форма обработки и использования информации.

Факт, смысл, мысль

Ключевым для когнитивной концепции является

понятие факта.

Под фактом будем понимать соответствие дискретного и интегрального элементов познания, т.е. элементов разных уровней интеграции-иерархии процессов познания, обнаруженное на опыте.

Факт рассматривается как квант смысла. Это является основой для формализации смысла.

Смысл представляет собой "разность потенциалов" между смежными уровнями интеграции-иерархии в системе обработки информации в процессах познания.

Мысль является операцией выявления смысла из

фактов.

Мышление есть процесс, состоящий из ряда

взаимосвязанных по смыслу мыслей.

Но существуют различные формы мыслей, которые перед разработкой методов формализации и программной реализации необходимо классифицировать и выявить среди них основные, т.е. такие, к которым сводятся все остальные или по крайней мере большинство из них. Как уже отмечалось выше, сделать это предлагается на основе базовой когнитивной концепции.

Иерархическая структура (пирамида) обработки информации

Сказанное в разделах 4.2.2–4.2.4 можно резюмировать в графической диаграмме, в форме "Мексиканской" (ступенчатой) пирамиды (рисунок 4).

|

|

|

Рисунок 4. Иерархическая структура обработки информации |

Базовая когнитивная концепция в свободном изложении

Исходные данные для процесса познания поставляются из нескольких независимых информационных источников, имеющих качественно различную природу, которые мы будем условно называть "органы чувств". Данные от органов чувств также имеют качественно различную природу, обусловленную конкретным видом информационного источника. Для обозначения этих исходных данных будем использовать термин "атрибут". В результате выполнения когнитивной операции "присвоение имен" атрибутам могут быть присвоены уникальные имена, т.е. они могут быть отнесены к некоторым градациям номинальных шкал. Получение информации о предметной области в атрибутивной форме осуществляется когнитивной операцией "восприятие".

Исходные данные содержат внутренние закономерности, объединяющие качественно разнородные исходные данные от различных информационных источников.

После восприятия предметной области может быть проведен ее первичный анализ путем выполнения когнитивной операции: "сопоставление опыта, воплощенного в модели, с общественным", т.е. с результатами восприятия той же предметной области другими. Это делается с целью исключения из дальнейшего анализа всех наиболее явных расхождений, как сомнительных.

Однако, закономерности в предметной области могут быть выявлены путем выполнения когнитивной операции "обобщение" только после накопления в результате мониторинга достаточно большого объема исходных данных в памяти.

Наличие этих закономерностей позволяют предположить, что:

– существуют некие интегративные структуры, не сводящиеся ни к одному из качественно-различных аспектов исходных данных и обладающие по отношению к ним системными, т.е. эмерджентными свойствами, которые не могут быть предметом прямого восприятия с помощью органов чувств, но могут являться предметом для других форм познания, например логической формы. Для обозначения этих структур будем использовать термин "объект";

– "объекты" считаются причинами существования взаимосвязей между атрибутами.

Объектам приписывается объективное существование, в том смысле, что любой объект обнаруживается несколькими независимыми друг от друга способами с помощью различных органов чувств (этот критерий объективного существования в физике называется "принцип наблюдаемости").

После обобщения возможны когнитивные операции: "определение значимости шкал и градаций атрибутов" и "определение степени сформированности шкал и градаций классов".

Путем выполнения когнитивной операции "присвоение имен" конкретным объектам могут быть присвоены уникальные имена, т.е. они могут быть отнесены к некоторым градациям номинальной шкалы, которые мы будем называть "классами". В данном случае класс представляет собой отображение объекта шкалу, т.е. это своего рода целостный образ объекта. После этого возможно выполнение когнитивной операции "идентификация" объектов, т.е. их "узнавание": при этом по атрибутам объекта определяется класс, к которому принадлежит объект. При этом все атрибуты, независимо от их качественно различной природы, рассматриваются с одной-единственной точки зрения: "Какое количество информации они несут о принадлежности данного объекта к каждому из классов".

Кроме того возможно выполнение когнитивной операции: "дедукция и абдукция, обратная задача идентификации и прогнозирования", имеющей очень важное значение для управления, т.е. вывод всех атрибутов в порядке убывания содержащегося в них количества информации о принадлежности к данному классу.

Аналогично, может быть выполнена когнитивная операция: "семантический анализ атрибута", представляющий собой список классов, в порядке убывания количества информации о принадлежности к ним, содержащейся в данном атрибуте.

Таким образом возможно два взаимно-дополнительных способа отображения объекта: в форме принадлежности к некоторому классу (целостное, интегральное, экстенсиональное); в форме системы атрибутов (дискретное, интенсиональное).

Дальнейшее изучение атрибутов позволяет ввести понятия "порядковая шкала" и "градация". Порядковая шкала представляет собой способ классификации атрибутов одного качества, обычно по степени выраженности (интенсивности). Градация – это конкретное положение или диапазон на шкале, которому ставится в соответствие конкретный атрибут, соответствующее определенной степени интенсивности. Каждому виду атрибутов, информация о которых получается с помощью определенного "органа чувств", ставится в соответствие одна шкала. Таким образом, если при анализе в номинальных шкалах, можно было в принципе ввести одну шкалу для всех атрибутов, то в порядковых шкалах каждому атрибуту будет соответствовать своя шкала.

После идентификации уникальных объектов с классами возможна их классификация и присвоение обобщающих имен группам похожих классов. Для обозначения группы похожих классов используем понятие "кластер". Формирование кластеров осуществляется с помощью когнитивной операции "классификация". Кластер представляет собой своего рода "объект, состоящий из объектов", т.е. объект 2-го порядка. Если объект выполняет интегративную функцию по отношению к атрибутам, то кластер – по отношению к объектам.

Необходимо подчеркнуть, что термин "класс" используется не только для обозначения образов уникальных объектов, но и для обозначения их кластеров, т.е. классу может соответствовать не уникальное, а обобщающее имя, в этом случае мы имеем дело с обобщенным классом. Да и кластеры могут быть не только кластерами уникальных объектов, но и обобщенных классов.

Если объективное существование уникальных объектов мало у кого вызывает сомнение, то вопрос об объективном существовании интегративных структур 2-го и более высоких порядков остается открытым. В некоторых философских системах подобным объектам приписывался даже более высокий статус существования, чем самим объектам, например обычные объекты рассматриваются лишь как "тени" "Эйдосов" (Платон). Известны и другие понятия для обозначения объектов высоких порядков, например "архетип" (Юм), "эгрегор" (Андреев) и др. Нельзя не отметить, что в современной физике (специальной и общей теории относительности) есть подобное понятие пространственно-временного интервала, который проявляется как движение объекта. По-видимому, статус существования структур реальности, отражаемых когнитивными структурами тем выше, чем выше интегративный уровень этих структур.

Являясь объектами 2-го порядка сами кластеры в результате выполнения когнитивной операции "генерация конструктов" могут быть классифицированы по степени сходства друг с другом. Для обозначения системы двух противоположных кластеров, с "спектром" промежуточных кластеров между ними, будем использовать термин "бинарный конструкт", при этом сами противоположные кластеры будем называть "полюса бинарного конструкта". Таким образом конструкт представляет собой объект 3-го порядка.

Словом "бинарный" определяется, что в данном случае полюсов у конструкта всего два, но этим самым подчеркивается, что в принципе их может быть 3, 4 и больше. Бинарный конструкт можно формально представить в виде порядковой шкалы или даже шкалы отношений, на которой градациям соответствуют кластеры, а значит и сами классы и соответствующие объекты. Конструкты с количеством полюсов больше 2 могут быть представлены графически в форме семантических сетей в которых полюса являются вершинами, а дуги имеют цвет и толщину, соответствующие степени сходства-различия этих вершин. Семантические сети можно считать также просто графической формой представления результатов кластерного анализа.

Аналогично кластерам и конструктам классов формируются кластеры и конструкты атрибутов. В кластеры объединяются атрибуты, имеющие наиболее сходный смысл. В качестве полюсов конструктов выступают кластеры атрибутов, противоположных по смыслу.

Бинарные конструкты классов и атрибутов представляет собой когнитивные структуры, играющие огромную роль в процессах познания. Не будет преувеличением сказать, что познание представляет собой процесс генерации, совершенствования и применения конструктов. Будем считать, что конструкт тем более совершенен и тем выше его качество, чем сильнее отличаются его полюса, т.е. чем больше диапазон его области значений.

В кластерном анализе определялась степень сходства или различия классов, а не то, чем конкретно сходны или отличаются. При выполнении когнитивной операции "содержательное сравнение" двух классов определяется вклад каждого атрибута в их сходство или различие. Результаты содержательного сравнения выводятся в наглядной графической форме когнитивных диаграмм, в которых изображаются информационные портреты классов с наиболее характерными и нехарактерными для них атрибутами и атрибуты разных классов соединяются линиями, цвет и толщина которых соответствуют величине и знаку вклада этих атрибутов в сходство или различие данных классов.

Результаты идентификации и прогнозирования, осуществленные с помощью модели, путем выполнения когнитивной операции "верификация" сопоставляются с опытом, после чего определяется выполнять ли когнитивную операцию "обучение", состоящую в том, что параметры модели могут изменяться количественно, и тогда мы имеем дело с адаптацией, или качественно, и тогда идет речь о переформировании модели.

Базовая когнитивная концепция в формальном изложении

1. Процесс познания начинается с чувственного восприятия. Различные органы восприятия дают качественно-различную чувственную информацию в форме дискретного потока элементов восприятия. Эти элементы формализуются с помощью описательных шкал и градаций.

2. В процессе накопления опыта выявляются взаимосвязи между элементами чувственного восприятия: одни элементы часто наблюдаются с другими (имеет место их пространственно-временная корреляция), другие же вместе встречаются достаточно редко. Существование устойчивых связей между элементами восприятия говорит о том, что они отражают некую реальность, интегральную по отношению к этим элементам. Эту реальность будем называть объектами восприятия. Рассматриваемые в единстве с объектами элементы восприятия будем называть признаками объектов. Таким образом, органы восприятия дают чувственную информацию о признаках наблюдаемых объектов, процессов и явлений окружающего мира (объектов). Чувственный образ конкретного объекта представляет собой систему, возникающую как результат процесса синтеза признаков этого объекта. В условиях усложненного восприятия синтез чувственного образа объекта может быть существенно замедленным и даже не завершаться в реальном времени.

3. Человек присваивает конкретным объектам названия (имена) и сравнивает объекты друг с другом. При сравнении выясняется, что одни объекты в различных степенях сходны по их признакам, а другие отличаются. Сходные объекты объединяются в обобщенные категории (классы), которым присваиваются имена, производные от имен входящих в категорию конкретных объектов. Классы формализуются с помощью классификационных шкал и градаций и обеспечивают интегральный способ описания действительности. Путем обобщения (синтеза, индукции) информации о признаках конкретных объектов, входящих в те или иные классы, формируются обобщенные образы классов. Накопление опыта и сравнение обобщенных образов классов друг с другом позволяет определить степень характерности признаков для классов, смысл признаков и ценность каждого признака для идентификации конкретных объектов с классами и сравнения классов, а также исключить наименее ценные признаки из дальнейшего анализа без существенного сокращения количества полезной информации о предметной области (абстрагирование). Абстрагирование позволяет существенно сократить затраты внутренних ресурсов системы на анализ информации. Идентификация представляет собой процесс узнавания, т.е. установление соответствия между чувственным описанием объекта, как совокупности дискретных признаков, и неделимым (целостным) именем класса, которое ассоциируется с местом и ролью воспринимаемого объекта в природе и обществе. Дискретное и целостное восприятие действительности поддерживаются, как правило, различными полушариями мозга: соответственно, правым и левым (доминантность полушарий). Таким образом, именно системное взаимодействие интегрального (целостного) и дискретного способов восприятия обеспечивает возможность установление содержательного смысла событий. При выполнении когнитивной операции "содержательное сравнение" двух классов определяется вклад каждого признака в их сходство или различие.

4. После идентификации уникальных объектов с классами возможна их классификация и присвоение обобщающих имен группам похожих классов. Для обозначения группы похожих классов используем понятие "кластер". Но и сами кластеры в результате выполнения когнитивной операции "генерация конструктов" могут быть классифицированы по степени сходства друг с другом. Для обозначения системы двух противоположных кластеров, со "спектром" промежуточных кластеров между ними, будем использовать термин "бинарный конструкт", при этом сами противоположные кластеры будем называть "полюса бинарного конструкта". Бинарные конструкты классов и атрибутов, т.е. конструкты с двумя полюсами, наиболее типичны для человека и представляет собой когнитивные структуры, играющие огромную роль в процессах познания. Достаточно сказать, что познание можно рассматривать как процесс генерации, совершенствования и применения конструктов. Качество конструкта тем выше, чем сильнее отличаются его полюса, т.е. чем больше диапазон его смысла.

Результаты идентификации и прогнозирования, осуществленные с помощью модели, путем выполнения когнитивной операции "верификация" сопоставляются с опытом, после чего определяется целесообразность выполнения когнитивной операции "обучение". При этом может возникнуть три основных варианта:

1. Объект, входит в обучающую выборку и достоверно идентифицируется (внутренняя валидность, в адаптации нет необходимости).

2. Объект, не входит в обучающую выборку, но входит в исходную генеральную совокупность, по отношению к которой эта выборка репрезентативна, и достоверно идентифицируется (внешняя валидность, добавление объекта к обучающей выборке и адаптация модели приводит к количественному уточнению смысла признаков и образов классов).

3. Объект не входит в исходную генеральную совокупность и идентифицируется недостоверно (внешняя валидность, добавление объекта к обучающей выборке и синтез модели приводит к качественному уточнению смысла признаков и образов классов, исходная генеральная совокупность расширяется).

1.1.2.1.4.3. Когнитивный конфигуратор и базовые когнитивные операции системного анализа

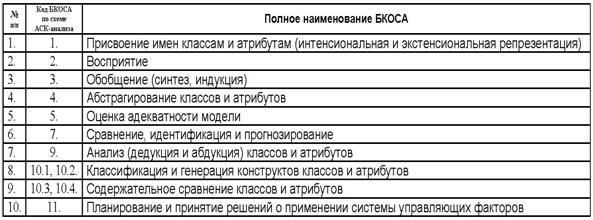

Таким образом, из предложенной когнитивной концепции вытекает существование, по крайней мере, 10 базовых когнитивных операций системного анализа (БКОСА) (таблица 1):

Таблица 1 – ОБОБЩЕННЫЙ СПИСОК БКОСА

(КОГНИТИВНЫЙ КОНФИГУРАТОР)

|

|

Необходимо отметить, что классификация операций системного анализа по В.М.Казиеву ближе всего к позиции, излагаемой в данной работе, т.к. этим автором названы 6 из 10 базовых когнитивных операций системного анализа: формализация; синтез (индукция); абстрагирование; анализ (дедукция); распознавание, и идентификация образов; классификация. Вместе с тем им не приводятся математическая модель, алгоритмы и инструментарий реализации этих операций и не ставится задача их разработки, кроме того, некоторые из них приведены дважды под разными названиями, например: анализ и синтез это тоже самое, что дедукция и индукция.

Необходимо также отметить, что по-видимому, впервые идея сведения мышления и процессов познания к когнитивным операциям была четко и осознанно письменно сформулирована в V веке до н.э.: "Сущность интеллекта проявляется в способностях обобщения, абстрагирования, сравнения и классификации" (цит.по пам., Патанжали, Йога-Сутра). Более того, все перечисленные Патанжали операции вошли в предлагаемый когнитивный конфигуратор.

Познание предметной области с одной стороны безусловно является фундаментом, на котором строится все грандиозное здание системного анализа, а с другой стороны, процессы познания являются связующим звеном, органично объединяющим "блоки" принципов и методов системного анализа в стройное здание. Более того, процессы познания буквально пронизывают все методы и принципы системного анализа, входя в них как один из самых существенных элементов.

Однако, на этом основании неверным будет

представлять, что когнитивные операции являются подмножеством понятия

"системный анализ", скорее наоборот: системный анализ представляет

собой один из теоретических методов познания, представимый в форме определенной

последовательности когнитивных операций, тогда как другие последовательности этих операций позволяют образовать

другие формы теоретического познания.

1.1.2.1.4.4. Задачи формализации базовых когнитивных операций системного анализа

Для решения задачи формализации БКОСА необходимо решить следующие задачи:

1. Выбор единой интерпретируемой численной меры для классов и атрибутов.

2. Выбор неметрической меры сходства объектов в семантических пространствах.

4. Определение идентификационной и прогностической ценности атрибутов.

5. Ортонормирование семантических пространств классов и атрибутов (Парето-оптимизация).

Выбор единой интерпретируемой численной меры для классов и атрибутов

При построении модели объекта управления одной из принципиальных проблем является выбор формализованного представления для индикаторов, критериев и факторов (далее: факторов). Эта проблема распадается на две подпроблемы:

1. Выбор и обоснование смысла выбранной численной меры.

2. Выбор математической формы и способа определения (процедуры, алгоритма) количественного выражения для значений, отражающих степень взаимосвязи факторов и будущих состояний АОУ.

Рассмотрим требования к численной мере, определяемые существом подпроблем. Эти требования вытекают из необходимости совершать с численными значениями факторов математические операции (сложение, вычитание, умножение и деление), что в свою очередь необходимо для построения полноценной математической модели.

Требование 1: из формулировки 1-й подпроблемы следует, что все факторы должны быть приведены к некоторой общей и универсальной для всех факторов единице измерения, имеющей какой-то смысл, причем смысл, поддающийся единой сопоставимой в пространстве и времени интерпретации.

Традиционно в специальной литературе [10] рассматриваются следующие смысловые значения для факторов: стоимость (выигрыш-проигрыш или прибыль-убытки); полезность; риск; корреляционная или причинно-следственная взаимосвязь. Иногда предлагается использовать безразмерные меры для факторов, например эластичность, однако, этот вариант не является вполне удовлетворительным, т.к. не позволяет придать факторам содержательный и сопоставимый смысл и получить содержательную интерпретацию выводов, полученных на основе математической модели.

Таким образом, возникает ключевая при выборе численной меры проблема выбора смысла, т.е. по сути единиц измерения, для индикаторов, критериев и факторов.

Требование 2: высокая степень адекватности предметной области.

Требование 3: высокая скорость сходимости при увеличении объема обучающей выборки.

Требование 4: высокая независимость от артефактов.

Что касается конкретной математической формы и процедуры определения числовых значений факторов в выбранных единицах измерения, то обычно применяется метод взвешивания экспертных оценок, при котором эксперты предлагают свои оценки, полученные как правило неформализованным путем. При этом сами эксперты также обычно ранжированы по степени их компетентности. Фактически при таком подходе числовые значения факторов является не определяемой, искомой, а исходной величиной. Иначе обстоит дело в факторном анализе, но в этом методе, опять же на основе экспертных оценок важности факторов, требуется предварительно, т.е. перед проведением исследования, принять решение о том, какие факторы исследовать (из-за жестких ограничений на размерность задачи в факторном анализе). Таким образом оба эти подхода реализуемы при относительно небольших размерностях задачи, что с точки зрения достижения целей настоящего исследования, является недостатком этих подходов.

Поэтому самостоятельной и одной из ключевых проблем является обоснованный и удачный выбор математической формы для численной меры индикаторов и факторов.

Эта математическая форма с одной стороны должна удовлетворять предыдущим требованиям, прежде всего требованию 1, а также должна быть процедурно вычислимой, измеримой.

Выбор неметрической меры сходства объектов в семантических пространствах

Существует большое количество мер сходства, из которых можно было бы упомянуть скалярное произведение, ковариацию, корреляцию, евклидово расстояние, расстояние Махалонобиса и др.

Проблема выбора меры сходства состоит в том, что при выбранной численной мере для координат классов и факторов она должна удовлетворять определенным критериям:

1. Обладать высокой степенью адекватности предметной области, т.е. высокой валидностью, при различных объемах выборки, как при очень малых, так и при средних и очень больших.

2. Иметь обоснованную, четкую, ясную и интуитивно понятную интерпретацию.

3. Быть нетрудоемкой в вычислительном отношении.

4. Обеспечивать корректное вычисление меры сходства для пространств с неортонормированным базисом.

5. Обеспечивать высокую достоверность и устойчивость идентификации при неполных (фрагментарных) и зашумленных данных.

Определение идентификационной и прогностической ценности атрибутов

Не все факторы имеют одинаковую ценность для решения задач идентификации, прогнозирования и управления. Традиционно считается, что факторы имеют одинаковую ценность только в тех случаях (обычно в психологии), когда определить их действительную ценность не представляется возможным по каким-либо причинам.

Для достижения целей, поставленных в данном исследовании, необходимо решить проблему определения ценности факторов, т.е. разработать математическую модель и алгоритм, которые допускают программную реализацию и обеспечивают на практике определение идентификационной и прогностической ценности факторов.

Ортонормирование семантических пространств классов и атрибутов (Парето-оптимизация)

Если не все факторы имеют одинаковую ценность для решения задач идентификации, прогнозирования и управления, то возникает проблема исключения из системы факторов тех из них, которые не представляют особой ценности.

Удаление малоценных факторов вполне оправданно и целесообразно, т.к. сбор и обработка информации по ним в среднем связана с такими же затратами времени, вычислительных и информационных ресурсов, как и при обработке ценных факторов. В этом состоит идея Парето-оптимизации.

Однако это удаление должно осуществляться при вполне определенных граничных условиях, характеризующих результирующую систему:

– адекватность модели;

– количество признаков на класс;

– суммарное количество градаций признаков в описательных шкалах.

В противном случае удаление факторов может отрицательно сказываться на качестве решения задач. На практике проблема реализации Парето-оптимизации состоит в том, что факторы вообще говоря коррелируют друг с другом и поэтому их ценность может изменяться при удалении любого из них, в том числе и наименее ценного. Поэтому просто взять и удалить наименее ценные факторы не представляется возможным и необходимо разработать корректный итерационный вычислительный алгоритм обеспечивающий решение этой проблемы при заданных граничных условиях.

1.1.2.1.5. Мышление как вычисление смысла и реализация операций со смыслом в инструментарии СК-анализа – системе "Эйдос"

В связи с ограниченностью объема данной работы нет возможности подробно рассмотреть вопросы, вынесенные в заголовок данного раздела. Но в этом и нет особой необходимости, т.к. такие вопросы как:

– системное обобщение семантической меры целесообразности информации как количественная мера знаний;

– способ представления и обобщения фактов в модели СК-анализа;

– способ вычисления смысла фактов и неклассическая логика;

– структуры данных базовых когнитивных операций;

– алгоритмы базовых когнитивных операций;

и ряд других, раскрывающих содержание математической модели, методики численных расчетов и технологии СК-анализа, подробно описаны в работе [64], размещенной на сайте автора: http://Lc.kubagro.ru.

1.1.2.1.7. Выводы

Системы искусственного интеллекта (СИИ) реализуют все больше функций, ранее выполнявшиеся только человеком, например, таких как: получение новых знаний из фактов, выявление причинно-следственных взаимосвязей между факторами, действующим на объект, и переходом этого объекта в те или иные состояния. Но в основе любой математической модели, реализованной в СИИ, всегда лежит некое представление о том, каким образом осуществляются аналогичные процессы человеком. Поэтому для разработчиков СИИ большой интерес представляет уточнение смыслового содержания и углубленный анализ таких базовых понятий, как данные – информация – знания, факт – смысл – мысль, мониторинг – анализ – управление. Один из возможных вариантов понимания этот терминов предлагается и обосновывается в данной работе в рамках предложенной и реализованной в СК-анализе когнитивной концепции.

1.1.2.2. Понятие: "Система искусственного интеллекта", место СИИ в классификации информационных систем

Существует много различных подходов к классификации информационных систем. Сразу вполне закономерно возникают вопросы о том:

1. Чем обусловлено различие этих классификаций?

2. Какова классификация этих классификаций?

3. Каким образом выбрать ту классификацию, которая нам больше всего подходит в данном случае?

Попробуем ответить на эти вопросы.

Различия между этими классификациями определяются теми критериями, по которым производится классификация, например:

– по степени структурированности решаемых задач;

– по автоматизируемым функциям;

– по степени автоматизации реализуемых функций;

– по сфере применения и характеру использования информации, в частности, по уровням управления.

Изветсно, что при обучении людей существуют различные уровни предметной обученности: воспроизведение (память); решение стандартных задач (умения, навыки); решение нестандартных, творческих задач (знания, активное интеллектуальное понимание).

Интеллект может проявляется в различных областях, но мы рассмотрим его возможности в решении задач, т.к. эта область проявления является типичной для интеллекта. Задачи бывают стандартные и нестандартные. Для стандартных задач известны алгоритмы решения. Для нестандартных они неизвестны. Поэтому решение нестандартной задачи представляет собой проблему.

Само понятие "стандартности" задачи относительно, относительна сама "неизвестность": т.е. алгоритм может быть известен одним и неизвестен другим, или информация о нем может быть недоступной в определенный момент или период времени, и доступной – в другой. Поэтому для одних задача может быть стандартной, а для других нет. Нахождение или разработка алгоритма решения переводит задачу из разряда нестандартных в стандартные.

В математике и кибернетике задача считается решенной, если известен алгоритм ее решения. Тогда процесс ее фактического решения превращается в рутинную работу, которую могут в точности выполнить человек, вычислительная машина или робот, под управлением программы реализующей данный алгоритм, не имеющие ни малейшего представления о смысле самой задачи.

Разработка алгоритма решения задачи связано с тонкими и сложными рассуждениями, требующими изобретательности, опыта, высокой квалификации. Считается, что эта работа является творческой, существенно неформализуемой и требует участия человека с его "естественным" опытом и интеллектом.

Здесь необходимо отметить, что существует технология решения изобретательских задач (ТРИЗ), в которой сделана попытка, по мнению многих специалистов, довольно успешная, позволяющая в какой-то степени формализовать процедуру решения творческих задач.

Интеллектуальными считаются задачи, связанные с разработкой

алгоритмов решения ранее нерешенных задач определенного типа.

Отличительной особенностью и одним из основных источников эффективности алгоритмов является то, что они сводят решение сложной задачи к определенной последовательности достаточно простых или даже элементарных для решения задач. В результате нерешаемая задача становится решаемой. Исходная информация поступает на вход алгоритма, на каждом шаге она преобразуется и в таком виде передается на следующий шаг, в результате чего на выходе алгоритма получается информация, представляющая собой решение задачи.

Алгоритм может быть исполнен такой системой, которая способна реализовать элементарные операции на различных шагах этого алгоритма.

Существует ряд задач, таких, как распознавание образов и идентификация, прогнозирование, принятие решений по управлению, для которых разбиение процесса поиска решения на отдельные элементарные шаги, а значит и разработка алгоритма, весьма затруднительны.

Из этих рассуждений вытекает следующее определение интеллекта: интеллект представляет собой универсальный алгоритма, способный разрабатывать алгоритмы решения конкретных задач.

С этой точки зрения профессия программиста является одной из самых творческих и интеллектуальных, т.к. продуктом деятельности программиста являются алгоритмы реализованные на некотором языке программирования (программы).

Исходя из вышесказанного можно сделать вывод о том, что в нашем случае наиболее подходит классификацией ИС, основанная на критерии, позволяющем оценить "степень интеллектуальности ИС", т.е. на критерии "степени структурированности решаемых задач" (рисунок 5).

|

|

|

Рисунок 5. Классификация информационных систем

|

Данная классификация не претендует на исчерпывающий характер.

Источники

информации:

1. Сотник С.Л. Конспект лекций по курсу "Основы проектирования систем искусственного интеллекта": (1997-1998), http://neuroschool.narod.ru/books/sotnik.html.

2. Сайт: http://www.stu.ru/inform/glaves/glava3/gl_3_2.htm#klas_is.

1.1.2.3. Определение и классификация систем искусственного интеллекта, цели и пути их создания

1.1.2.3.1. Тест Тьюринга и критерии "интеллектуальности" информационных систем. Может ли машина мыслить? Может ли искусственный интеллект превзойти своего создателя?

Вместо того, чтобы отвлеченно спорить о критериях, позволяющих отличить живое мыслящее существо от машины, выглядящей как живая и мыслящая, он предложил реализуемый на практике способ установить это.

Судья-человек ограниченное время, например, 5 минут, переписывается в чате (в оригинале – по телеграфу) на естественном языке с двумя собеседниками, один из которых – человек, а другой – компьютер. Если судья за предоставленное время не сможет надёжно определить, кто есть кто, то компьютер прошёл тест.

Предполагается, что каждый из собеседников стремится, чтобы человеком признали его. С целью сделать тест простым и универсальным, переписка сводится к обмену текстовыми сообщениями.

Переписка должна производиться через контролируемые промежутки времени, чтобы судья не мог делать заключения исходя из скорости ответов. (Тьюринг ввел это правило потому, что в его времена компьютеры реагировали гораздо медленнее человека. Сегодня же это правило необходимо, наоборот, потому что они реагируют гораздо быстрее, чем человек).

Идею Тьюринга поддержал Джо Вайзенбаум, написавший в 1966 году первую "беседующую" программу "Элиза". Программа всего в 200 строк лишь повторяла фразы собеседника в форме вопросов и составляла новые фразы из уже использованных в беседе слов. Тем ни менее этого оказалось достаточно, чтобы поразить воображение тысяч людей.

А.Тьюринг считал, что компьютеры в конечном счёте пройдут его тест, т.е. на вопрос: "Может ли машина мыслить?" он отвечал утвердительно, но в будущем времени: "Да, смогут!"

Алан Тьюринг был не только выдающимся ученым, но и настоящим пророком компьютерной эры. Достаточно сказать, что в 1950 году (!!!), когда он писал, что к 2000 году, на столе у миллионов людей будут стоять компьютеры, имеющие оперативную память 1 миллиард бит (около 119 Мб) и оказался в этом абсолютно прав. Когда он писал это, все компьютеры мира вместе взятые едва ли имели такую память. Он также предсказал, что обучение будет играть важную роль в создании мощных интеллектуальных систем, что сегодня совершенно очевидно для всех специалистов по СИИ. Вот его слова: "Пытаясь имитировать интеллект взрослого человека, мы вынуждены много размышлять о том процессе, в результате которого человеческий мозг достиг своего настоящего состояния… Почему бы нам вместо того, чтобы пытаться создать программу, имитирующую интеллект взрослого человека, не попытаться создать программу, которая имитировала бы интеллект ребенка? Ведь если интеллект ребенка получает соответствующее воспитание, он становится интеллектом взрослого человека… Наш расчет состоит в том, что устройство, ему подобное, может быть легко запрограммировано… Таким образом, мы расчленим нашу проблему на две части: на задачу построения "программы-ребенка" и задачу "воспитания" этой программы".

Именно

этот путь и используют практически все системы ИИ. Кроме того, именно на этом

пути появляются и другие признаки интеллектуальной деятельности: накопление

опыта, адаптация и т. д.

Против теста Тьюринга было выдвинуто несколько

возражений.

1. Машина, прошедшая тест, может не быть

разумной, а просто следовать какому-то хитроумному набору правил.

На что

Тьюринг не без юмора отвечал: "А откуда мы знаем, что человек, который

искренне считает, что он мыслит, на самом деле не следует какому-то хитроумному

набору правил?"

2. Машина может быть разумной и не умея

разговаривать, как человек, ведь и не все люди, которым мы не отказываем в

разумности, умеют писать.

Могут

быть разработаны варианты теста Тьюринга для неграмотных машин и судей.

3. Если тест Тьюринга и проверяет наличие

разума, то он не проверяет сознание

(consciousness) и свободу воли

(intentionality), тем самым не улавливая весьма существенных различий между

разумными людьми и разумными машинами.

Сегодня

уже существуют многочисленные варианты интеллектуальных систем, которые не

имеют цели, но имеют критерии поведения: генетические алгоритмы и имитационное

моделирование эволюции. Поведение этих систем выглядит таким образом, как будто

они имеют различные цели и добиваются их.

Ежегодно

производится соревнование между разговаривающими программами, и наиболее

человекоподобной, по мнению судей, присуждается приз Лебнера (Loebner).

Существует

также приз для программы, которая, по мнению судей, пройдёт тест Тьюринга. Этот

приз ещё ни разу не присуждался.

В

заключение отметим, что и сегодня тест Тьюринга не потерял своей

фундаментальности и актуальности, более того – приобрел новое звучание в связи

с возникновением Internet, общением людей в чатах и на форумах под условными

никами и появлением почтовых и других программ-роботов, которые рассылают спам

(некорректную навязчивую рекламу и другую невостребованную информацию),

взламывают пароли систем и пытаются выступать от имени их зарегистрированных

пользователей и совершают другие неправомерные действия.

Таким

образом, возникает задачи:

–

идентификации пола и других параметров собеседника (на эту возможность

применения своего теста указывал и сам Тьюринг);

–

выявления писем, написанных и посланных не людьми, а также такого автоматического

написания писем, чтобы отличить их от написанных людьми было невозможно. Так

что антиспамовый фильтр на электронной почте тоже представляет собой что-то

вроде теста Тьюринга.

Не

исключено, что скоро подобные проблемы (идентификации: человек или программа)

могут возникнуть и в чатах. Что мешает сделать сетевых роботов типа программы

"Элиза", но значительно более совершенных (все же сейчас не 1966, а

2004 год), которые будут сами регистрироваться в чатах и форумах участвовать в

них с использованием слов и модифицированных предложений других участников?

Простейший вариант – дублирование тем с других форумов и перенос их с форума на

форум без изменений, что мы уже иногда наблюдаем в Internet (например: сквозная

тема про "Чакра-муни").

На практике чтобы на входе системы определить, кто в нее входит, человек или робот, достаточно при входе предъявить для решения простенькую для человека, но требующую огромных вычислительных ресурсов и системы типа неокогнитрона Фукушимы, задачку распознавания случайных наборов символов, представленных в нестандартных начертаниях, масштабах и поворотах на фоне шума (Vladimir Maximenko). Решил, – значит стучится человек-пользователь, не решил, – значит на входе робот, лазающий по мировой сети с неизвестными, чаще всего неблаговидными целями.

Источники информации:

1. Свободная энциклопедия: http://ru.wikipedia.org/wiki/%D0%A2%D0%B5%D1%81%D1%82_%D0%A2%D1%8C%D1%8E%D1%80%D0%B8%D0%BD%D0%B3%D0%B0

2. Сотник С.Л. Конспект лекций по курсу "Основы

проектирования систем искусственного интеллекта": (1997-1998), http://neuroschool.narod.ru/books/sotnik.html.

3. Vladimir

Maximenko. Реализация теста Тьюринга на Perl (ввод цифр изображенных на

картинке) (perl image auth web cgi): http://www.opennet.ru/base/dev/turing_test.txt.html

4. Captcha (http://en.wikipedia.org/wiki/Captcha) – полностью автоматизированные

открытые тесты Тьюринга по разделению людей и машин (Completely Automated

Public Turing tests to tell Computers and Humans Apart).

5. Сайт: http://www.opennet.ru/opennews/art.shtml?num=4105

1.1.2.3.2. Классификация систем искусственного интеллекта

В данном учебном пособии мы будем рассматривать следующие классы систем искусственного интеллекта:

1. Системы с интеллектуальной обратной связью и интеллектуальными интерфейсами.

2. Автоматизированные системы распознавания образов.

3. Автоматизированные системы поддержки принятия решений

4. Экспертные системы (ЭС).

5. Нейронные сети.

6. Генетические алгоритмы и моделирование эволюции.

7. Когнитивное моделирование.

8. Выявление знаний из опыта (эмпирических фактов) и интеллектуальный анализ данных (data mining).

Этими классами системы СИИ не исчерпываются, но мы вынуждены ограничится ими, как основными, в связи с ограниченностью объема учебного пособия.

1.1.2.3.3. Особенности технологии создания систем искусственного интеллекта (обучение, "социализация", как технологический этап)

Система искусственного интеллекта в качестве существенной своей части включает базу знаний, которая является результатом обобщения опыта эксплуатации данной системы в определенных конкретных условиях. Это значит, что программистом может быть разработана только "пустая оболочка" системы искусственного интеллекта, которая превращается в работоспособную систему в результате процесса обучения, который, таким образом, является необходимым технологическим этапом создания подобных систем. Можно провести аналогию между такой системой и ребенком: ребенок не может идти работать, т.к. ему для этого предварительно требуется длительное обучение в школе, а затем часто и в вузе, чтобы он смог выполнять определенные виды работ.

1.1.2.4. Информационная модель деятельности специалиста и место систем искусственного интеллекта в этой деятельности

Информационная модель деятельности специалиста, представленная на рисунке 6, разработана на основе модели, впервые предложенной В.Н. Лаптевым (1984).

|

|

|

Рисунок 6. Информационная модель деятельности

специалиста |

На вход системы поступает задача или проблема. Толкование различия между ними также дано В.Н. Лаптевым и состоит в следующем.

Ситуация,

при которой фактическое состояние системы не совпадает с желаемым (целевым)

называется проблемной ситуацией и

представляет собой:

– задачу, если способ перевода системы из

фактического состояния в желаемое точно известен, и необходимо лишь применить

его;

– проблему, если способ

перевода системы из фактического состояния в желаемое не известен, и необходимо

сначала его разработать и лишь затем применить его.

Таким образом, можно считать, что проблема – это задача, способ решения которой неизвестен. Это означает, что если этот способ разработать, то этим самым проблема сводится к задаче, переводится в класс задач. Проще говоря, проблема – это сложная задача, а задача – это простая проблема.

Но и проблемы различаются по уровню сложности:

– для решения одних достаточно автоматизированной системы поддержки принятия решений;

– для решения других – обязательным является творческое участие людей: специалистов, экспертов.

Рассмотрим информационную модель деятельности специалиста, представленную на рисунке 6.

Блок 1. На вход системы поступает задача или проблема. Что именно неясно, т.к. чтобы это выяснить необходимо идентифицировать ситуацию и обратиться к базе данных стандартных решений с запросом, существует ли стандартное решение для данной ситуации.

Блок 2. Далее осуществляется идентификация проблемы или задачи и прогнозирование сложности ее решения. На этом этапе применяется интеллектуальная система, относящаяся к классу систем распознавания образов, идентификации и прогнозирования или эта функция реализуется специалистом самостоятельно "вручную".

Блок 3. Если в результате идентификации задачи или проблемы по ее признакам установлено, что точно имеется стандартное решение, то это означает, что на вход системы поступила точно такая же задача, как уже когда-то ранее встречалась. Для установления этого достаточно информационно-поисковой системы, осуществляющей поиск по точному совпадению параметров запроса и в применении интеллектуальных систем нет необходимости. Тогда происходит переход на блок 7, а иначе на блок 4.

Блок 4. Если установлено, что точно такой задачи не встречалось, но встречались сходные, аналогичные, которые могут быть найдены в результате обобщенного (нечеткого) поиска системой распознавания образов, то решение может быть найдено с помощью автоматизированной системы поддержки принятия решений путем решения обратной задачи прогнозирования. Это значит, что на вход системы поступила не задача, а проблема, имеющая количественную новизну по сравнению с решаемыми ранее (т.е. не очень сложная проблема). В этом случае осуществляется переход на блок 9, иначе – на блок 5.

Блок 5. Если установлено, что сходных проблем не встречалось, то необходимо качественно новое решение, поиск которого требует существенного творческого участия человека-эксперта. В этом случае происходит переход на блок 12, а иначе – на блок 6.

Блок 6. Переход на этот блок означает, что возможности поиска решения или выхода из проблемной ситуации системой исчерпаны и решения не найдено. В этом случае система обычно терпит ущерб целостности своей структуре и полноте функций, вплоть до разрушения и прекращения функционирования.

Блок 7. На этом этапе осуществляется реализация стандартного решения, соответствующего точно установленной задаче, а затем проверяется эффективность решения на блоке 8.

Блок 8. Если стандартное решение оказалось эффективным, это означает, что на этапах 2 и 3 идентификация задачи и способа решения осуществлены правильно и система может переходить к разрешению следующей проблемной ситуации (переход на блок 1). Если же стандартное решение оказалось неэффективным, то это означает, что проблемная ситуация идентифицирована как стандартная задача неверно и необходимо продолжить попытки ее разрешения с использованием более общих подходов, основанных на применении систем искусственного интеллекта (переход на блок 4), например, систем поддержки принятия решений.

Блок 9. Применяется автоматизированная система поддержки принятия решений, обеспечивающая решение обратной задачи прогнозирования. Отличие подобных систем от информационно-поисковых состоит в том, что они способны производить обобщение, выявлять силу и направление влияния различных факторов на поведение системы, и, на основе этого, по заданному целевому состоянию вырабатывать рекомендации по системе факторов, которые могли бы перевести систему в это состояние (обратная задача прогнозирования).

Блок 10. Если решение, полученное с помощью системы поддержки принятия решений, оказалось неэффективным, то это означает, что проблемная ситуация идентифицирована как аналогичная ранее встречавшимся неверно. Следовательно, что на вход системы поступила качественно новая, по сравнению с решаемыми ранее, т.е. сложная проблема. В этом случае необходимо продолжить попытки разрешения проблемы с использованием творческих неформализованных подходов с участием человека-эксперта и перейти на блок 5, иначе – на блок 11.

Блок 11. Информация об условиях и результатах решения проблемы заносится в базу знаний, т.е. стандартизируется. После чего база знаний количественно (не принципиально) изменяется, т.е. осуществляется ее адаптация. В результате адаптации при встрече в будущем точно таких же проблемных ситуаций, как разрешенная, система уже будет разрешать ее не как проблему, а как стандартную задачу.

Блок 12. На этом этапе с использованием неформализованных творческих подходов осуществляется поиск качественно нового решения проблемы, не встречавшейся ранее, после чего управление передается блоку 13.

Блок 13. Если решение, полученное экспертами с помощью неформализованных подходов, оказалось неэффективным, то это означает, что система терпит крах (осуществляется переход на блок 6). Если же адекватное решение найдено, то происходит переход на блок 14.

Блок 14. Стандартизация качественно нового решения, проблемы и пересинтез модели. Информация об условиях и результатах творческого решения проблемы заносится в базу знаний, т.е. стандартизируется. После этого база знаний качественно, принципиально изменяется, т.е. фактически осуществляется ее пересоздание (пересинтез). В результате пересинтеза базы знаний при встрече в будущем проблемных ситуаций, аналогичных разрешенной, система уже будет реагировать на них как проблемы, решаемые автоматизированными системами поддержки принятия решений.

Блоки, в которых используются системы искусственного интеллекта, на

рисунке 6 показаны затемненными:

– блоки 2 и 12:

система распознавания образов, идентификации и прогнозирования;

– блоки 9, 11, 12 и 14:

автоматизированная система поддержки принятия решений.

В заключение раздела, с целью повышения настроения читателей-студентов, приведем шуточный алгоритм решения проблем (рисунок 7).

|

|

|

Рисунок 7. Шуточный алгоритм решения проблем (Internet-фольклор) |

1.1.2.5. Жизненный цикл системы искусственного интеллекта и критерии перехода между этапами этого цикла

Жизненный цикл систем искусственного интеллекта сходен с жизненным циклом другого программного обеспечения и включает этапы и критерии перехода между ними, представленные в таблице 2.

Таблица 2 – ЭТАПЫ ЖИЗНЕННОГО ЦИКЛА СИСТЕМ ИСКУССТВЕННОГО ИНТЕЛЛЕКТА И КРИТЕРИИ ПЕРЕХОДА МЕЖДУ НИМИ

|

№ |

Наименование этапа |

Критерии перехода к следующему этапу |

|

1 |

Разработка идеи и концепции системы |

Появление (в результате проведения

маркетинговых и рекламных мероприятий) заказчика или спонсора, заинтересовавшегося

системой |

|

2 |

Разработка теоретических основ системы |

Обоснование выбора математической модели по

критериям или обоснование необходимости разработки новой модели |

|

3 |

Разработка математической модели системы |

Детальная разработка математической модели |

|

4 |

Разработка методики численных расчетов в

системе: |

|

|

4.1 |

– разработка структур данных |

детальная разработка структур входных,

промежуточных и выходных данных |

|

4.2 |

– разработка алгоритмов обработки данных |

разработка обобщенных и детальных

алгоритмов, реализующих на разработанных структурах данных математическую

модель |

|

5 |

Разработка структуры системы и экранных

форм интерфейса |

Разработка иерархической системы управления

системой, структуры меню, экранных форм и средств управления на экранных

формах |

|

6 |

Разработка программной реализации системы |

Разработка исходного текста программы

системы, его компиляция и линковка. Исправление синтаксических ошибок в исходных

текстах |

|

7 |

Отладка системы |

Поиск и исправление логических ошибок в

исходных текстах на контрольных примерах. На контрольных примерах новые

ошибки не обнаруживаются. |

|

8 |

Экспериментальная эксплуатация |

Поиск и исправление логических ошибок в

исходных текстах на реальных данных без применения результатов работы системы

на практике. На реальных данных новые ошибки практически не обнаруживаются,

но считаются в принципе возможными. |

|

9 |

Опытная эксплуатация |

Поиск и исправление логических ошибок в

исходных текстах на реальных данных с применением результатов работы системы

на практике. На реальных данных новые ошибки не обнаруживаются и считаются

недопустимыми. |

|

10 |

Промышленная эксплуатация |

Основной по длительности период, который

продолжается до тех пор, пока система функционально устраивает Заказчика. У

Заказчика появляется необходимость внесения количественных (косметических)

изменений в систему на уровне п.5 (т.е. без изменения математической модели,

структур данных и алгоритмов) |

|

11 |

Заказные модификации системы |

У Заказчика формируется потребность

внесения качественных (принципиальных) изменений в систему на уровне п.3 и

п.4, т.е. с изменениями в математической модели, структурах данных и

алгоритмах |

|

12 |

Разработка новых версий системы |

Выясняется техническая невозможность или

финансовая нецелесообразность разработки новых версий системы |

|

13 |

Снятие системы с эксплуатации |

|

Контрольные вопросы

1. Данные, информация, знания. Системно-когнитивный анализ как развитие концепции смысла Шенка-Абельсона.

2. Когнитивная концепция СК-анализа и синтез когнитивного конфигуратора.

3. Мышление как вычисление смысла и реализация операций со смыслом в инструментарии СК-анализа - системе "Эйдос".

4. Понятие: "Система искусственного интеллекта", место СИИ в классификации информационных систем.

5. Определение и классификация систем искусственного интеллекта, цели и пути их создания.

6. Тест Тьюринга и критерии "интеллектуальности" информационных систем. Может ли машина мыслить? Может ли искусственный интеллект превзойти своего создателя?

7. Классификация систем искусственного интеллекта.

8. Особенности технологии создания систем искусственного интеллекта (обучение, "социализация", как технологический этап).

9. Информационная модель деятельности специалиста и место систем искусственного интеллекта в этой деятельности.

10. Жизненный цикл системы искусственного интеллекта и критерии перехода между этапами этого цикла.

Рекомендуемая литература

1. Луценко Е.В. Теоретические основы и технология адаптивного семантического анализа в поддержке принятия решений (на примере универсальной автоматизированной системы распознавания образов "ЭЙДОС-5.1"). - Краснодар: КЮИ МВД РФ, 1996. – 280с.

2. Луценко Е. В. Автоматизированный системно-когнитивный анализ в управлении активными объектами (системная теория информации и ее применение в исследовании экономических, социально-психологических, технологических и организационно-технических систем): Монография (научное издание). – Краснодар: КубГАУ. 2002. – 605 с.

3. Кива Владимир, сайт: http://vlak.webzone.ru/rus/it/knowledge.html.