3.1. ТЕОРЕТИЧЕСКИЕ ОСНОВЫ СИСТЕМНОЙ ТЕОРИИ ИНФОРМАЦИИ

3.1.1. Требования к математической модели и численной мере

Требования к математической модели:

Содержательная интерпретируемость; эффективная вычислимость на основе эмпирических данных (наличие эффективного численного метода); универсальность; адекватность; сходимость; семантическая устойчивость; сопоставимость результатов моделирования в пространстве и времени; непараметричность; формализация базовых когнитивных операций системного анализа (прежде всего таких, как обобщение, абстрагирование, сравнение классификация и др.); корректность работы на фрагментарных, неточных и зашумленных данных; возможность обработки данных очень больших размерностей (тысячи факторов и будущих состояний объекта управления); математическая и алгоритмическая ясность и простота, эффективная программная реализуемость.

Требования к численной мере:

Ключевым при построении математических моделей является выбор количественной меры, обеспечивающей учет степени причинно-следственной взаимосвязи исследуемых параметров.

Эта мера должна удовлетворять следующим требованиям:

1) обеспечивать эффективную вычислимость на основе эмпирических данных,

полученных непосредственно из опыта;

2) обладать универсальностью, т.е. независимостью от предметной

области;

3) подчиняться единому для различных предметных областей принципу содержательной интерпретации

4) количественно измеряться в единых единицах измерения а количественной

шкале (шкала с естественным нулем, максимумом или минимумом);

5) учитывать понятия:

– "цели объекта управления", "цели управления";

– "мощность множества будущих состояний объекта управления";

– уровень системности объекта управления;

– степень детерминированности объекта управления;

6) обладать сопоставимостью в пространстве и во времени;

7) обеспечивать возможность введения метрики или не метрической функции

принадлежности на базе выбранной количественной меры.

Для того, чтобы выбрать тип модели, удовлетворяющей сформулированным требованиям, необходимо решить на какой форме информации эта модель будет основана: абсолютной, относительной или аналитической.

3.1.2. Выбор базовой численной меры

Абсолютная, относительная и аналитическая информация.

Широко известны абсолютная и относительная формы информации. Абсолютная форма – это просто количество, частота. Относительная форма – это доли, проценты, относительные частоты и вероятности.

Менее знакомы специалисты с

аналитической формой информации, примером которой является условные

вероятности, стандартизированные статистические значения и количество

информации.

Абсолютная информация – это информация содержащаяся в абсолютных числах, таких как количество чего-либо, взятого "само по себе", т.е. безотносительно к объему совокупности, к которой оно относится.

Относительная информация – это информация, содержащаяся в отношениях абсолютного количества к объему совокупности. Относительная информация измеряется в частях, процентах, промиле, вероятностях и некоторых других подобных единицах. Очевидно, что и из относительной информации, взятой изолированно, вырванной из контекста, делать какие-либо обоснованные выводы не представляется возможным. Те, кто иногда делает это сознательно, просто вводит в заблуждение некомпетентных слушателей.

Для того, чтобы о чем-то судить по процентам, нужен их сопоставительный анализ, т.е. анализ всего процентного распределения. Вариантов такого анализа может быть много, но суть не в этом, а в том, что такой анализ необходим. Рассмотрим один из возможных вариантов сопоставительного анализа процентных распределений на нашем примере. Этот вариант предполагает использование в качестве "базы оценки" среднего по всей совокупности (нормативный подход: норма – среднее).

Аналитическая (сопоставительная) информация – это информация, содержащаяся в отношении вероятности (или процента) к некоторой базовой величине, например к средней вероятности по всей выборке. Аналитическими являются также стандартизированные величины в статистике и количество информации в теории информации.

Очевидно, именно аналитическая информация является наиболее кондиционной для употребления с той точки зрения, что позволяет непосредственно делать содержательные выводы об исследуемой предметной области (точнее будет сказать, что она сама и является выводом), тогда как для того, чтобы сделать аналогичные выводы на основе относительной, и особенно абсолютной информации требуется ее значительная предварительная обработка. Эта "предварительная обработка" и составляет значительную долю трудоемкости труда аналитиков и экспертов, которые полагаются во многом на чисто качественную (невербализуемую, интуитивную) оценку имеющейся у них сырой относительной информации, однако проводить необходимые для этого расчеты для реальных объемов данных вручную не представляется возможным.

Для экономических исследований является естественным манипулировать понятиями "прибыль" – "убыток" или сходными понятиями теории игр: "выигрыш" – "проигрыш", измеряя их при этом, как правило, в денежных единицах.

Однако, на этом пути возникает ряд проблем:

1. Проблема выбора денежных единиц или сопоставимого во времени и пространстве способа их измерения.

2. Принципиальная проблема, состоящая в том, что не все явления, даже в экономике, уместно и целесообразно количественно оценивать (измерять) в денежных единицах.

В данной работе автор предлагает не решать эти проблемы, а обойти их, выбрав в качестве количественной меры не "стоимость", а то, что лежит в основе стоимости. Для этого предлагается раскрыть один из аспектов сущности понятия "стоимость" на основе применения аналитического понятия "информация", которое удовлетворяет всем сформулированным выше требованиям к количественной мере.

Труд, как информационный процесс. Средства труда, как информационные системы

Информационно-функциональная теория развития техники разработана автором в 1980 году (ДСП) [152]. С позиций этой теории труд представляет собой прежде всего информационный процесс, средства труда являются информационными системами, передающими и усиливающими информационные потоки между человеком и внешней средой.

Взаимодействие человека со средствами труда приводит не только к созданию определенного материального продукта труда, но и к изменению самого человека. Уровень сознания человека во многом детерминируется функциональным уровнем средств труда, с помощью которых он трудится.

Труд (процесс опредмечивания) с позиций теории информации предлагается рассматривать как процесс

перезаписи информации из образа продукта труда в структуру физической среды

(предмета труда). По мере осуществления этого процесса физическая форма

продукта труда за счет записи в ней информации структурируется и выделяется из

окружающей среды. Тело человека и средства труда выступают при этом как канал

передачи информации.

Таким

образом сам процесс передачи информации по каналу связи и запись ее в носитель

информации – это и есть тот процесс (труд), который преобразует носитель информации

в заранее заданную форму, т.е. в продукт труда.

Очевидно образ продукта труда и сам продукт труда относятся к качественно различным уровням Реальности на которых тождественная по содержанию (семантике) информация просто физически не может находится в одной и той же языковой, синтаксической форме. Поэтому тело человека и его средства труда как информационный канал, соединяющий качественно различные уровни Реальности, не просто передает информацию с сохранением ее содержания с одного уровня на другой, но при этом с необходимостью преобразует и языковую форму представления информации, т.е. осуществляет ее компиляцию, которая фактически и представляет собой технологический процесс.

Информация образа продукта труда, проявляющаяся первоначально в форме целесообразной и целенаправленной трудовой деятельности, т.е. как свободная информация, преобразуется затем в форму связанной информации, выступающей как покоящиеся полезные свойства продукта труда, определяемые его физической формой и структурой [49].

Свободная информация, существующая в форме целесообразности процесса труда не имеет стоимости, но образует ее в той мере, в какой преобразуется в информацию, связанную в структуре физической формы продукта труда. При этом смысл (содержание, семантика, качество) информации связанной в продукте труда определяет его потребительскую стоимость, тогда как ее количество связано с абстрактной себестоимостью продукта.

Время, за которое перезаписывается определенное количество информации из образа продукта труда в его физическую структуру определяется информационной пропускной способностью тела человека и его средств труда как информационного канала. Чем это время меньше, т.е. чем выше информационная пропускная способность тела человека и его средств труда, тем выше развитие человека и технологии. Так как процесс труда это сознательный процесс, то и количественные и содержательные возможности человека как информационного канала определяются типом и состоянием его сознания. Процесс увеличения информационной пропускной способности сознания человека поддерживается (обеспечивается, сопровождается) соответствующими психофизиологическими изменениями в теле человека.

Роль человека и его средств труда в процессе перезаписи информации из образа продукта труда в структуру его физической формы и в создании потребительной стоимости и стоимости продукта труда различна. Это различие определяется тем, что в процессе труда человек выполняет лишь ту часть работы по созданию определенного продукта труда, которая заключается в выполнении функций еще не переданных его средствам труда. Та же часть работы, которая состоит в выполнении уже полностью переданных средствам труда функций выполняется ими автоматически, т.е. без участия человека (рисунок 3.1):

|

|

|

Рисунок 3. 1. Упрощенная схема информационного канала |

Информационно-функциональная теория развития техники:

включает, в частности, следующие положения. Каждая трудовая функция реализует определенный этап преобразования формы информации и ее передачи из образа продукта труда в предмет труда. Процесс развития средств труда состоит в последовательной (т.е. в единственном и строго определенном порядке) передаче им трудовых функций, ранее выполнявшихся человеком (закон последовательной передачи функций), при этом технологический базис общества, экономические и социальные отношения изменяются количественно. Переданные средствам труда функции реализуются вне биологических ограничений человека (остаются только ограничения технологии), а оставшиеся у человека функции – вне ограничений, связанных с необходимостью выполнения переданных функций. После передачи средствам труда всех трудовых функций физического организма человека им начинают передаваться психические функции (закон повышения качества базиса), при этом технологический базис общества, экономические и социальные отношения изменяются качественно. В рамках этой теории получены обобщенные информационно-функциональные схемы 15 типов уже существующих и перспективных средств труда.

Процесс передачи и записи информации, как управляющее воздействие, преобразующее предмет труда в продукт труда

Наиболее развитой формой труда на текущем этапе технологического развития, по-видимому, является АСУ. Поэтому для развития представлений об информационной природе процесса труда рассмотрим глубокую аналогию между каналом передачи информации и процессом управления в АСУ.

Варианты структур каналов передачи информации

Канал передачи информации состоит из линии связи, модулятора и демодулятора, кодирующего и декодирующего, а также решающих устройств, позволяющих с высокой степенью достоверности принять и передать сообщение [351].

Для увеличения надежности передачи применяются также каналы обратной связи и решающие устройства. Последние служат для классификации сомнительных сигналов и отождествления их с достаточно высокой степенью достоверности с состояниями источника информации или с определенным кодом (рисунок 3.2).

|

|

Информационная модель канала передачи информации и аналогия со структурой АСУ

Следуя [9] кратко рассмотрим классическую функциональную схему АСУ (рисунок 3.3), на которой показаны основные элементы управляющего устройства (УУ).

|

|

АСУ состоит из двух основных частей: объекта управления и управляющего устройства. Объектом управления может быть любое управляемое техническое устройство или какой–либо технологический процесс.

Состояние объекта управления зависит от приложенных к нему воздействий g(t) и от собственных параметров, поэтому характеризуется выходной величиной y(t).

Воздействие g(t), поступающее на вход управляющего устройства и содержащее информацию о требуемом значении y(t), называется задающим воздействием.

Воздействие z(t), поступающее от управляющего устройства на вход объекта для обеспечения в нем желаемого процесса, называется управляющим воздействием.

Воздействие f(t), приложенное к объекту и вызывающее отклонение управляемого параметра от заданного значения, называется возмущающим воздействием (помехой).

Задающее воздействие g(t), которое является входным сигналом АСУ и определяет требуемый закон изменения выходного сигнала y(t), поступает на чувствительный элемент (ЧЭ). Кроме того на этот элемент подаются сигналы обратной связи y(t) и возмущающего воздействия f(t).

С выхода ЧЭ сигнал x(t), который является функцией воздействия {x, y, f} и характеризует ошибку (рассогласование) АСУ, усиливается усилителем (У) и поступает на исполнительный механизм (ИМ).

ИМ вырабатывает и подает на объект управления (ОУ) управляющее воздействие z(t).

Иногда при формировании управляющего воздействия кроме сигнала ошибки учитываются его производная и интеграл.

Часто для обеспечения требуемых статических и динамических характеристик системы используются корректирующие устройства: последовательные (КУ1) и параллельные (КУ2).

В состав АСУ могут входить еще и специальные элементы для согласования отдельных частей системы, а также вычислительные устройства для реализации алгоритма работы управляющего устройства.

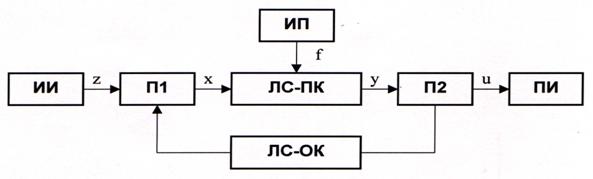

Обобщив варианты структур каналов передачи информации, представленные на рисунке 3.1, получим следующую обобщенную информационную модель канала передачи информации (рисунок 3.4):

|

|

|

Рисунок 3. 4. Обобщенная информационная модель |

Источник информации ИИ создает сигналы z, которые после кодирования и модуляции в преобразователе П1 превращаются в сигналы x и поступают в линию связи ЛС. Для удобства сигналы источника будем называть сообщениями, а сигналы x в линии связи просто сигналами. В результате действия помех f сигнал y на приемной стороне может отличаться от сигнала x. Помехи имеют случайный характер и подчиняются статистическим законам. Фактически источником помех является окружающая среда, имеющая сложную структуру, но на практике удобно считать, что помехи создаются некоторым источником помех ИП с определенными статистическими свойствами и поступают в линию связи в виде сигнала f. Приемная часть канала содержит преобразователь П2, демодулирующий и декодирующий принятые сигналы y, и приемник информации ПИ, перерабатывающий принятые сообщения u.

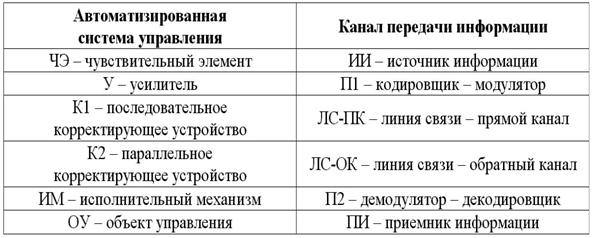

Сравним две информационные системы: канал передачи информации и автоматизированную систему управления, проанализируем, чем они сходны и чем отличаются друг от друга.

Сравнивая функциональную схему АСУ на рисунке 3.3 и обобщенную информационную модель канала передачи информации на рисунке 3.4 и мы видим, что с формальной точки зрения у них есть очень много общего как по структуре, так и по функциям (таблица 3.1).

|

|

Кроме того, обе эти системы прежде всего представляют собой информационные системы, т.е. предназначены для вполне определенных целей, которые достигаются путем передачи и записи информации. Таким образом, именно информация переводит эти системы из нефункционального состояния в функциональное, повышает их уровень системности.

Различие между каналом передачи информации и АСУ состоит в различии их целей, т.е. в том, ради чего в них передается информация:

– в канале информация передается для

сообщения приемнику;

– в АСУ информация передается для изменения

структуры и функций объекта управления.

Необходимо дополнительно отметить, что любой приемник информации при получении информации изменяет свою структуру, а иногда и функции, но в теории связи этот факт не играет особой роли и ему не уделяется особого внимания. Однако в теории и практике автоматизированного управления именно это обстоятельство выступает на первый план, так как именно ради изменения состояния объекта управления на него и оказывается информационное управляющее воздействие.

Интересно, что врач-психотерапевт что-то говорит пациенту (гипнотику) вовсе не ради того, чтобы сообщить ему некоторую информацию, а чтобы вылечить его, т.е. перевести из болезненного состояния в здоровое. Учитель также воздействует на ученика не столько ради сообщения ему некоторой информации, хотя этот момент и присутствует, сколько ради того, чтобы научить его учиться, т.е. изменить его. Программист также далек от того, чтобы сообщать компьютеру некоторую информацию, просто он разрабатывает программную систему, т.е. сначала создает, а затем изменяет некоторый информационный объект, который с его точки зрения безусловно представляет собой объект управления ничуть не в меньшей степени, чем кувшин, формирующийся из глины, под руками гончара с точки зрения последнего. Да и кувшин формируется из глины, собственно говоря, по мере того, как информация образа кувшина перезаписывается через руки гончара в глину, представляющую собой не что иное, как приемник и носитель информации.

Эти глубокие аналогии могут быть развиты и продолжены, если исследовать роль обратных связей, с одной стороны, для повышения помехоустойчивости канала передачи информации, а с другой, – для управления в автоматизированных системах управления.

Помехоустойчивость передачи и приема информации

Повышение помехоустойчивости является одной из наиболее важных задач передачи информации. Оно обеспечивается за счет введения определенной избыточности, т.е. увеличения объема сигнала. Это возможно, если скорость передачи информации по каналу это позволяет.

Применяются следующие методы повышения помехоустойчивости:

1. Увеличение мощности сигнала для увеличения отношения сигнал/шум.

2. Применение помехоустойчивого кодирования, т.е. введение дополнительных символов в код передаваемого сообщения. Эти символы позволяют на приемной стороне обнаружить и исправить ошибки. Введение дополнительных символов увеличивает время передачи сообщения и/или частоту передачи символов.

3. Применение помехоустойчивых видов модуляции.

4. Применение помехоустойчивых методов приема (фильтрации).

5. Применение каналов с обратной связью.

Остановимся на последнем методе подробнее.

Если имеется дополнительный канал связи между источником и приемником информации, то его можно использовать как канал обратной связи, по которому от приемника к источнику может передаваться для контроля достоверности приема:

– весь объем полученной информации;

– только информация об элементах сообщения, достоверность которых сомнительна и которые требуется повторить.

Системы передачи первого типа называются системами с информационной обратной связью, а второго типа – с решающей обратной связью.

В системах с решающей обратной связью на приемной стороне должно быть интеллектуальное решающее устройство, обеспечивающее оценку степени достоверности принимаемой информации: если уверенность в достоверности высока, то обратный сигнал не посылается, если же уверенность недостаточна, то делается запрос на повторную передачу.

Работа такой системы напоминает телефонный разговор, в котором слушающий переспрашивает слова или фразы, которые он из-за плохой слышимости не смог распознать. Это означает, что система декодирования в общем случае является системой распознавания и решающее устройство в канале передаче информации с решающей обратной связью по сути дела должно быть системой распознавания образов.

Интерпретация задачи выработки управляющего воздействия в АСУ как обратной задачи декодирования теории информации и обратной задачи распознавания образов

Теория систем связи является областью науки, в которой первоначально возникла, а затем в основном и развивалась теория информации. В другие области науки теория информация проникла исторически позже и не получила в них столь мощного развития. Тем не менее и это дало очень плодотворные и интересные результаты [1, 11, 26, 66, 90, 221, 330, 331 и др.].

По мнению автора, существующие глубокие аналогии между каналом передачи информации и автоматизированной системой управления, с одной стороны, а также между процессом декодирования передаваемого сигнала в канале передаче информации и процессом распознавания образов, с другой, позволяют обоснованно надеяться на то, что эти аналогии могут быть с успехом продолжены и что на этом пути могут быть получены новые интересные для теории и практики АСУ результаты.

С позиций теории информации объект управления естественным образом может рассматриваться как канал связи (включая приемник информации), на вход которого подается определенная информация в форме входных параметров. Входная информация преобразует состояние объекта управления, т.е переводит его из начального состояния в конечное, характеризующееся определенными выходными параметрами. Таким образом, на выходе объекта управления входная информация приобретает форму выходных параметров.

Канал связи считается идеальным, если на его выходе фиксируются те же параметры, что и на входе. Поэтому в теории связи ставится задача создания каналов связи, обеспечивающих формирование выходных параметров, тождественных входным. Если рассматривать объект управления как канал связи, то очевидно, что он далек от идеального с точки зрения теории информации, так как преобразует входные параметры в выходные по сложным, более того, до конца не известным законам.

Формирование на выходе объекта управления определенных заранее заданных параметров можно считать преобразованием этого объекта из исходного состояния, характеризующегося набором входных параметров, в целевое состояние, которое осуществлено путем подачи на его вход определенной информации (управляющего воздействия).

Поэтому в теории автоматизированного управления ставится иная задача: зная с определенной точностью закономерности преобразования входных параметров в выходные разработать и подать на вход объекта управления (канала связи) такие входные параметры, которые обеспечивают получение на его выходе заранее заданных выходных параметров.

Идеальный канал связи не искажает входной информации, т.е. выходные параметры не отличаются от входных. В шумящем канале связи связь выходных параметров с входными носит сложный и неоднозначный характер, определяемый статистическими характеристиками шума. Важнейшим разделом теории информации является теория построения кодов, позволяющих обнаруживать и исправлять ошибки, возникающие из–за шума в канале связи. Эти коды имеют определенные возможности, т.е. могут, например, гарантировать абсолютную достоверность восстановления переданного с искажением слова при однократной ошибке. Однако, когда количество ошибок превышает помехоустойчивость кода, он выдает произвольные (случайные) результаты декодирования, что является совершенно неприемлемым.

Поиск методов построения систем интеллектуального декодирования, обеспечивающих устойчивую работу при очень большом количестве ошибок в канале связи путем учета как статистики различных видов ошибок, так и их динамики, приводит к идее применения для этих целей алгоритмов распознавания образов.

Следовательно, в наиболее общей постановке задача декодирования с исправлением ошибок может трактоваться как задача распознавания образов, так как процесс декодирования по сути дела сводится к идентификации, т.е. определению класса, к которому относится принятое слово.

Системы распознавания тесно связаны с системами принятия решений, так как распознавание есть не что иное, как принятие решения о принадлежности распознаваемого объекта к определенному классу [251].

С позиций теории АСУ объект управления преобразует входные параметры в выходные не случайным образом, а в соответствии со своей функциональной структурой. Аналитически это преобразование задается моделью, которая является аналитическим выражением (формулой), детерминистским образом связывающей выходные параметры с входными. Для простых объектов управления достаточно знать их модель, чтобы по целевым выходным параметрам определить задающее их управление. Это означает, что простые детерминистские объекты управления можно рассматривать как каналы связи без помех.

Для сложных объектов управления связь выходных параметров с входными имеет более сложный статистический характер, чем у детерминистских объектов. Кроме того на эту связь влияют параметры, значения которых являются неопределенными. Тем не менее, эта связь, безусловно, существует. Это означает, что сложный объект управления можно рассматривать как зашумленный информационный канал, на вход которого действуют управляемые параметры, влияние среды и неизвестных параметров рассматривается как шум, а на выходе формируются выходные параметры.

В постановке теории информации данная, т.е. первая, задача управления по параметрам формулируется следующим образом: "Определить, какую информацию необходимо подать на вход объекта управления (т.е. какими должны быть его входные параметры), чтобы получить на его выходе заранее заданную выходную информацию (выходные параметры)".

Однако в случае сложного объекта управления его состояние не сводится к значениям выходных параметров. Поэтому необходимо предварительно решить вторую задачу, т.е. исходя из того, что целевые состояния объекта управления известны, определить приоритетные выходные параметры, играющие основную роль в детерминации этих состояний.

Кроме того, сама связь выходных и входных параметров у сложных объектов управления имеет сложный и динамичный характер, который не может быть адекватно описан статической детерминистской аналитической моделью. Вместе с тем применение обучающейся системы распознавания образов обеспечивает решение и этой третьей задачи, т.е. построение и адаптацию динамичной информационной модели объекта управления и в том случае, когда он является сложной системой.

С позиций теории информации все эти три задачи относятся к обратным задачам декодирования. Для систем распознавания образов, формирующих обобщенные образы классов распознавания, это стандартная операция, не представляющая проблемы.

Предложено рассматривать сложный объект управления как зашумленный информационный канал, на вход которого действуют управляемые параметры, влияние среды рассматривается как шум, а на выходе формируются выходные параметры.

Обоснован важный в теоретическом отношении вывод о том, что принятие решения об управляющем воздействии представляет собой решение обратной задачи декодирования теории информации, или в общем случае – обратной задачи распознавания образов. Иначе говоря: процесс труда по сути дела представляет собой процесс управления, – это информационный процесс, обратный процессу познания.

Информационная теория стоимости. Связь количества (синтаксиса) и качества (содержания, семантики) информации с меновой и потребительной стоимостью

Информация записанная в структуре продукта труда непосредственно человеком создает и потребительную, и меновую стоимость. Информация же записанная в структуре продукта средствами труда, т.е. без участия человека, автоматически, не увеличивает стоимость этого продукта, хотя и создает его потребительную стоимость.

При этом совершенно неважно, каким образом записана эта информация в самих средствах труда: непосредственно человеком или также с помощью средств труда. Неважно также записана эта информация непосредственно в механической или другой консервативной структуре средств труда жестко один раз и навсегда, или в некотором мобильном устройстве памяти с возможностью его перепрограммирования (как в компьютерах, на гибких автоматизированных линиях и роботизированных комплексах).

Напротив информация стертая в средстве труда в процессе создания данного продукта (износ средства труда) переноситься на него и увеличивает его стоимость, хотя и не создает никакой потребительной стоимости. Но в процессе труда информация в средстве труда может не только стираться, но и накапливаться: это происходит, например, в интеллектуальных автоматизированных системах, как обучающихся с учителем, так и самообучающихся (поэтому их называют генераторами информации). В этом случае стоимость средств труда в процессе их использования не уменьшается, а возрастает, и стоимость продукта, созданного с их помощью соответственно уменьшается, а не увеличивается.

Итак, потребительная стоимость продукта труда определяется КАЧЕСТВОМ (смыслом, содержанием) связанной информации, записанной в физической форме и структуре того продукта непосредственно человеком или его средствами труда.

Абстрактная себестоимость продукта труда определяется алгебраической суммой КОЛИЧЕСТВА связанной информации, записанной в структуре физической формы продукта труда человеком и КОЛИЧЕСТВА связанной информации стертой или записанной в структуре физической формы средств труда в процессе производства данного продукта, причем последняя берется со знаком "+", если она стерта (износ средств труда), и со знаком "-", если она записана (генерация информации).

Производительность человеческого труда тем выше, чем большее количество функций тела человека передано его средствам труда, а также чем выше степень использования функциональных возможностей этих средств труда человеком. Чем выше производительность труда, тем большая доля информации записывается в продукте труда средствами труда автоматически, т.е. без участия человека. Таким образом, в конечном счете производительность труда определяется прежде всего уровнем развития сознания человека.

|

|

|

Рисунок 3. 5. Схема образования потребительной стоимости и стоимости в процессе труда с позиций информационной теории стоимости |

В отличие от производительности труда изменение его интенсивности не влияет на функциональный уровень технологии, а значит и на соотношение между количеством информации, записанной в продукт труда человеком и средствами труда. Поэтому только уменьшение рабочего времени, необходимого на производство данного продукта, достигнутое за счет увеличения производительности человеческого труда уменьшает абстрактную себестоимость этого продукта и может служить адекватной мерой изменения этой себестоимости. Так гениальные произведения искусства, содержащие колоссальную информацию, записанную в них непосредственно человеком-творцом практически без использования средств труда, всегда будут иметь наивысшую стоимость, значительно превосходящую стоимость самых качественных репродукций.

До сих пор мы использовали термин и понятие "время" без его специального анализа и определения в каком-то обыденно-экономическом значении. Теперь же основываясь на общности основных законов информационных взаимодействий проведем аналогию (а может быть и больше чем аналогию) между "временем физическим", "психофизиологическим" и "экономическим", естественно, насколько это возможно в рамках данной работы.

Из физики известно, что редукция виртуального объекта происходит при сообщении ему энергии, необходимой для образования его массы покоя. Очевидно, редуцируемый объект представляет собой канал взаимодействия классического и виртуального уровней Реальности и этот канал обеспечивает передачу энергии с первого уровня на второй. Однако для возникновения структуры редуцированной формы объекта одной энергии явно недостаточно: для этого необходима также и информация об этой структуре. Эта информация существовала еще до редукции на виртуальном уровне строения редуцируемого объекта и была передана по тому же каналу, но в направлении обратном энергетическому потоку.

Таким образом в физике виртуальная сущность объекта выступает как источник информации, сам объект как информационно-энергетический канал взаимодействия виртуального и редуцированного уровней Реальности, а редуцированная форма объекта - как носитель информации, изменяющий свою структуру по мере записи соответствующей информации в структуре среды.

Чем выше уровень развития (сложность) объекта, тем более отдаленные друг от друга качественно различные уровни Реальности он соединяет как информационно-энергетический канал, тем выше пропускная способность (мощность) этого канала, тем большее разнообразие форм энергии и языковых форм представления информации он обеспечивает, и, наконец тем выше информационная емкость его формы, т.е. тем большее количество информации может быть записано в структуре его формы до момента начала повышения ее энтропии.

Здесь уместным является пример с магнитофонной лентой на которую мы пытаемся записать как можно больше информации на единицу длины путем уменьшения скорости протяжки. Если при постоянном информационном потоке записи эту скорость уменьшать линейно, то первоначально плотность информации будет возрастать также практически линейно (а энтропия соответственно уменьшаться), однако скоро мы заметим, что плотность информации стала возрастать медленнее, т.к. возросли шумы (уменьшилось отношение сигнал/шум). Если продолжать и дальше уменьшать скорость протяжки, то конце концов это приведет к тому, что качественный записывающий сигнал будет восприниматься лентой практически как стирающий, т.е. на нее будет записываться один шум.

Таким образом можно сделать по крайней мере

следующие выводы:

Процесс труда можно рассматривать как

процесс редукции образа продукта труда в структуре физической среды, что

становится непосредственно очевидным при достижении ментального типа сознания;

Человеческая душа с ее неисчерпаемым

творческим потенциалом является единственным источником всякой собственности и

стоимости в этом мире. Поэтому даже в чисто экономическом, в общем-то

достаточно "приземленном" смысле, нет ничего более ценного в мире,

чем человеческая душа.

Примечание: Согласно теории "Естественного права" (Сократ, Платон, Фома Аквинский) наиболее глубоким источником права является природа самого человека. Одним из основных правовых отношений является отношение собственности. На этом основании автор выдвигает (в качестве гипотезы, конечно) "Естественную теорию собственности":

1. Человеческая Душа

является единственным и наиболее глубоким источником всех форм собственности и

их фундаментом;

2. В зависимости от формы сознания человеческая душа отождествляет себя с различными "телами проявления" и, таким образом, возникает первая производная форма собственности: - собственность на свое тело и право на жизнь (при физической форме сознания - это собственность на физическое тело и физическую жизнь);

3. Из "Естественного

права" собственности на свое тело возникает право собственности на все,

что произведено непосредственно и исключительно с применением своего тела: прежде

всего сам живой (собственный) труд, средства и продукты труда (физического и

"умственного");

4. Право собственности на свой труд и средства труда приводят к праву собственности на продукты своего труда, произведенные с использованием собственных средств труда, а также к отсутствию права собственности на продукты труда, произведенные с использованием чужих средств труда (наемный труд).

Темп

времени является величиной индивидуальной для каждого объекта и определяется

мощностью информационно-энергетического канала, связывающего физическую форму

объекта с его более глубокими структурными уровнями.

Информация, как товар

В

эпоху господства капитала полагали, что "чистым товаром" является

золото. Однако, если проанализировать те свойства золота, которые

превратили его в основной эквивалент стоимости, то с очевидностью обнаружится,

что это именно те свойства, из-за которых золото является идеальным носителем

информации (информация легко "записывается" в золото, т.к. оно

достаточно мягкое; информация долго сохраняется в золоте, т.к. оно не ржавеет,

не является хрупким, не подвержено другим формам "порчи", т.е.

стирания). Известно, что "стоимость" является не физическим свойством

той или иной вещи, стоимость - это свойство вещи, которое приписывают ей люди,

которые вступают посредством нее в определенные экономические отношения друг с

другом. В действительности же все отношения людей друг с другом являются информационными.

Золото, как эквивалент стоимости, также является лишь "информационным

пакетом", несущим определенное количество информации, соответствующее его

весу. Исходя из всех этих рассуждений и учитывая информационную теорию

стоимости, основные положения которой были сформулированы выше, являясь свидетелями

информационного общества, победившего в развитых странах, мы можем

предположить, что единственным "чистым товаром" является (а по

существу всегда и являлась) только информация.

Информация

является квинтэссенцией стоимости

Кратко рассмотрим вопрос о стоимости самой информации, имеющий самое непосредственное отношение к проблеме оценки экономической эффективности применения систем интеллектуальной обработки данных.

Мы знаем, как информация, в качестве рекламы, приносит деньги. Мы знаем также, что технология, "Ноу-хау", стоит значительно дороже, чем продукты ее применения.

Информация, как и нефть, может быть "сырой" или обработанной. Сырая информация может почти ничего не стоить по сравнению со стоимостью аналитически обработанной информации, т.е. информации, которая находится в форме пригодной для употребления, готовой немедленно принести громадные преимущества ее обладателю по сравнению с другими людьми, ею не обладающими.

Стоимость и амортизация интеллектуальных систем и баз знаний

Любая программная система представляет собой виртуальное средство труда работающее на базе универсального компьютера. Эти информационные средства труда, так же как и обычные "физические", могут быть предназначены либо для непосредственного потребления пользователем (группа "Б"), или для создания других подобных средств труда ("группа "А").

Вопрос о стоимости программных систем - это вопрос о стоимости средств труда, начисто лишенных своего "физического тела". В их создание вложен громадный высококвалифицированный труд, наукоемкие технологии, но тиражируются такие средства очень просто - путем перезаписи на магнитный носитель. Это своего рода "психосинтез", и если бы нечто аналогичное стало возможным с физическими объектами, то наступил бы настоящий "золотой век", по крайней мере в плане материальном (гибкие роботизированные комплексы уже приближают их к этому). Следовательно, в соответствии с информационной теорией стоимости программные продукты имеют высокую потребительную стоимость и практически никакой меновой стоимости. Меновая стоимость программных продуктов определяется практически затратами на поиск места, где они уже есть, и на доставку потребителю. С появлением Internet практически решены вопросы и поиска, и доставки программного обеспечения и других "информационных товаров".

Чтобы повысить меновую стоимость программных систем их разработчики стараются затруднить их так называемое "свободное тиражирование" или попросту говоря - воровство, вводя необходимость инсталляции и "привязывая" систему к конкретному компьютеру (имеются также другие способы). Но, во-первых, против этого также есть свои средства, а во-вторых, такая привязка снижает функциональную ценность программной системы, т.к. делает ее более уязвимой при технических авариях, модернизации компьютера и т.п., что в общем делает ее менее удобной для пользователя.

Что касается износа программных систем, этих "нематериальных активов", то физический износ у них вообще отсутствует, а моральный может быть весьма значительным: после появления новой версии программного продукта - старой уже никто не хочет пользоваться (хотя иногда появляется "сырая" и "не очень работающая" новая версия, а старая - хорошо отработана и идеально выполняет свои функции). Итак, с появлением новой версии старая может "в один момент" потерять всю свою стоимость (в том числе и балансовую - в результате переоценки).

Иначе обстоит дело с базами данных и интеллектуальными системами, которые накапливают и структурируют информацию, обрабатывают ее по более или менее сложным алгоритмам, в результате чего их стоимость непрерывно возрастает. Стоимость баз данных, находящихся на банковском сервере, может в десятки миллионов раз превышать стоимость самого компьютера и в процессе работы это соотношение все больше увеличивается в пользу информации. Естественно, такую ценную информацию необходимо защищать, чтобы даже если сервер будет похищен, злоумышленники не смогли извлечь из него ни одно бита интересующей их информации.

Источники экономической эффективности АСУ и систем интеллектуальной обработки данных с позиций теории информации

Информация, содержащаяся в системе, непосредственно связана с энтропией этой системы (обратно пропорционально), а та, в свою очередь, – с количеством энергии в системе (пропорционально). Таким образом, информация имеет энергетический эквивалент. В принципе возможна формула, связывающая количество информации с количеством энергии, наподобие знаменитой формулы Альберта Эйнштейна E=mc2.

При сообщении некоторой системе определенного количества информации ее энтропия уменьшается, что приводит к выделению или экономии энергии (охлаждению системы). Например, при внедрении системы оперативного управления процессом уборки зерновых в масштабах одного района Краснодарского края в 1983-1988 годах за счет повышения ровня системной организации объекта управления экономилось топлива на сумму около 400 тысяч рублей. Автором данной работы эти мысли высказывались в предложенной им информационной теории стоимости еще в 1979 году. В последние годы подобные мысли высказываются и рядом других авторов [132].

Вывод о выборе в качестве базовой численной меры количества информации

Аналитическая информация измеряется в БИТах или других единицах измерения информации, а также может быть безразмерной (однако во втором случае она сложнее поддается содержательной интерпретации).

Таким

образом, в качестве количественной меры взаимосвязи факторов и будущих

состояний АОУ целесообразно использовать количество информации.

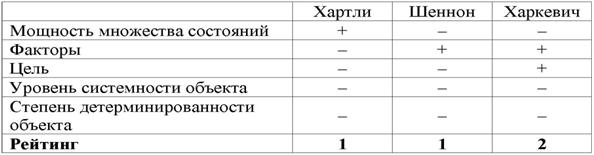

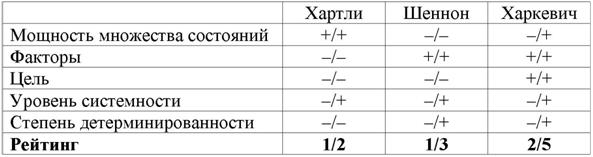

Однако, известно много различных информационных мер и, следовательно, возникает задача выбора одной из них, оптимальной по выбранным критериям. Различные выражения классической теории информации для количества информации: Хартли, Шеннона и Харкевича учитывают различные аспекты информационного моделирования объектов (таблице 3.2):

|

Таблица 3. 2 – СООТВЕТСТВИЕ ТРЕБОВАНИЯМ |

|

|

– формула Хартли учитывает количество классов (мощность множества состояний объекта управления) но никак не учитывает их признаков или факторов, переводящих объект в эти состояния, т.е. содержит интегральное описание объектов;

– формула Шеннона основывается на учете признаков, т.е. основывается на дискретном описании объектов;

– формула Харкевича учитывает понятие цели и также как формула Шеннона основана на статистике признаков, но не учитывает мощности множества будущих состояний объекта управления, включающего целевые и другие будущие состояния объекта управления и также как формула Шеннона основывается на дискретном описании объектов.

Как видно из таблицы 3.2, классическая формула Харкевича по учитываемым критериям имеет преимущества перед классическими формулами Хартли и Шеннона, т.к. учитывает как факторы, так и понятие цели. Поэтому именно выражение для семантической целесообразности информации Харкевича взято за основу при выводе обобщающего выражения, удовлетворяющего всем предъявляемым требованиям.

3.1.3. Конструирование системной численной меры на основе базовой

Системное обобщение формулы Хартли для количества информации.

Классическая формула Хартли имеет вид:

|

|

Будем искать ее системное обобщение в виде:

|

|

где:

W – количество чистых (классических) состояний системы.

j – коэффициент

эмерджентности Хартли (уровень системной организации объекта, имеющего W чистых

состояний);

Учитывая, что возможны смешанные

состояния, являющиеся нелинейной суперпозицией или одновременной реализацией

чистых (классических) состояний "из W по m", всего возможно ![]() состояний системы, являющихся сочетаниями классических

состояний. Таким образом, примем за аксиому, что системное

обобщение формулы Хартли имеет вид [153, 366]:

состояний системы, являющихся сочетаниями классических

состояний. Таким образом, примем за аксиому, что системное

обобщение формулы Хартли имеет вид [153, 366]:

|

|

Так как ![]() , то при M=1 выражение (3.3) приобретает вид (3.1), т.е.

выполняется принцип соответствия,

являющийся обязательным для более общей теории.

, то при M=1 выражение (3.3) приобретает вид (3.1), т.е.

выполняется принцип соответствия,

являющийся обязательным для более общей теории.

Рассмотрим подробнее смысл выражения (3.3), представив сумму в виде

ряда слагаемых:

|

|

Первое слагаемое в (3.4) дает количество информации по классической

формуле Хартли, а остальные слагаемые – дополнительное

количество информации, получаемое за счет системного эффекта, т.е. за счет

наличия у системы иерархической структуры или смешанных состояний. По сути дела эта дополнительная информация

является информацией об иерархической структуре системы, как состоящей из ряда

подсистем различных уровней сложности.

Например, пусть система состоит из W

пронумерованных элементов 1-го уровня иерархии. Тогда на 2-м уровне иерархии

элементы соединены в подсистемы из 2 элементов 1-го уровня, на 3-м – из 3, и

т.д. Если выборка любого элемента равновероятна, то из факта выбора n-го

элемента по классической формуле Хартли мы получаем количество информации

согласно (3.1). Если же при этом известно, что

данный элемент входит в определенную подсистему 2-го уровня, то это дает

дополнительное количество информации, за счет учета второго слагаемого, поэтому

общее количество получаемой при этом информации будет определяться выражением

(3.4) уже с двумя слагаемыми (M=2). Если элемент одновременно входит в M

подсистем разных уровней, то количество информации, получаемое о системе и ее

подсистемах при выборке этого элемента определяется выражением (3.4). Так, если

мы вытаскиваем кирпич из неструктурированной кучи, состоящей из 32 кирпичей, то

получаем 5 бит информации, если же из этих кирпичей сложен дом, то при

аналогичном действии мы получаем дополнительное количество информации о том, из

какой части дома (подсистемы) вытащен этот кирпич. Действия каменщика, укладывающего

кирпич на место, предусмотренное проектом, значительно выше по

целесообразности, чем у грузчика, складывающего кирпичи в кучу.

Учитывая, что при M=W:

|

|

в этом случае получаем:

|

|

Выражение (3.5) дает оценку

максимального количества информации, которое может содержаться в элементе

системы с учетом его вхождения в различные подсистемы ее иерархической

структуры.

Однако реально в любой системе осуществляются не все формально

возможные сочетания элементов 1-го уровня иерархии, т.к. существуют различные правила

запрета, различные для разных

систем. Это означает, что возможно множество различных систем, состоящих из

одинакового количества тождественных элементов, и отличающихся своей

структурой, т.е. строением подсистем различных иерархических уровней. Эти

различия систем как раз и возникают благодаря различию действующих для них этих

правил запрета. По этой причине систему

правил запрета предлагается назвать информационным

проектом системы. Различные системы, состоящие из равного количества

одинаковых элементов (например, дома, состоящие из 20000 кирпичей), отличаются

друг от друга именно по причине различия своих информационных проектов.

Из выражения (3.5) очевидно, что I быстро стремится к W:

|

|

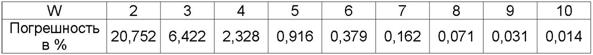

В действительности уже при W>4 погрешность выражения (3.5) не

превышает 1% (таблица 3.3):

|

Таблица 3. 3 – ЗАВИСИМОСТЬ ПОГРЕШНОСТИ |

|

|

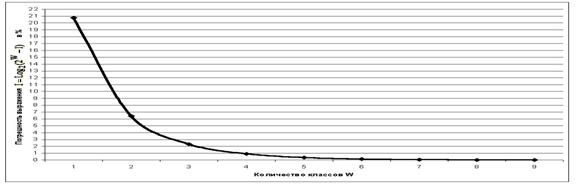

График зависимости погрешности выражения (3.5) от количества классов W приведен на рисунке 3.6:

|

|

|

Рисунок 3. 6. Зависимость погрешности приближенного выражения системного обобщения формулы Хартли от количества классов W |

Приравняв правые части выражений (3.2) и (3.3):

получим выражение для коэффициента эмерджентности Хартли:

|

|

Непосредственно

из вида выражения для коэффициента эмерджентности Хартли (3.9) ясно, что он

представляет собой относительное превышение количества информации о системе при

учете системных эффектов (смешанных состояний, иерархической структуры ее

подсистем и т.п.) над количеством информации без учета системности, т.е. этот коэффициент отражает уровень

системности объекта.

С учетом выражения (3.9) выражение (3.2) примет вид:

|

|

или при M=W и больших W, учитывая (3.4 – 3.6):

Выражение (3.10) и представляет собой искомое системное обобщение классической формулы Хартли, а выражение (3.11) – его достаточно хорошее приближение при большом количестве элементов или состояний системы (W).

Таким образом, коэффициент эмерджентности Хартли отражает уровень системности объекта и изменяется от 1 (системность минимальна, т.е. отсутствует) до W/Log2W (системность максимальна). Очевидно, для каждого количества элементов системы существует свой максимальный уровень системности, который никогда реально не достигается из-за действия правил запрета на реализацию в системе ряда подсистем различных уровней иерархии.

Например: из 32 букв русского

алфавита может быть образовано не ![]() осмысленных

6-буквенных слов, а значительно меньше. Если мы услышим одно из этих в принципе

возможных слов, то получим не 5´6=30 информации,

содержащейся непосредственно в буквах (в одной букве содержится Log232=5

бит), а 30+19,79=49,79 бит, т.е. в 1.66 раз больше. Это и есть уровень системности иерархического уровня 6-буквенных

слов русского языка. Уровень системности русского языка, как системы, состоящей

из слов длиной от одной до 6 букв, согласно выражения (3.9) с учетом (3.5),

равен примерно 6,4.

осмысленных

6-буквенных слов, а значительно меньше. Если мы услышим одно из этих в принципе

возможных слов, то получим не 5´6=30 информации,

содержащейся непосредственно в буквах (в одной букве содержится Log232=5

бит), а 30+19,79=49,79 бит, т.е. в 1.66 раз больше. Это и есть уровень системности иерархического уровня 6-буквенных

слов русского языка. Уровень системности русского языка, как системы, состоящей

из слов длиной от одной до 6 букв, согласно выражения (3.9) с учетом (3.5),

равен примерно 6,4.

Аналогично и в генах, этих "символах генома", содержится

значительно больше информации о фенотипе, чем предполагается в классической

генетике Менделя, т.к. они образуют ансамбли различных уровней иерархии в

зависимости от влияния среды и технологий управления (адаптивность системы

"генотип-среда", Драгавцев В.А., 1993).

На уровне слов верхняя оценка уровня системности русского языка с

учетом (3.5) составляет огромную величину: 2616,48 (предполагается, что в

русском языке 40000 слов и предложения могут иметь любую длину). Необходимо

отметить, что правила запрета на порядок слов в русском языке значительно

слабее, чем, например в английском, поэтому возможно гораздо больше

грамматически правильных и несущих различную информацию предложений из одних и

тех же слов. Это значит, что уровень системности русского языка на уровне

предложений, по-видимому, значительно превосходит уровень системности английского

языка. При длине предложения до 2-х слов системность русского языка на уровне

предложений согласно (3.9) составляет: 52330916.

Анализ выражения (3.9) показывает, что при М=1 оно преобразуется в (3.1), т.е. выполняется принцип соответствия. При М>1 количество информации в соответствии с системной теорией информации (СТИ) (3.9) будет превосходить количество информации, рассчитанное по классической теории информации (КТИ) (3.1). Непосредственно из выражения (3.2) получаем:

Первое слагаемое в выражении (3.12) отражает количество информации, согласно КТИ, а второе – СТИ, т.е. доля системной информации.

Представляет несомненный интерес исследование закономерностей изменения доли системной информации в поведении элемента системы в зависимости от количества классов W и сложности смешанных состояний M.

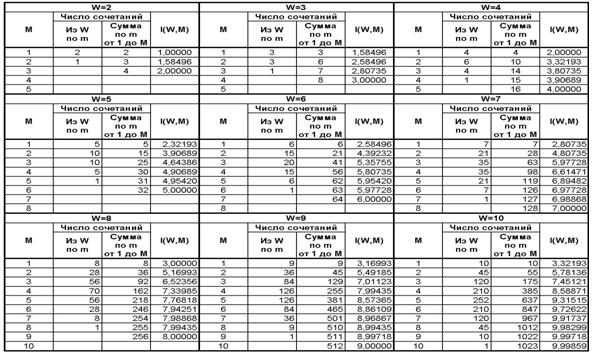

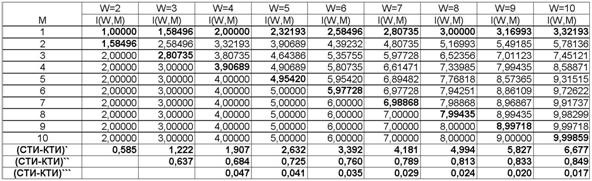

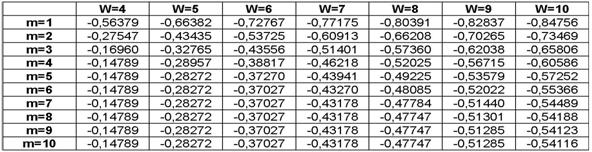

В таблице 3.4 приведены результаты численных расчетов в соответствии с выражением (3.9):

|

Таблица 3. 4 – ЗАВИСИМОСТЬ I(W,M) ОТ КОЛИЧЕСТВА КЛАССОВ W |

|

|

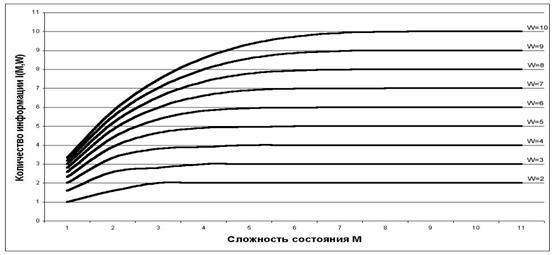

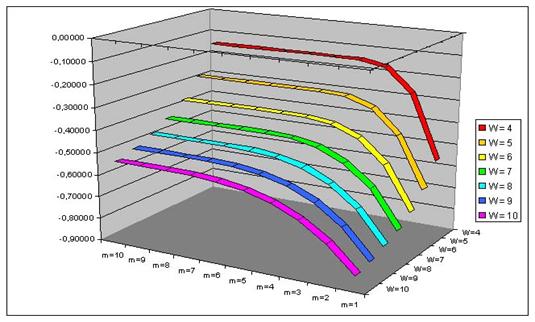

Сводные данные из таблицы 3.4 приведены в таблице 3.5, а в графическом виде они представлены на рисунке 3.7.

|

Таблица 3. 5 – ЗАВИСИМОСТЬ КОЛИЧЕСТВА ИНФОРМАЦИИ I(W,M) |

|

|

|

|

|

Рисунок 3. 7.

Зависимость количества информации I(W,M) |

Рост количества информации в СТИ по сравнению с КТИ обусловлен системным эффектом (эмерджентностью), который связан с учетом смешанных состояний, возникающих путем одновременной реализации нескольких чистых (классических) состояний. Выражение (3.9) дает максимальную возможную оценку количества информации, т.к. могут существовать различные правила запрета на реализацию тех или иных смешанных состояний.

Фактически это означает, что в СТИ множество

возможных состояний объекта рассматривается не как совокупность несвязанных

друг с другом состояний, как в КТИ, а как система,

уровень системности которой как раз и определяется коэффициентом эмерджентности

Хартли j

(3.9), являющегося монотонно возрастающей функцией сложности смешанных состояний

M. Следовательно, дополнительная

информация, которую мы получаем из поведения объекта в СТИ, по сути дела является

информацией о системе всех возможных состояний объекта, элементом

которой является объект в некотором данном состоянии.

Закон возрастания эмерджентности и следствия из него.

Численные расчеты и аналитические выкладки в

соответствии с СТИ показывают, что при возрастании количества элементов в

системе доля системной информации в поведении ее элементов возрастает. Это

обнаруженное нами новое фундаментальное свойство систем предлагается назвать

законом возрастания эмерджентности.

Закон возрастания эмерджентности: чем

больше элементов в системе, тем большую долю от всей содержащейся в ней

информации составляет системная информация.

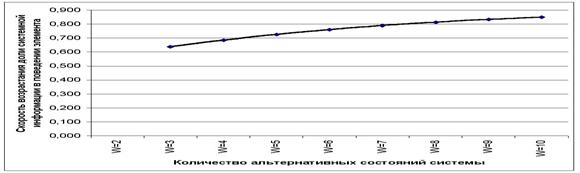

На рисунках 3.8 и 3.9 приведены графики скорости и ускорения возрастания эмерджентности в зависимости от количества элементов в системе.

|

|

|

Рисунок 3. 8. Возрастание доли системной информации в поведении элемента системы при увеличении количества элементов W |

Более детальный анализ закона возрастания эмерджентности с использованием конечных разностей первого и второго порядка (таблица 3.5) показывает, что при увеличении количества элементов в системе доля системной информации в ней возрастает с ускорением, которое постепенно уменьшается. Это утверждение будем называть леммой 1.

|

|

|

Рисунок 3. 9. Ускорение возрастания доли системной информации в поведении элемента системы от количества элементов W |

Продолжим анализ закона возрастания эмерджентности. Учитывая, что:

|

|

|

выражение (3.3) принимает вид:

|

|

где: 1<=М<=W.

|

|

|

и учитывая, что Log21=0, выражение (3.13) приобретает вид:

|

|

Введем обозначения:

|

|

С учетом (3.14) выражение (3.9) для коэффициента эмердентности Хартли

приобретает вид:

|

|

|

Заменяя в (3.13) факториал на Гамма-функцию, получаем обобщение

выражения (3.3) на непрерывный случай:

|

|

|

Или окончательно:

|

|

Для непрерывного случая

обозначения (3.15) принимают вид:

|

|

Учитывая выражения (3.9) и (3.16) получим выражение для коэффициента эмерджентности Хартли для непрерывного случая:

|

|

|

И окончательно для непрерывного случая:

|

|

(3. 18) |

Анализируя выражения (3.14)

и (3.16) видим, что количество информации, получаемое при выборке из системы

некоторого ее элемента, состоит из двух слагаемых:

1) зависящего только от

количества элементов в системе: W (первое слагаемое);

2) зависящего как от

количества элементов в системе W, так и от максимальной сложности подсистем: M

(второе слагаемое).

Этот результат позволяет

высказать гипотезы "О природе

сложности системы" и "О видах системной информации":

– сложность системы

определяется количеством содержащейся в ней информации;

– системная информация

включает две составляющих: зависящее от количества элементов системы и

зависящее также от характера взаимосвязей между элементами.

Изучим какой относительный

вклад вносит каждое слагаемое в общее количество информации системы в

зависимости от числа элементов в системе W и сложности подсистем M. Результаты

численных расчетов отношения IW/IMW для различных

значений W и M приведены в таблице 3.6 и на рисунке 3.10:

|

|

|

|

|

Рисунок 3. 10. Относительный вклад видов

информации IMW/IW |

Анализ таблицы 3.6 и рисунка 3.10 показывает, что чем выше уровень системности, тем большая доля информации системы

содержится во взаимосвязях ее элементов, и чем меньше элементов с системе, тем

быстрее возрастает доля информации, содержащейся во взаимосвязях элементов при

возрастании уровня системности. Эти

утверждения будем рассматривать как леммы 2 и 3.

Таким образом полная

формулировка закона возрастания эмерджентности с гипотезой о видах информации в

системе и тремя леммами приобретает вид:

ЗАКОН ВОЗРАСТАНИЯ ЭМЕРДЖЕНОСТИ: чем больше элементов в

системе, тем большую долю от всей содержащейся в ней информации составляет

системная информация.

Гипотеза 1: "О природе сложности системы": сложность системы

определяется количеством содержащейся в ней информации.

Гипотеза 2: "О видах системной информации": системная информация

включает две составляющих:

– зависящее от количества

элементов системы;

– зависящее также от

характера взаимосвязей между элементами.

Лемма-1: при увеличении количества

элементов в системе доля системной информации в ней возрастает с ускорением,

которое постепенно уменьшается.

Лемма-2: чем выше уровень

системности, тем большая доля информации системы содержится во взаимосвязях ее

элементов.

Лемма-3: чем меньше элементов в

системе, тем быстрее возрастает доля информации, содержащейся во взаимосвязях

элементов при возрастании уровня

системности.

Системное обобщение классической формулы Харкевича для количества информации

Это

обобщение представляет большой интерес, в связи с тем, что А.Харкевич впервые ввел в теорию информации понятие цели. Он

считал, что количество информации, сообщенное объекту, можно измерять по

изменению вероятности достижения цели этим объектом за счет использования им

этой информации.

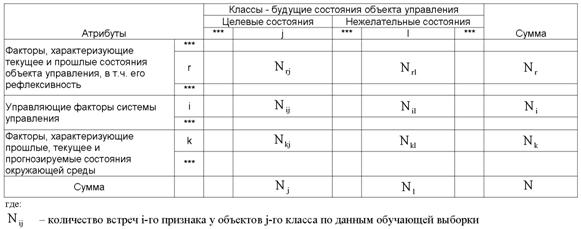

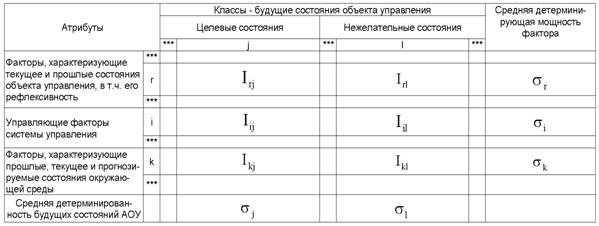

Рассмотрим таблицу 3.7, в которой столбцы соответствуют будущим состояниям АОУ (целевым и нежелательным), а строки факторам, характеризующим объект управления, управляющую систему и окружающую среду.

|

Таблица 3. 7 – МАТРИЦА АБСОЛЮТНЫХ ЧАСТОТ |

|

|

Классическая формула А.Харкевича имеет вид:

где:

Pij – вероятность достижения объектом управления j-й цели при условии сообщения ему i-й информации;

Pj – вероятность самопроизвольного достижения объектом управления j-й цели.

Однако: А.Харкевич в своем выражении для количества информации не ввел зависимости количества информации, от мощности пространства будущих состояний объекта управления, в т.ч. от количества его целевых состояний. Вместе с тем, один из возможных вариантов учета количества будущих состояний объекта управления обеспечивается классической и системной формулами Хартли (3.1) и (3.9); выражение (3.19) при подстановке в него реальных численных значений вероятностей Pij и Pj не дает количества информации в битах; для выражения (3.19) не выполняется принцип соответствия, считающийся обязательным для обобщающих теорий. Возможно, в этом состоит одна из причин слабого взаимодействия между классической теорией информации Шеннона и семантической теорией информации.

Чтобы снять эти вопросы, приближенно выразим вероятности Pij, Pi и Pj через частоты:

|

|

Подставим в выражение (3.19) значения для Pij и Pj из (3.20):

Введем коэффициент эмерджентности Y в модифицированную формулу А.Харкевича:

|

|

где: Y – коэффициент эмерджентности Харкевича (ак будет показано выше, он определяет степень детерминированности объекта с уровнем системной организации j, имеющего W чистых состояний, на переходы в которые оказывают влияние A факторов, о чем в модели накоплено N фактов).

Известно, что классическая формула Шеннона

для количества информации для неравновероятных событий преобразуется в формулу

Хартли при условии, что события равновероятны, т.е. удовлетворяет фундаментальному

принципу соответствия [338].

Естественно потребовать, чтобы и обобщенная формула Харкевича также удовлетворяла аналогичному принципу соответствия, т.е. преобразовывалась в формулу Хартли в предельном случае, когда каждому классу (состоянию объекта) соответствует один признак (фактор), и каждому признаку – один класс, и эти классы (а, значит и признаки), равновероятны. В этом предельном случае отпадает необходимость двухвекторного описания объектов, при котором 1-й вектор (классификационный) содержит интегральное описание объекта, как принадлежащего к определенным классам, а 2-й вектор (описательный) – дискретное его описание, как имеющего определенные атрибуты. Соответственно, двухвекторная модель, предложенная в данной работе, преобразуется в "вырожденный" частный случай – стандартную статистическую модель. В этом случае количество информации, содержащейся в признаке о принадлежности объекта к классу является максимальным и равным количеству информации, вычисляемому по системной формуле Хартли (3.9).

Таким образом при взаимно-однозначном соответствии классов и признаков:

формула А.Харкевича (3.13) приобретает вид:

откуда:

или, учитывая выражение для коэффициента эмерджентности Хартли (3.8):

Смысл коэффициента эмерджентности Харкевича (3.25) проясняется, если учесть, что при количестве состояний системы W равном количеству фактов N о действии на эту систему различных факторов он равен 1. В этом случае факторы однозначно определяют состояния объекта управления, т.е. являются детерминистскими. Если же количество фактов N о действии на эту систему различных факторов превосходит количество ее состояний W, что является гораздо более типичным случаем, то этот коэффициент меньше 1. По-видимому, это означает, что в этом случае факторы как правило не однозначно (и не так жестко как детерминистские) определяют поведение объекта управления, т.е. являются статистическими.

Таким образом, коэффициент эмерджентности Харкевича

Y

изменяется от 0 до 1 и определяет степень детерминированности системы:

– Y=1

соответствует полностью детерминированной системе, поведение которой однозначно

определяется действием минимального количества факторов, которых столько же,

сколько состояний системы;

– Y=0

соответствует полностью случайной системе, поведение которой никак не зависит

действия факторов независимо от их количества;

– 0<Y<1

соответствуют большинству реальных систем поведение которых зависит от многих

факторов, число которых превосходит количество состояний системы, причем ни

одно из состояний не определяется однозначно никакими сочетаниями действующих

факторов.

Из выражения (3.25) видно, что в частном случае, когда реализуются только чистые состояния объекта управления, т.е. M=1, коэффициент эмерджентности А.Харкевича приобретает вид:

|

|

Подставив коэффициент эмерджентности А.Харкевича (3.25) в выражение (3.22), получим:

|

|

|

или окончательно:

Из вида выражения (3.25) для Y очевидно, что увеличение уровня системности влияет на семантическую информационную модель (3.28) аналогично повышению уровня детерминированности системы: понижение уровня системности, также как и степени детерминированности системы приводит к ослаблению влияния факторов на поведение системы, т.е. к понижению управляемости системы за счет своего рода "инфляции факторов".

Например: управлять толпой из 1000

человек значительно сложнее, чем воздушно-десантным полком той же численности.

Процесс превращения 1000 новобранцев в воздушно-десантный полк это и есть

процесс повышения уровня системности и степени детерминированности системы.

Этот процесс включает процесс иерархического структурирования (на отделения,

взвода, роты, батальоны), а также процесс повышения степени детерминированности

команд, путем повышения "степени беспрекословности" их исполнения.

Оркестр, настраивающий инструменты, также весьма существенно отличается от

оркестра, исполняющего произведение под управлением дирижера.

Необходимо отметить, что при повторном

использовании той же самой обучающей

выборки степень детерминированности модели уменьшается. Очевидно, с

формальной математической точки зрения этого явления можно избежать, если перед

расчетом информативностей признаков делить абсолютные частоты на количество

объектов обучающей выборки.

С использованием выражения (3.28) непосредственно из матрицы абсолютных частот (таблица 3.7) рассчитывается матрица информативностей (таблица 3.8), содержащая связи между факторами и будущими состояниями АОУ и имеющая много различных интерпретаций и играющая основополагающую роль в данном исследовании.

|

Таблица 3. 8 – МАТРИЦА ИНФОРМАТИВНОСТЕЙ |

|

|

Из рассмотрения основополагающего выражения (3.28) видно, что:

1. При выполнении условий взаимно-однозначного соответствия классов и признаков (3.23) первое слагаемое в выражении (3.28) обращается в ноль и при всех реальных значениях входящих в него переменных оно отрицательно.

2. Выражение (3.28) является нелинейной суперпозицией двух выражений: системного общения формулы Хартли (второе слагаемое), и первого слагаемого, которое имеет вид формулы Шеннона для плотности информации и отличается от него тем, что выражение под логарифмом находится в степени, которая совпадает с коэффициентом эмерджентности Харкевича, а также способом взаимосвязи входящих в него абсолютных частот с вероятностями.

Это

дает основание предположить, что первое слагаемое в выражении (3.28) является

одной из форм системного обобщения выражения Шеннона для плотности информации:

Поэтому вполне оправданным будет назвать степень в (3.29) коэффициентом эмерджентности Шеннона-Харкевича.

Генезис и интерпретации системной (эмерджентной) теории информации.

Полученное

системное обобщение формулы Харкевича (3.28) учитывает как взаимосвязь между

признаками (факторами) и будущими, в т.ч. целевыми состояниями объекта

управления, так и мощность множества будущих состояний объекта управления.

Кроме того она объединяет возможности интегрального и дискретного описания

объектов, учитывает уровень системности и степень детерминированности описываемой

системы (таблица 3.9):

|

Таблица 3. 9 – СООТВЕТСТВИЕ ТРЕБОВАНИЯМ ФОРМУЛ "КТИ / СТИ" |

|

|

При этом факторами являются управляющие

факторы, т.е. управления со стороны системы управления, факторы окружающей

среды, а также факторы, характеризующие текущее и прошлые состояния объекта

управления. Все это делает полученное выражение (3.28) оптимальным по

сформулированным критериям для целей построения содержательных информационных

моделей активных объектов управления и для применения для синтеза адаптивных

систем управления (см. диаграмму: "Генезис системного обобщения формулы

Харкевича для количества информации", рисунок 3.11).

|

|

|

Рисунок 3. 11. Генезис системной (эмерджентной) теории информации |

С точки зрения современной физики будущее существует ни менее объективно, чем настоящее, но в другом фазовом состоянии [30]. Причем в будущем одновременно сосуществуют состояния объектов и их сочетания, являющиеся альтернативными и несовместимыми в настоящем. Переход из будущего в настоящее связан с реализацией одной из альтернатив в процессе редукции волновой функции и имеет принципиально вероятностный характер. При этом происходит снятие неопределенности и передача соответствующего количества информации с виртуального уровня на физический, а также запись этой информации в структуре физической среды. В процессе редукции свободная информация многовариантного будущего преобразуется в связанную информацию физической структуры редуцированного объекта. В процессе записи этой информации в соответствии с ее содержанием и формируется эта структура редуцированной формы объекта.

Количество информации, содержащейся в будущем, не может быть рассчитано на основе классической теории информации (КТИ), т.к. само понятие информации в КТИ самым существенным образом основано на понятии классического объекта, который может находиться только в четко фиксированных "чистых" состояниях. В системной теории информации понятие информации обобщено путем учета возможности реализации "смешанных" состояний, являющихся суперпозицией или одновременной реализацией нескольких чистых состояний. Смешанное состояние может объединять 2, 3 и более чистых состояния. Параметр М в формулах, приведенных на рисунке 3.11, как раз и отражает сложность смешанных состояний. Это имеет смысл, т.к. в конкретных системах могут существовать различные правила запрета на возникновение тех или иных смешанных состояний, таким образом фактически может реализоваться значительно меньше смешанных состояний, чем формально возможно. При М=1 формулы СТИ в соответствии с принципом соответствия преобразуются в формулы КТИ.

Проведенный анализ позволяет выдвинуть гипотезу о том, что синтез и модификация структур в системах подчиняется обобщенному принципу, который предлагается назвать принципом Паули-Мопертюи:

"В любой системе каждый из ее элементов

принимает состояние, обеспечивающее максимум

информации в системе, как целом (Паули) при минимуме управляющего информационного воздействия на элемент со стороны

системы, как целого (Мопертюи)."

Этот принцип может играть роль правила

запрета при структурировании системы.

Некоторые примеры, иллюстрирующие предложенную гипотезу:

– фрактальные структуры (каждый элемент строится по тем же законам, что и все целое, часть подобна целому);

– живые организмы (в каждой в клетке содержится генетическая информация обо всем организме);

– квантовые структуры, в т.ч. редукция волновой функции, как информационный процесс синтеза физических структур;

– структуры иерархического управления (на каждом уровне управления руководитель знает и самостоятельно реализует свою задачу, направленную на достижение цели всей системы в целом);

– локальные и корпоративные компьютерные сети, Internet.

Итак, различные выражения классической теории информации для количества информации: Хартли, Шеннона и Харкевича учитывают различные аспекты информационного моделирования объектов.

Полученное системное обобщение формулы А.Харкевича (3.28) учитывает как

взаимосвязь между признаками (факторами) и будущими, в т.ч. целевыми

состояниями объекта управления, так и мощность множества будущих состояний.

Кроме того она объединяет возможности интегрального и дискретного описания

объектов, учитывает уровень системности и степень детерминированности системы.

При этом факторами являются управляющие факторы, т.е.

управления со стороны системы управления, факторы окружающей среды, а также

факторы, характеризующие текущее и прошлые состояния объекта управления. Все

это делает полученное выражение (3.28) оптимальным по сформулированным

критериям для целей построения содержательных информационных моделей активных

объектов управления и для применения для синтеза рефлексивных АСУ активными

объектами.